Hadoop是Apache旗下的一个用java语言实现开源软件框架,是一个开发和运行处理大规模数据的软件平台。

允许使用简单的编程模型在大量计算机集群上对大型数据集进行分布式处理。

今天先简单记录一下集群的搭建过程,以后再对各个比较重要的概念进行展开分析。

关注博主不迷路,获取更多干货资源

Hadoop官网

1 上传hadoop包

由于appache给出的hadoop的安装包没有提供带C程序访问的接口,所以我们在使用本地库(本地库可以用来做压缩,以及支持C程序等等)的时候就会出问题,需要对Hadoop源码包进行重新编译

具体怎么编译以后出一篇吧,今天有点忙,先记录下如何搭建集群吧,本文用的包是编译好的,可以从下面链接下载。

| 链接:https://pan.baidu.com/s/1oUyRaKbrhbfi2f6JHBKUIA

提取码:6666

复制这段内容后打开百度网盘手机App,操作更方便哦--来自百度网盘超级会员V3的分享

|

1.1 上传hadoop包

1.2 解压

| tar -zxvf hadoop-2.7.5.tar.gz -C /export/servers/

|

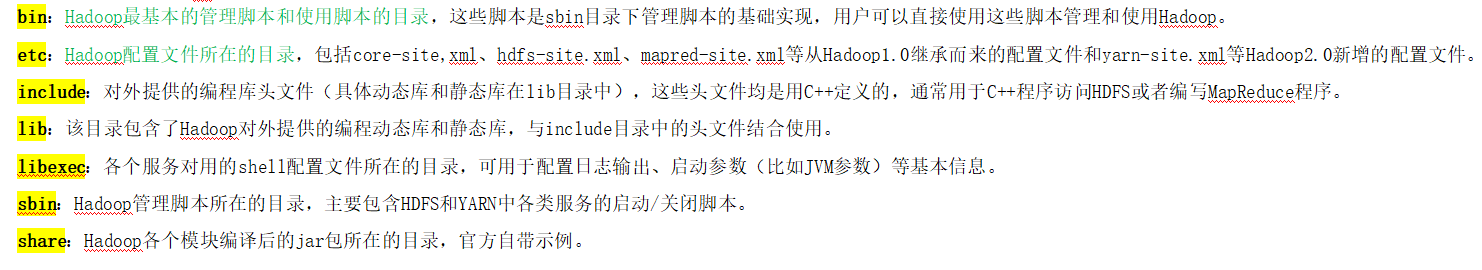

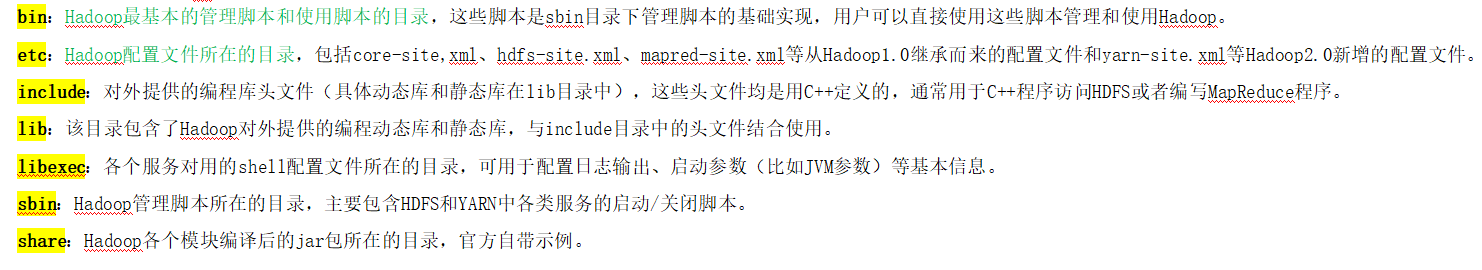

目录如下

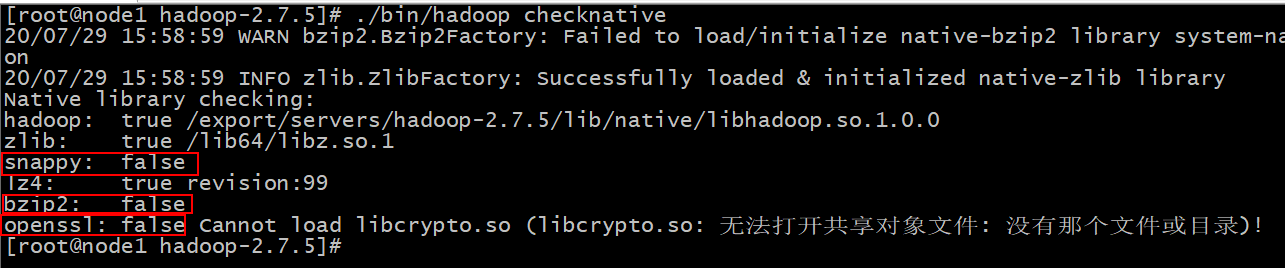

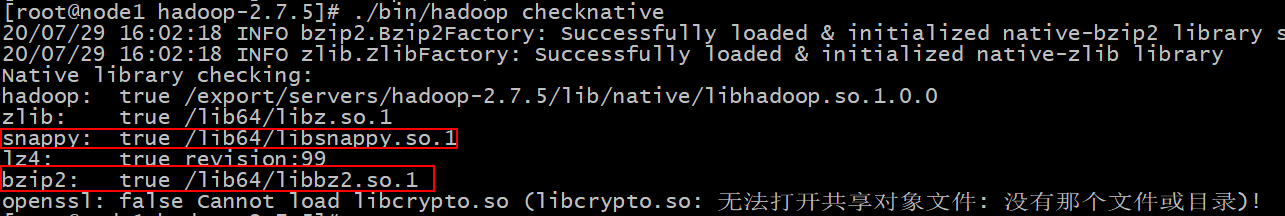

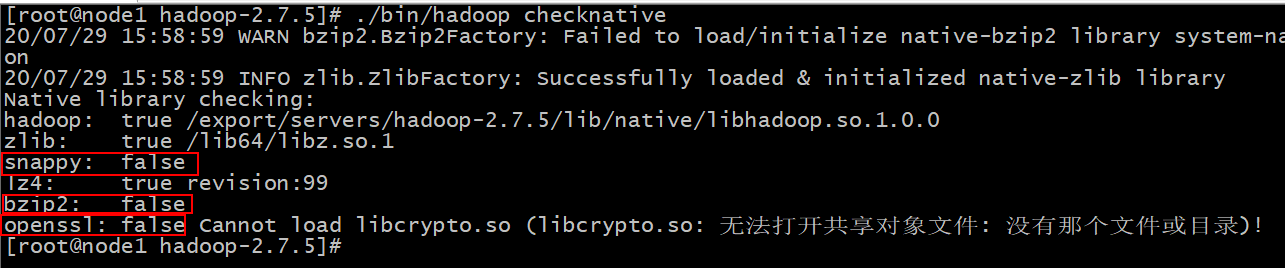

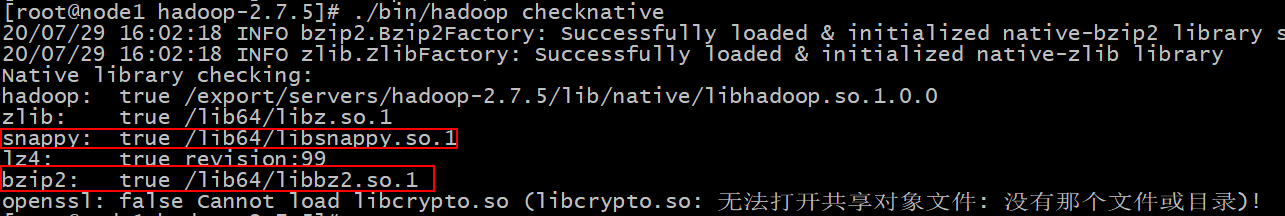

1.3 检查包是否编译成功

官方未编译版本如下,会发现, snappy 和 bzip2 都为false, 表示不支持

我们编译过的版本如下,会发现, snappy 和 bzip2 都为true, 表示支持

OpenSSL依然为false,安装一下就好

| yum -y install openssl-devel

|

2 Hadoop配置文件修改

在node1做如下修改

2.1 hadoop-env.sh

文件中设置的是Hadoop运行时需要的环境变量。JAVA_HOME是必须设置的,即使我们当前的系统中设置了JAVA_HOME,它也是不认识的,因为Hadoop即使是在本机上执行,它也是把当前的执行环境当成远程服务器。

| cd /export/servers/hadoop-2.7.5/etc/hadoop

vim hadoop-env.sh

|

添加以下内容:

| export JAVA_HOME=/export/servers/jdk1.8.0_241

|

2.2 core-site.xml

hadoop的核心配置文件,有默认的配置项core-default.xml。

core-default.xml与core-site.xml的功能是一样的,如果在core-site.xml里没有配置的属性,则会自动会获取core-default.xml里的相同属性的值。

在该文件中的标签中添加以下配置,

在这里添加配置

| cd /export/servers/hadoop-2.7.5/etc/hadoop

vim core-site.xml

|

配置内容如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

| <configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://node1:8020</value>

</property>

{user.name}

<property>

<name>hadoop.tmp.dir</name>

<value>/export/servers/hadoop-2.7.5/hadoopDatas/tempDatas</value>

</property>

<property>

<name>io.file.buffer.size</name>

<value>4096</value>

</property>

<property>

<name>fs.trash.interval</name>

<value>10080</value>

</property>

</configuration>

|

2.3 hdfs-site.xml

HDFS的核心配置文件,主要配置HDFS相关参数,有默认的配置项hdfs-default.xml。

hdfs-default.xml与hdfs-site.xml的功能是一样的,如果在hdfs-site.xml里没有配置的属性,则会自动会获取hdfs-default.xml里的相同属性的值。

在该文件中的标签中添加以下配置,

在这里添加配置

| cd /export/servers/hadoop-2.7.5/etc/hadoop

vim hdfs-site.xml

|

配置一下内容

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

| <configuration>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>node2:50090</value>

</property>

<property>

<name>dfs.namenode.http-address</name>

<value>node1:50070</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:///export/servers/hadoop-2.7.5/hadoopDatas/namenodeDatas</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:///export/servers/hadoop-2.7.5/hadoopDatas/datanodeDatas</value>

</property>

<property>

<name>dfs.namenode.edits.dir</name>

<value>file:///export/servers/hadoop-2.7.5/hadoopDatas/nn/edits</value>

</property>

<property>

<name>dfs.namenode.checkpoint.dir</name>

<value>file:///export/servers/hadoop-2.7.5/hadoopDatas/snn/name</value>

</property>

<property>

<name>dfs.namenode.checkpoint.edits.dir</name>

<value>file:///export/servers/hadoop-2.7.5/hadoopDatas/dfs/snn/edits</value>

</property>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

<property>

<name>dfs.blocksize</name>

<value>134217728</value>

</property>

<property>

<name>dfs.hosts</name>

<value>/export/servers/hadoop-2.7.5/etc/hadoop/slaves</value>

</property>

</configuration>

|

2.4 mapred-site.xml

MapReduce的核心配置文件,Hadoop默认只有个模板文件mapred-site.xml.template,需要使用该文件复制出来一份mapred-site.xml文件

| cd /export/servers/hadoop-2.7.5/etc/hadoop

cp mapred-site.xml.template mapred-site.xml

|

在mapred-site.xml文件中的标签中添加以下配置,

在这里添加配置

配置一下内容:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

| <configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.job.ubertask.enable</name>

<value>true</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>node1:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>node1:19888</value>

</property>

</configuration>

|

2.5 mapred-env.sh

在该文件中需要指定JAVA_HOME,将原文件的JAVA_HOME配置前边的注释去掉,然后按照以下方式修改:

| cd /export/servers/hadoop-2.7.5/etc/hadoop

vim mapred-env.sh

|

| export JAVA_HOME=/export/servers/jdk1.8.0_241

|

2.6 yarn-site.xml

ARN的核心配置文件,在该文件中的标签中添加以下配置,

在这里添加配置

| cd /export/servers/hadoop-2.7.5/etc/hadoop

vim yarn-site.xml

|

添加以下配置:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

| <configuration>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>node1</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

<property>

<name>yarn.nodemanager.resource.memory-mb</name>

<value>20480</value>

</property>

<property>

<name>yarn.scheduler.minimum-allocation-mb</name>

<value>2048</value>

</property>

<property>

<name>yarn.nodemanager.vmem-pmem-ratio</name>

<value>2.1</value>

</property>

</configuration>

|

2.7 slaves

slaves文件里面记录的是集群主机名。一般有以下两种作用:

一是:配合一键启动脚本如start-dfs.sh、stop-yarn.sh用来进行集群启动。这时候slaves文件里面的主机标记的就是从节点角色所在的机器。

二是:可以配合hdfs-site.xml里面dfs.hosts属性形成一种白名单机制。

dfs.hosts指定一个文件,其中包含允许连接到NameNode的主机列表。必须指定文件的完整路径名,那么所有在slaves中的主机才可以加入的集群中。如果值为空,则允许所有主机。

| cd /export/servers/hadoop-2.7.5/etc/hadoop

vim slaves

|

删除slaves中的localhost,然后添加以下内容:

3 数据目录创建和文件分发

注意,以下所有操作都在node1主机进行

3.1 目录创建

创建Hadoop所需目录

| mkdir -p /export/servers/hadoop-2.7.5/hadoopDatas/tempDatas

mkdir -p /export/servers/hadoop-2.7.5/hadoopDatas/namenodeDatas

mkdir -p /export/servers/hadoop-2.7.5/hadoopDatas/datanodeDatas

mkdir -p /export/servers/hadoop-2.7.5/hadoopDatas/nn/edits

mkdir -p /export/servers/hadoop-2.7.5/hadoopDatas/snn/name

mkdir -p /export/servers/hadoop-2.7.5/hadoopDatas/dfs/snn/edits

|

3.2 文件分发

将配置好的Hadoop目录分发到node2和node3主机。

| scp -r /export/servers/hadoop-2.7.5/ node2:/export/servers/

scp -r /export/servers/hadoop-2.7.5/ node3:/export/servers/

|

4 配置Hadoop的环境变量

注意,三台机器都需要执行以下命令

添加以下内容:

| export HADOOP_HOME=/export/server/hadoop-2.7.5

export PATH=:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

|

配置完成之后生效

测试

5 启动集群(下面命令都在sbin下)

5.1 启动前需要格式化

要启动Hadoop集群,需要启动HDFS和YARN两个集群。

注意:首次启动HDFS时,必须对其进行格式化操作。本质上是一些清理和准备工作,因为此时的HDFS在物理上还是不存在的。

在node1上执行格式化指令

5.2 单节点逐个启动

在node1主机上使用以下命令启动HDFS NameNode:

| hadoop-daemon.sh start namenode

|

在node1、node2、node3三台主机上,分别使用以下命令启动HDFS DataNode:

| hadoop-daemon.sh start datanode

|

在node1主机上使用以下命令启动YARN ResourceManager:

| yarn-daemon.sh start resourcemanager

|

在node1、node2、node3三台主机上使用以下命令启动YARN nodemanager:

| yarn-daemon.sh start nodemanager

|

在node2上启动 secondarynamenode

| hadoop-daemon.sh start secondarynamenode

|

以上脚本位于/export/server/hadoop-2.7.5/sbin目录下。如果想要停止某个节点上某个角色,只需要把命令中的start改为stop即可。

5.3 脚本一键启动

启动HDFS

启动Yarn

启动历史任务服务进程

| mr-jobhistory-daemon.sh start historyserver

|

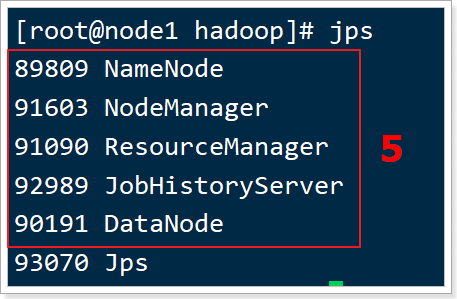

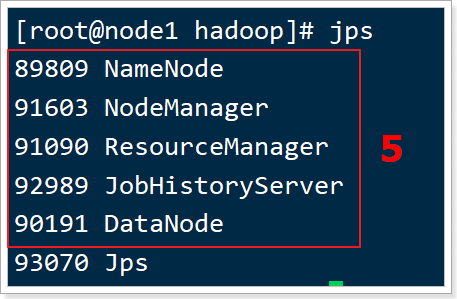

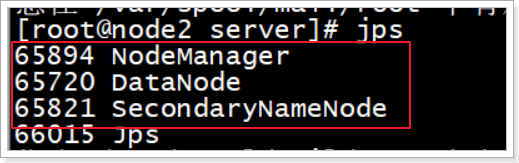

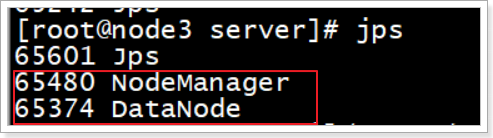

启动之后,使用jps命令查看相关服务是否启动,jps是显示Java相关的进程命令。

node1:

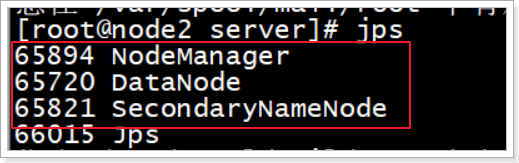

node2:

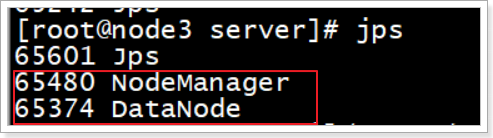

node3:

停止集群

| stop-dfs.sh

stop-yarn.sh

mr-jobhistory-daemon.sh stop historyserver

|

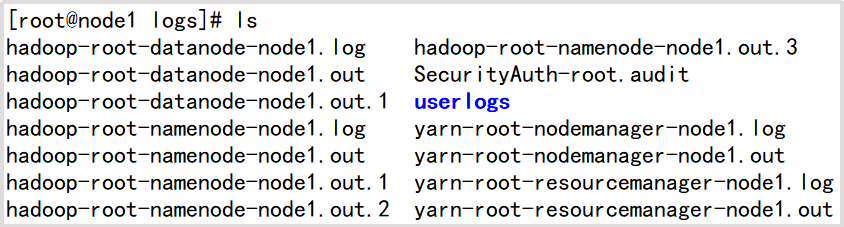

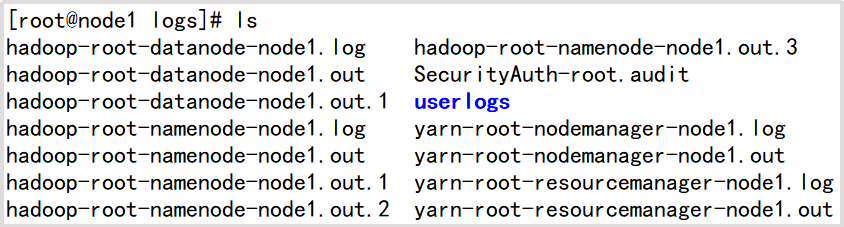

注意:如果在启动之后,有些服务没有启动成功,则需要查看启动日志,Hadoop的启动日志在每台主机的/export/server/hadoop-2.7.5/logs/目录,需要根据哪台主机的哪个服务启动情况去对应的主机上查看相应的日志,以下是node1主机的日志目录.

5.4 一键启动(平时用这个就好了)

| start-all.sh

mr-jobhistory-daemon.sh start historyserver

|

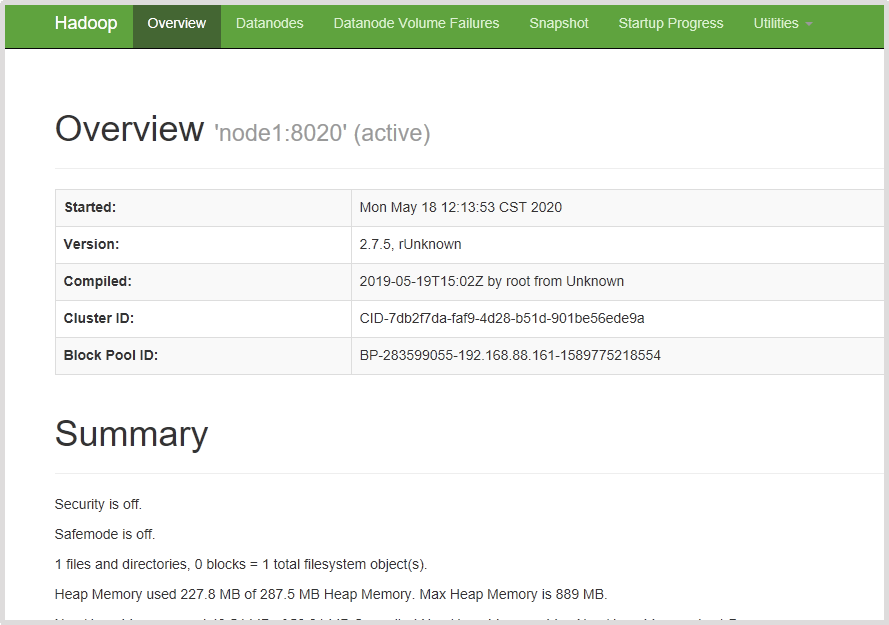

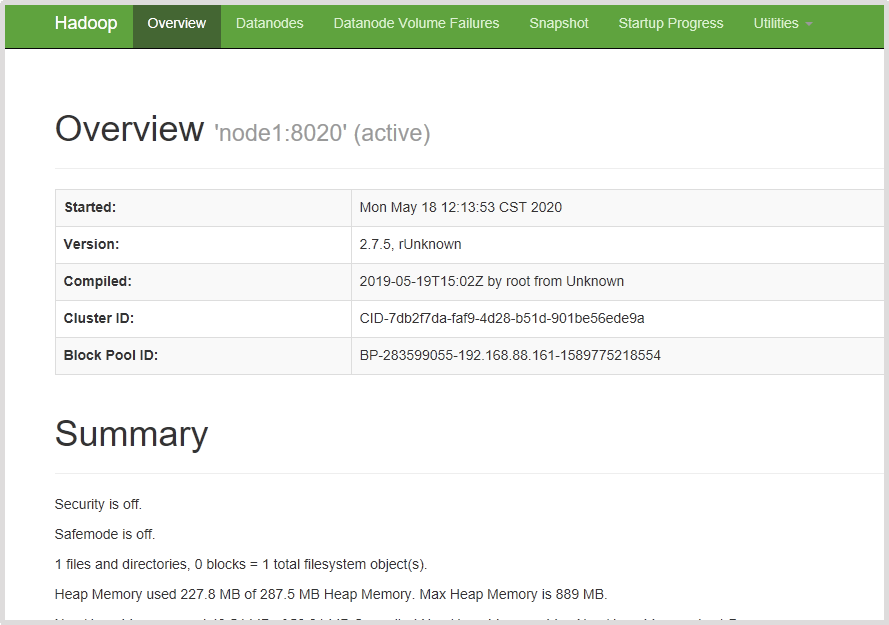

6 集群的页面访问

6.1 IP访问

一旦Hadoop集群启动并运行,可以通过web-ui进行集群查看,如下所述:

查看NameNode页面地址:

| http://192.168.88.161:50070/

|

查看Yarn集群页面地址:

| http://192.168.88.161:8088/cluster

|

查看MapReduce历史任务页面地址:

| http://192.168.88.161:19888/jobhistory

|

6.2 主机名访问

请注意,以上的访问地址只能使用IP地址,如果想要使用主机名,则对Windows进行配置。

配置方式:

- 打开Windows的C:\Windows\System32\drivers\etc目录下hosts文件

- 在hosts文件中添加以下域名映射

| 192.168.88.161 node1 node1.itcast.cn

192.168.88.162 node2 node2.itcast.cn

192.168.88.163 node3 node3.itcast.cn

|

配置完之后,可以将以上地址中的IP替换为主机名即可访问,如果还不能访问,则需要重启Windows电脑,比如访问NameNode,可以使用http://node1:50070/ 。

7 Hadoop初体验

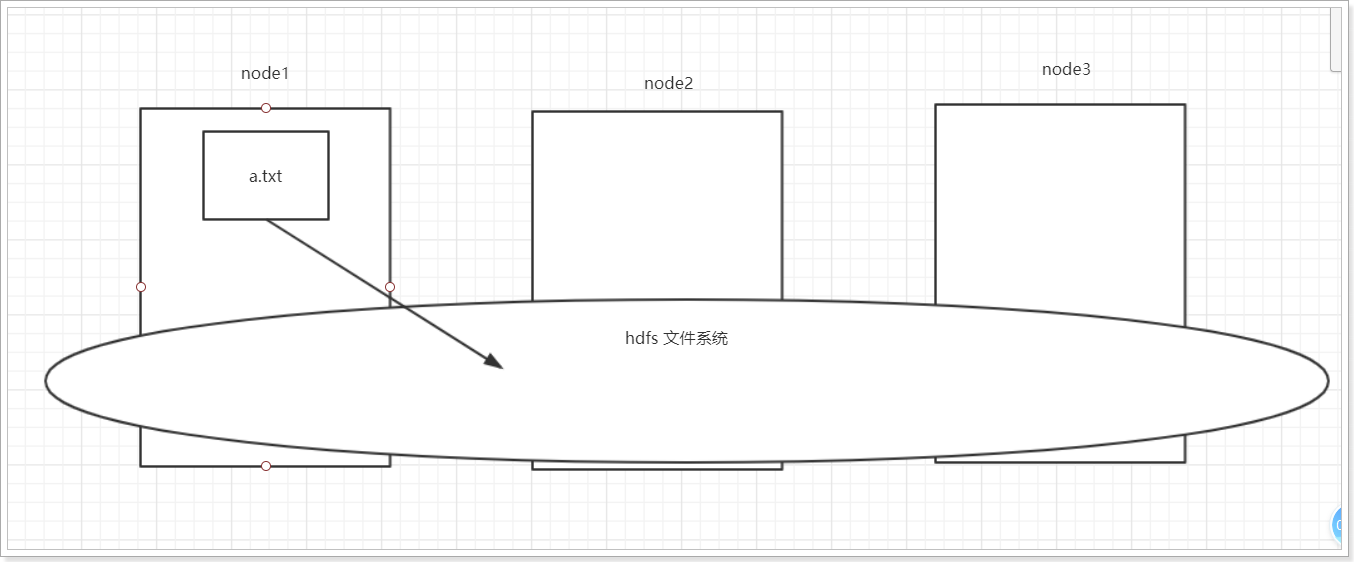

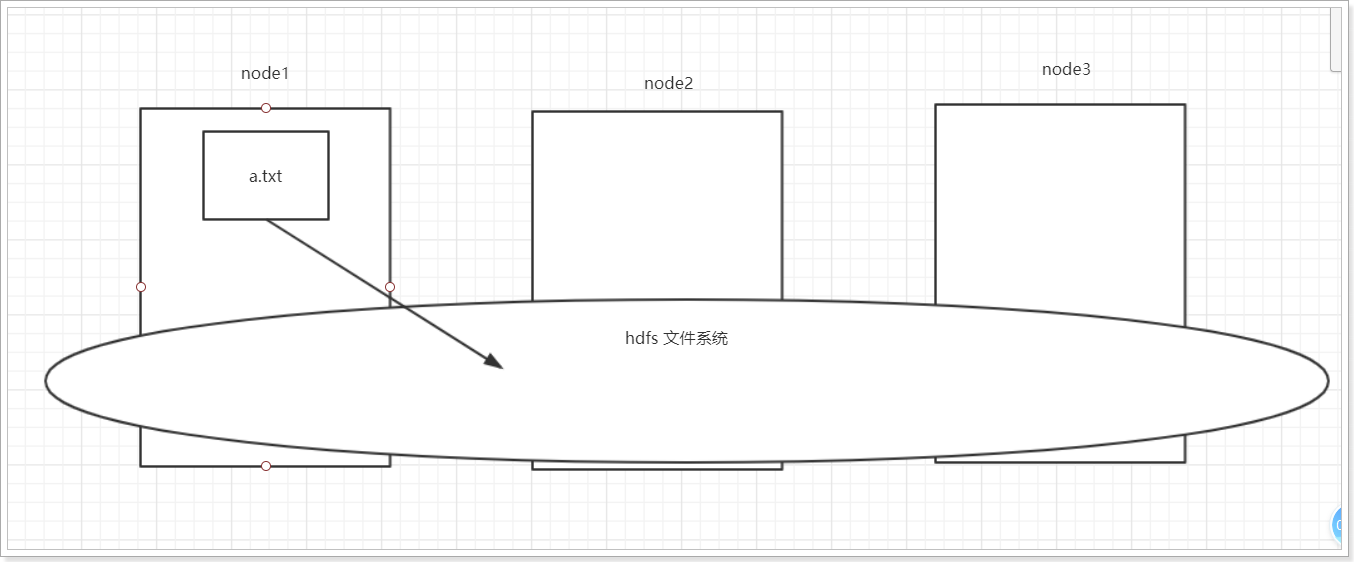

7.1 HDFS使用

- 从Linux本地上传一个文本文件到hdfs的/目录下

|

cd /export/data/

touch a.txt

echo "hello" > a.txt

hadoop fs -put a.txt /

|

- 通过页面查看

通过NameNode页面.进入HDFS:http://node1:50070/

查看文件是否创建成功.

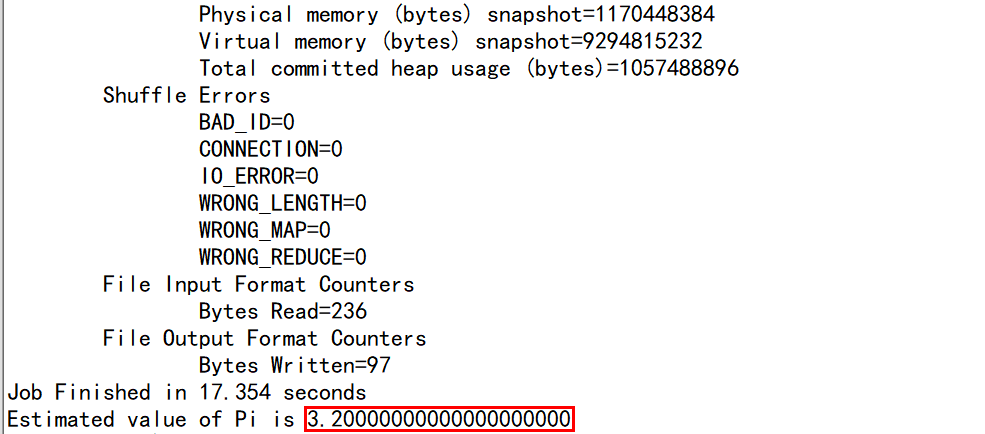

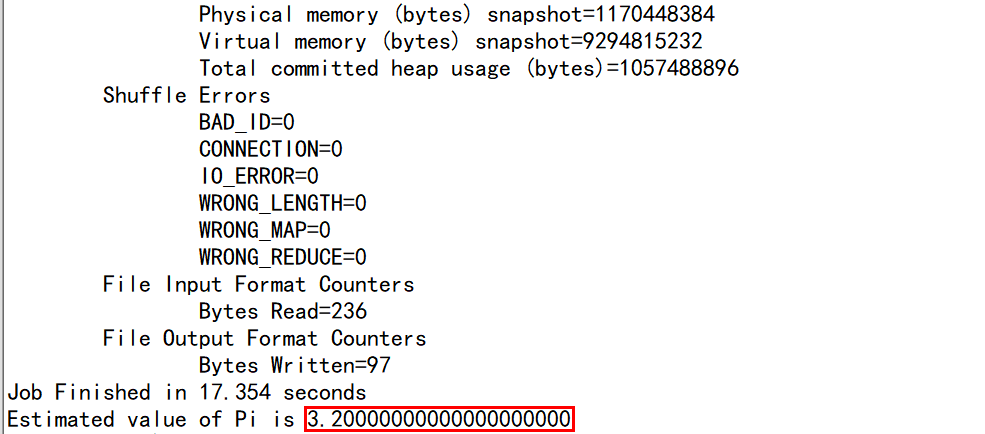

7.2 运行mapreduce程序

在Hadoop安装包的share/hadoop/mapreduce下有官方自带的mapreduce程序。我们可以使用如下的命令进行运行测试。

示例程序jar:

hadoop-mapreduce-examples-2.7.5.jar

计算圆周率

| hadoop jar

/export/servers/hadoop-2.7.5/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.5.jar

pi 2 50

|

关于圆周率的估算,感兴趣的可以查询资料蒙特卡洛方法来计算Pi值,计算命令中2表示计算的线程数,50表示投点数,该值越大,则计算的pi值越准确。

关注博主不迷路