Apache Spark是一个用于大规模数据处理的统一分析引擎。

它提供了Java、Scala、Python和R的高级api,以及支持通用执行图的优化引擎。

它还支持一组丰富的高级工具,包括用于SQL和结构化数据处理的Spark SQL,用于机器学习的MLlib,用于图形处理的GraphX,以及用于增量计算和流处理的结构化流。

关注博主不迷路,获取更多干货资源

1 Spark概述

官网:http://spark.apache.org/ https://databricks.com/spark/about

Spark 是加州大学伯克利分校AMP实验室(Algorithms Machines and People Lab)开发的通用大数据出来框架。Spark生态栈也称为BDAS,是伯克利AMP实验室所开发的,力图在算法(Algorithms)、机器(Machines)和人(Person)三种之间通过大规模集成来展现大数据应用的一个开源平台。AMP实验室运用大数据、云计算等各种资源以及各种灵活的技术方案,对海量数据进行分析并转化为有用的信息,让人们更好地了解世界。

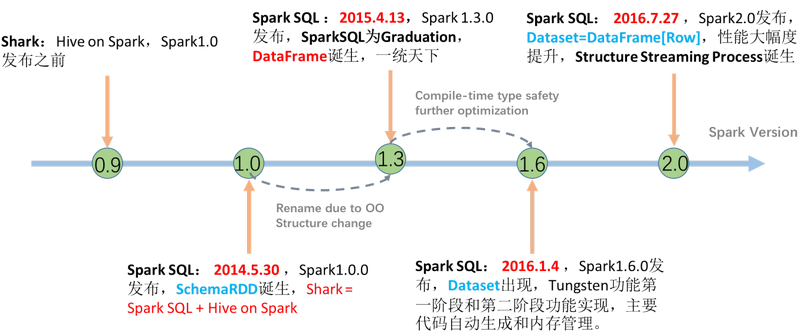

Spark的发展历史,经历过几大重要阶段,如下图所示:

Spark 是一种快速、通用、可扩展的大数据分析引擎,2009 年诞生于加州大学伯克利分校 AMPLab,2010 年开源, 2013年6月成为Apache孵化项目,2014年2月成为 Apache 顶级项目,用 Scala进行编写项目框架。

1.1 Spark是什么

Apache Spark是用于大规模数据(large-scala data)处理的统一(unified)分析引擎。

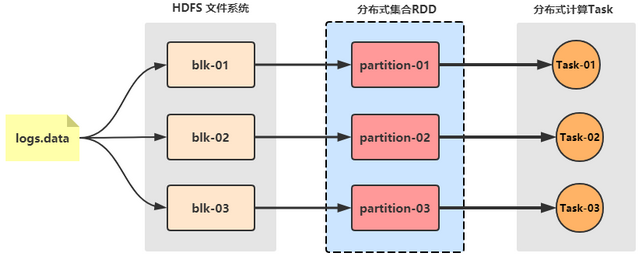

Spark 最早源于一篇论文 Resilient Distributed Datasets: A Fault-Tolerant Abstraction for In-Memory Cluster Computing,该论文是由加州大学柏克莱分校的 Matei Zaharia 等人发表的。论文中提出了一种弹性分布式数据集(即 RDD)的概念,原文开头对其的解释是:

翻译过来就是:RDD 是一种分布式内存抽象,其使得程序员能够在大规模集群中做内存运算,并且有一定的容错方式。而这也是整个 Spark 的核心数据结构,Spark 整个平台都围绕着RDD进行。

1.2 Spark四大特点

Spark 使用Scala语言进行实现,它是一种面向对、函数式编程语言,能够像操作本地集合一样轻松的操作分布式数据集。Spark具有运行速度快、易用性好、通用性强和随处运行等特点。

1.2.1 速度快

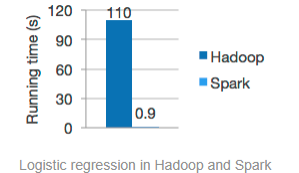

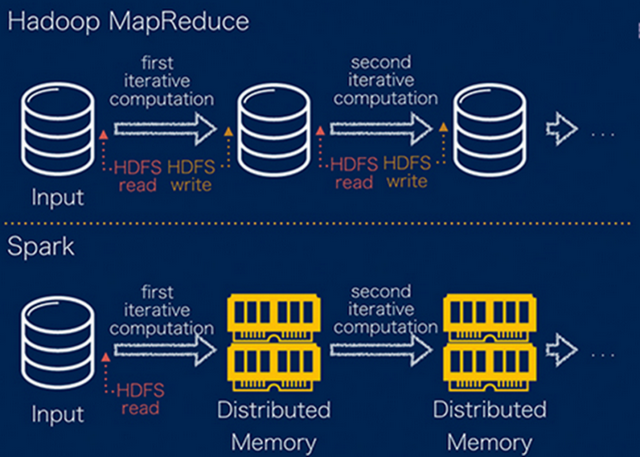

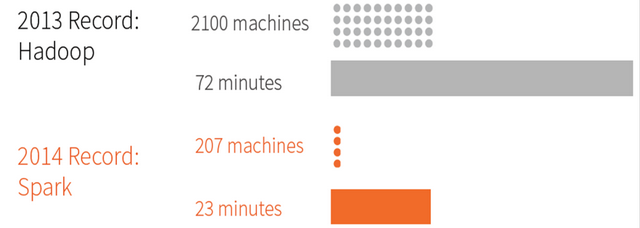

由于Apache Spark支持内存计算,并且通过DAG(有向无环图)执行引擎支持无环数据流,所以官方宣称其在内存中的运算速度要比Hadoop的MapReduce快100倍,在硬盘中要快10倍。

Spark处理数据与MapReduce处理数据相比,有如下两个不同点:

其一、Spark处理数据时,可以将中间处理结果数据存储到内存中;

其二、Spark Job调度以DAG方式,并且每个任务Task执行以线程(Thread)方式,并不是像MapReduce以进程(Process)方式执行。

2014 年的如此Benchmark测试中,Spark 秒杀Hadoop,在使用十分之一计算资源的情况下,相同数据的排序上,Spark 比Map Reduce快3倍!

1.2.2 易于使用

Spark 的版本已经更新到 Spark 2.4.5(截止日期2020.05.01),支持了包括 Java、Scala、Python 、R和SQL语言在内的多种语言。

1.2.3 通用性强

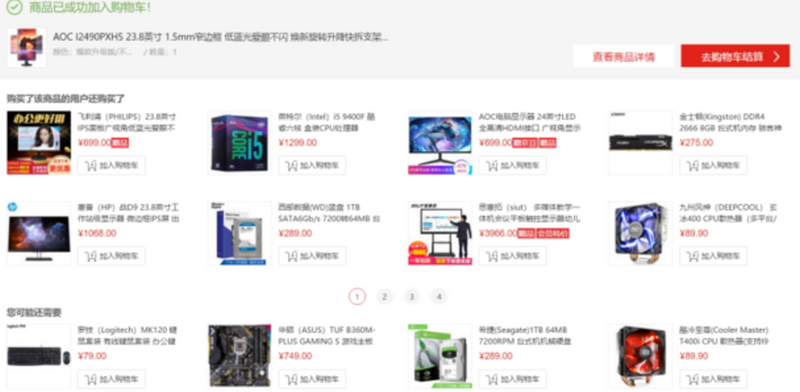

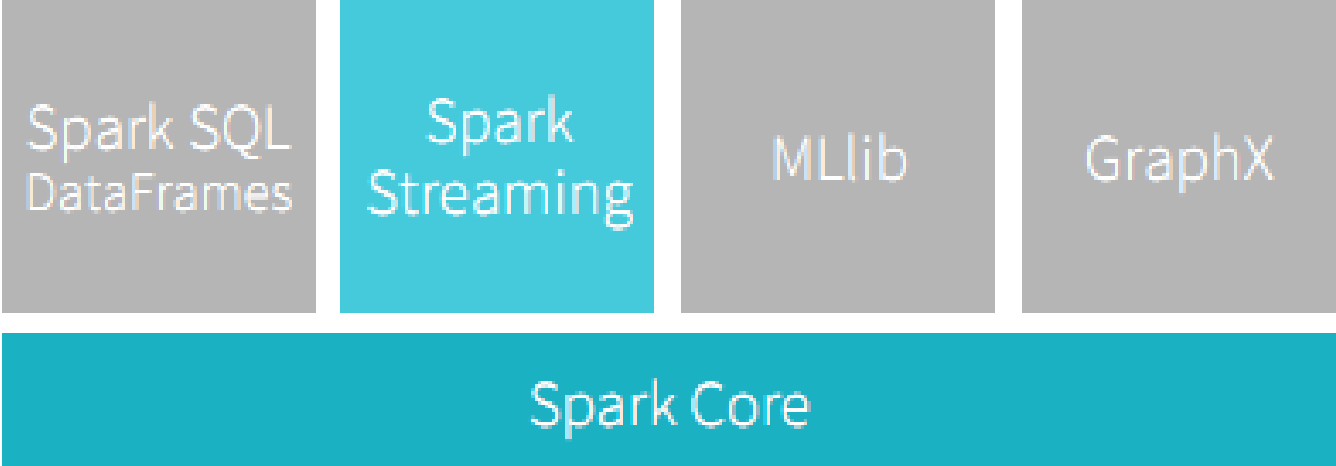

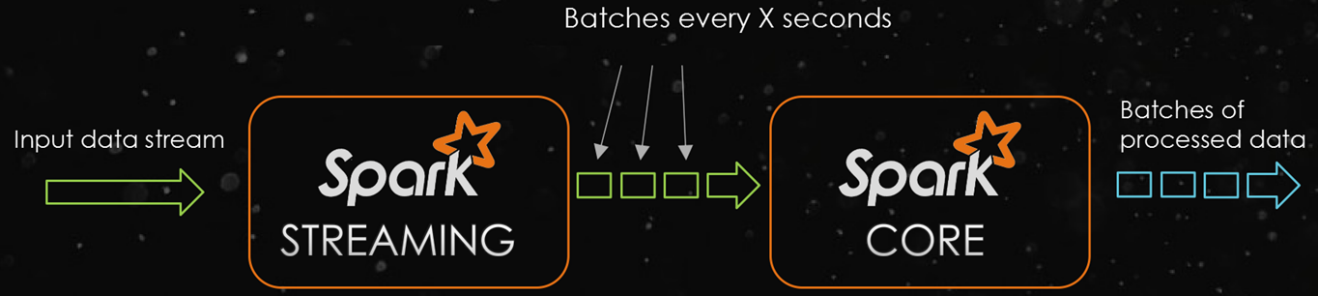

在 Spark 的基础上,Spark 还提供了包括Spark SQL、Spark Streaming、MLib 及GraphX在内的多个工具库,我们可以在一个应用中无缝地使用这些工具库。其中,Spark SQL 提供了结构化的数据处理方式,Spark Streaming 主要针对流式处理任务(也是本书的重点),MLlib提供了很多有用的机器学习算法库,GraphX提供图形和图形并行化计算。

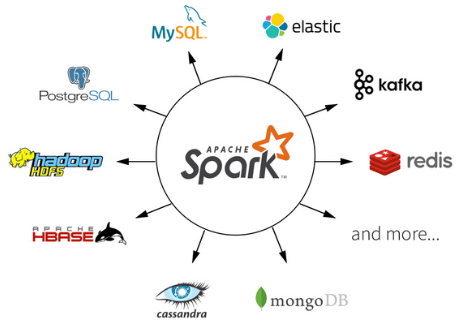

1.2.4 运行方式

Spark 支持多种运行方式,包括在 Hadoop 和 Mesos 上,也支持 Standalone的独立运行模式,同时也可以运行在云Kubernetes(Spark 2.3开始支持)上。

对于数据源而言,Spark 支持从HDFS、HBase、Cassandra 及 Kafka 等多种途径获取数据。

2 Spark环境搭建 2.1 Local 2.1.1 安装包下载

目前Spark最新稳定版本:2.4.x系列,官方推荐使用的版本,也是目前企业中使用较多版本,网址:

https://github.com/apache/spark/releases http://spark.apache.org/downloads.html http://archive.apache.org/dist/spark/spark-2.4.5/

Spark 2.4.x依赖其他语言版本如下,其中既支持Scala 2.11,也支持Scala 2.12,推荐使用2.11。

2.1.2 Spark安装

将spark安装包【spark-2.4.5-bin-hadoop2.7.tgz】解压至【/export/servers/】目录:

tar -zxvf spark-2 .4 .5 -bin-hadoop2 .7 .tgzln -s /export/servers//spark-2 .4 .5 -bin-hadoop2 .7 /export/servers//sparkchown -R root /export/servers//spark-2 .4 .5 -bin-hadoop2 .7 chgrp -R root /export/servers//spark-2 .4 .5 -bin-hadoop2 .7

其中各个目录含义如下:

bin 可执行脚本jars 依赖 jar 包sbin 集群管理命令

2.1.3 运行spark-shell

开箱即用

直接启动bin目录下的spark-shell:

## 进入Spark安装目录export /servers2 ]

spark-shell说明

1.直接使用./spark-shell

表示使用local 模式启动,在本机启动一个SparkSubmit进程

2.还可指定参数 –master,如:

spark-shell –master local[N] 表示在本地模拟N个线程来运行当前任务

3.不携带参数默认就是

spark-shell –master local[*]

4.后续还可以使用–master指定集群地址,表示把任务提交到集群上运行,如

./spark-shell –master spark://node01:7077,node02:7077

5.退出spark-shell

使用 :quit

本地模式启动spark-shell:

其中

创建SparkContext实例对象:scSparkSession实例对象:spark启动应用监控页面端口号:4040

2.1.4 初体验-读取本地文件

1:准备数据

vim /root/words .txtme you her

2:执行下面代码

val textFile = sc.textFile("file:///root/words.txt" ) val counts = textFile.flatMap(_ .split (" " ) ).map((_,1 )).reduceByKey(_ + _ )

2.1.5 初体验-读取HDFS文件

准备数据

上传文件到hdfs

hadoop fs -put /root/ words.txt /wordcount/i nput/words.txt

目录如果不存在可以创建

hadoop fs -mkdir -p /wordcount/i nput

结束后可以删除测试文件夹

hadoop fs -rm -r /wordcount

val textFile = sc.textFile("hdfs://node1:8020/wordcount/input/words.txt" ) val counts = textFile.flatMap(_ .split (" " ) ).map((_,1 )).reduceByKey(_ + _ ) AsTextFile("hdfs://node1:8020/wordcount/output" )

查看文件内容

hadoop fs -text /wordcount/ output/part*

2.1.6 监控页面

每个Spark Application应用运行时,启动WEB UI监控页面,默认端口号为4040,可以使用浏览器打开页面,

http://node1:4040/jobs/

2.2 Standalone

Standalone模式是Spark自带的一种集群模式,不同于前面本地模式启动多个进程来模拟集群的环境,Standalone模式是真实地在多个机器之间搭建Spark集群的环境,完全可以利用该模式搭建多机器集群,用于实际的大数据处理。

2.2.1 Standalone架构

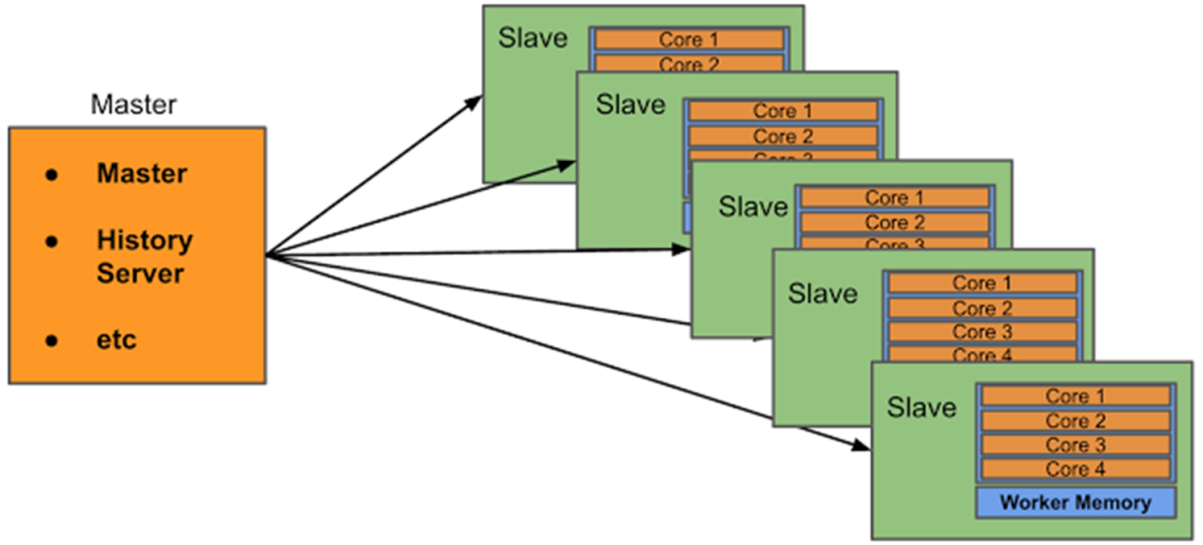

Standalone集群使用了分布式计算中的master-slave模型,master是集群中含有Master进程的节点,slave是集群中的Worker节点含有Executor进程。

http://spark.apache.org/docs/latest/cluster-overview.html

Spark Standalone集群,类似Hadoop YARN,管理集群资源和调度资源:

主节点Master:

管理整个集群资源,接收提交应用,分配资源给每个应用,运行Task任务

从节点Workers:

管理每个机器的资源,分配对应的资源来运行Task;

历史服务器HistoryServer:

Spark Application运行完成以后,保存事件日志数据至HDFS,启动HistoryServer可以查看应用运行相关信息。

2.2.2 集群规划

Standalone集群安装服务规划与资源配置:

node01:master slave /worker slave /worker

官方文档:http://spark.apache.org/docs/2.4.5/spark-standalone.html

2.2.3 修改配置

修改slaves

## 进入配置目录export /servers

修改spark-env.sh

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 ## 进入配置目录export /serversexport /serversexport /serversexport SPARK_MASTER_HOST=node1export SPARK_MASTER_PORT=7077 8080 1 1 g"-Dspark.history.fs.logDirectory=hdfs://node1:8020/sparklog/ -Dspark.history.fs.cleaner.enabled=true"

增加如下内容:

注意:sparklog需要手动创建

hadoop fs -mkdir -p /sparklog

配置Spark应用保存sparklog

/export/ servers// spark/conf// node1:8020 /sparklog/ 18080

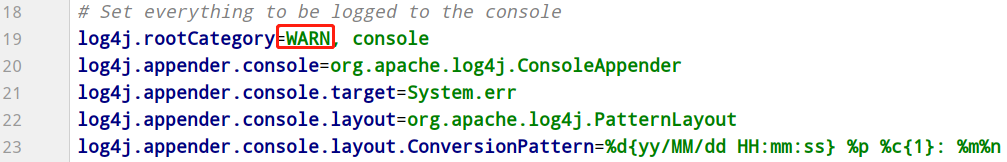

设置日志级别

## 进入目录export /servers

2.2.4 分发到其他服务器

将配置好的将 Spark 安装包分发给集群中其它机器,命令如下:

cd /export/servers//scp -r spark-2 .4 .5 -bin-hadoop2 .7 root@node2 :$PWDscp -r spark-2 .4 .5 -bin-hadoop2 .7 root@node3 :$PWDln -s /export/servers//spark-2 .4 .5 -bin-hadoop2 .7 /export/servers//spark

2.2.5 启动服务进程

集群启动和停止

在主节点上启动spark集群/export/ servers// spark/sbin/ start-all.sh/export/ servers// spark/sbin/ stop-all.sh

单独启动和停止

在 master 安装节点上启动和停止 master :start -master .shstop -master .shMaster 所在节点上启动和停止worker (work指的是slaves 配置文件中的主机名)start -slaves.shstop -slaves.sh

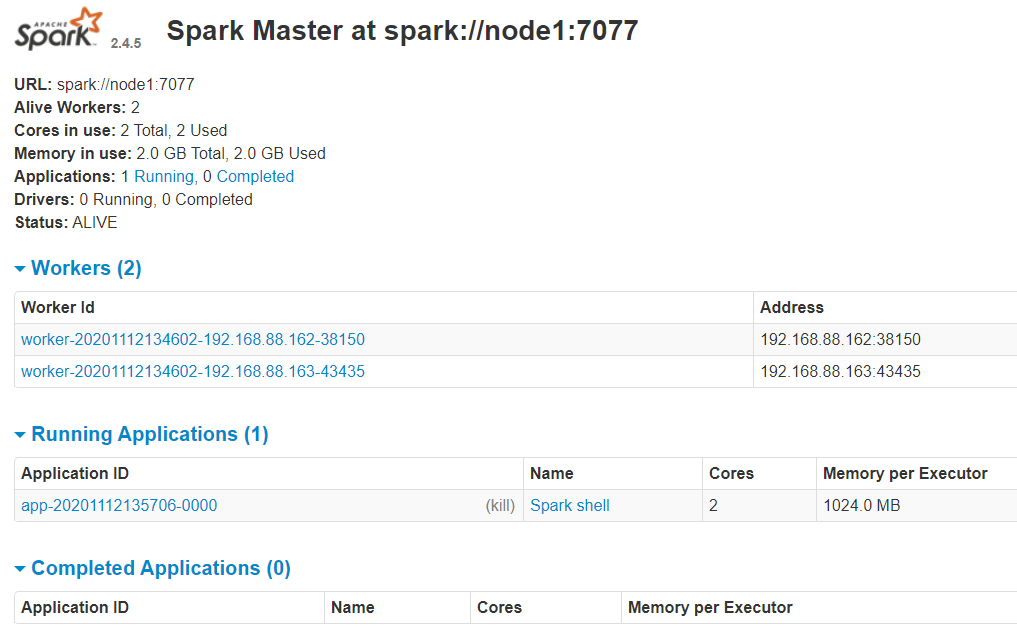

WEB UI页面

http://node1:8080/

历史服务器HistoryServer:

/export/ servers// spark/sbin/ start-history-server.sh

WEB UI页面地址:

http://node1:18080/

2.2.6 测试 /export/ servers// spark/bin/ spark-shell --master spark:// node1:7077

运行程序

sc.textFile("hdfs://node1:8020/wordcount/input/words.txt" ) Map(_ .split (" " ) ).map((_, 1 )).reduceByKey(_ + _ ) AsTextFile("hdfs://node1:8020/wordcount/output2" )

hadoop fs -text /wordcount/ output2/part*

注意

集群模式下程序是在集群上运行的,不要直接读取本地文件,应该读取hdfs上的

SparkContext web UI

http://node1:4040/jobs/

查看Master主节点WEB UI界面:

http://node1:8080/

查看历史服务器

http://node1:18080/

2.2.7 Spark 应用架构-了解 2.2.7.1 Driver和Executors

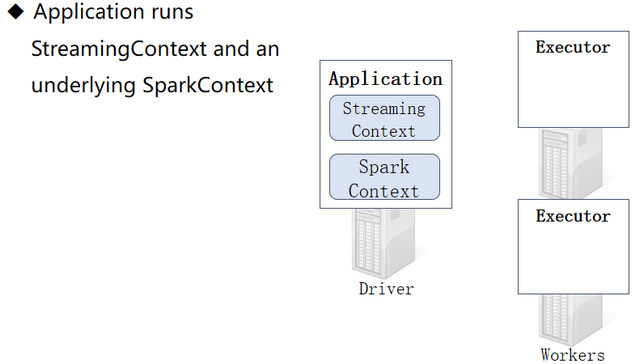

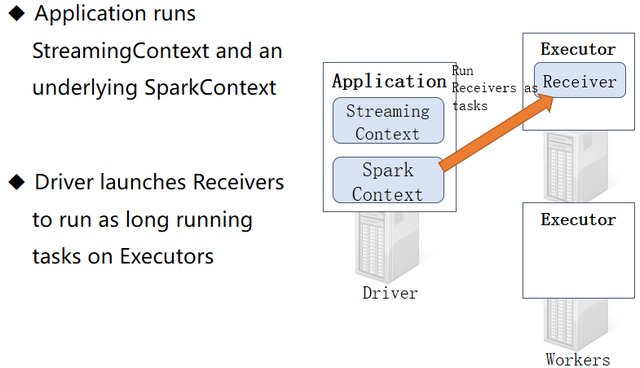

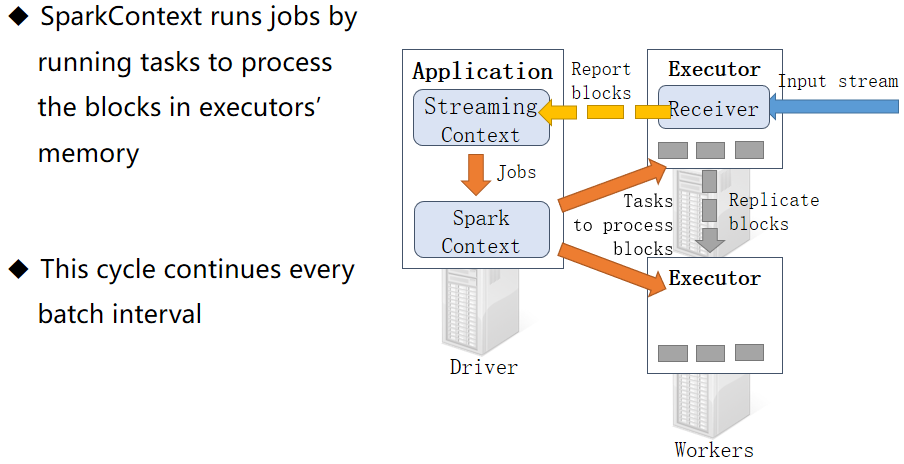

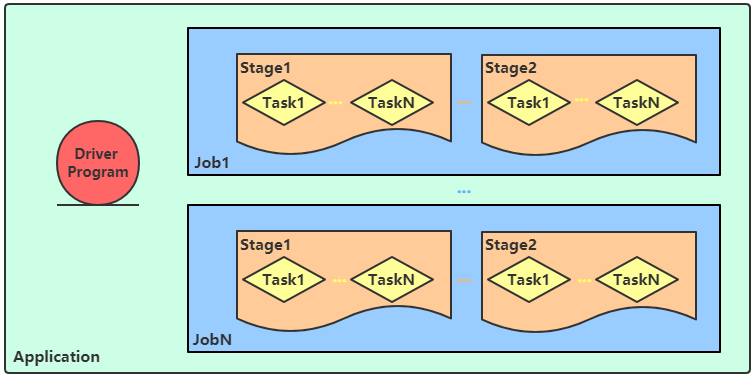

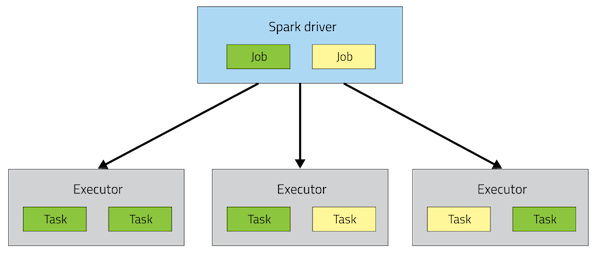

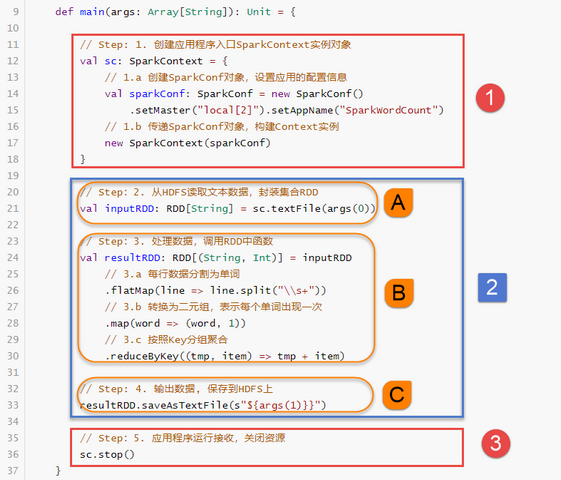

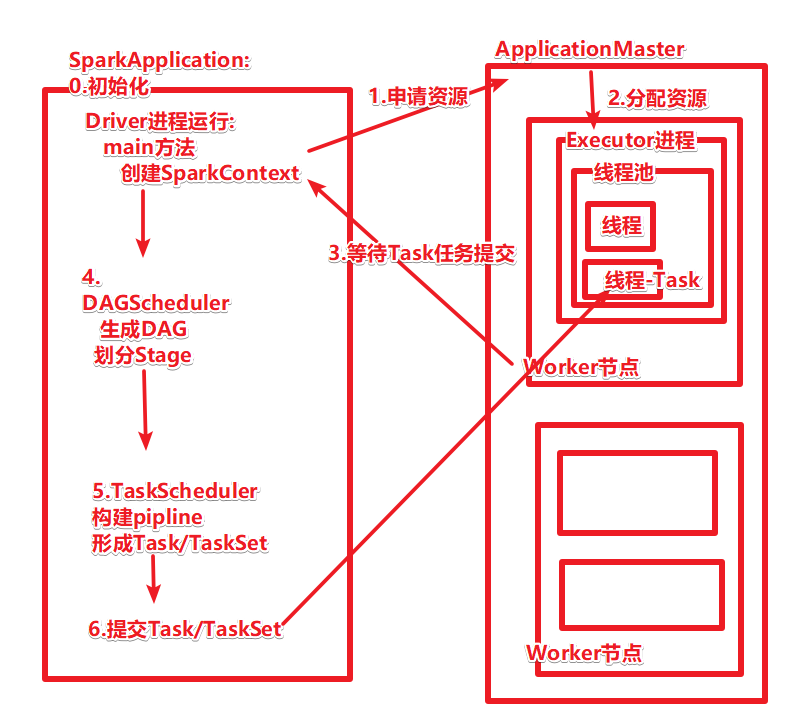

从图中可以看到Spark Application运行到集群上时,由两部分组成:Driver Program和Executors。

第一、Driver Program

相当于AppMaster,整个应用管理者,负责应用中所有Job的调度执行;

第二、Executors

相当于一个线程池,运行JVM Process,其中有很多线程,每个线程运行一个Task任务,一个Task运行需要1 Core CPU,所有可以认为Executor中线程数就等于CPU Core核数;

Driver Program是用户编写的数据处理逻辑,这个逻辑中包含用户创建的SparkContext。SparkContext 是用户逻辑与Spark集群主要的交互接口,它会和Cluster Manager交互,包括向它申请计算资源等。 Cluster Manager负责集群的资源管理和调度,现在支持Standalone、Apache Mesos和Hadoop的 YARN。Worker Node是集群中可以执行计算任务的节点。 Executor是在一个Worker Node上为某应用启动的一个进程,该进程负责运行任务,并且负责将数据存在内存或者磁盘上。Task 是被送到某个Executor上的计算单元,每个应用都有各自独立的 Executor,计算最终在计算节点的 Executor中执行。

用户程序从最开始的提交到最终的计算执行,需要经历以下几个阶段:

1)、用户程序创建 SparkContext 时,新创建的 SparkContext 实例会连接到 ClusterManager。 Cluster Manager 会根据用户提交时设置的 CPU 和内存等信息为本次提交分配计算资源,启动 Executor。

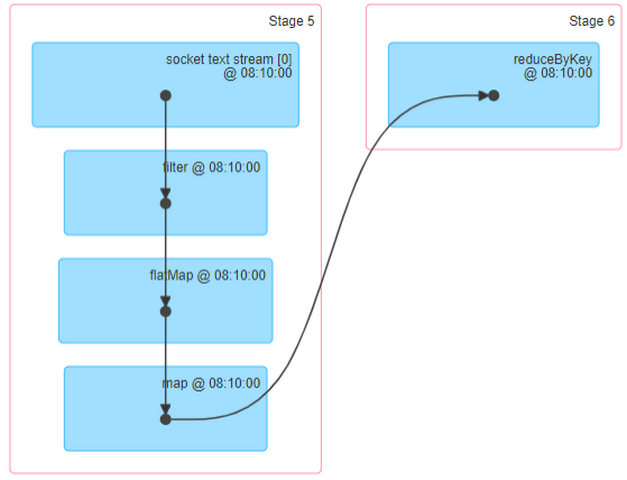

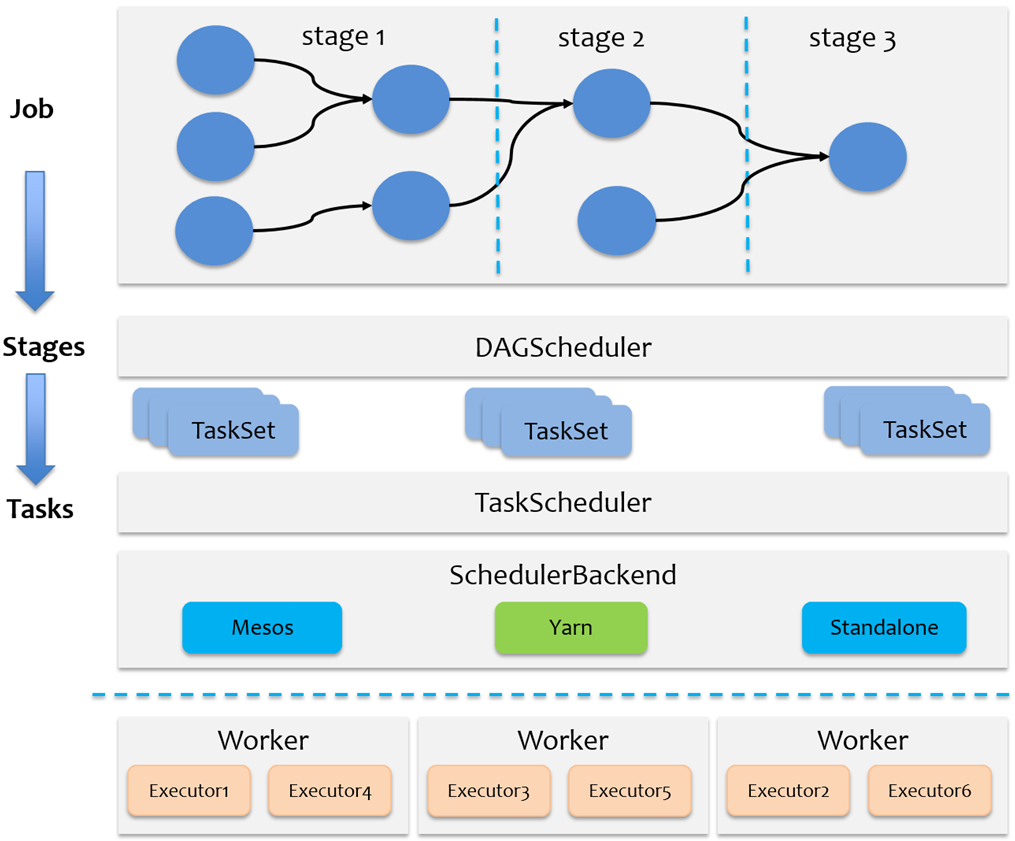

2.2.7.2 Job、DAG和Stage

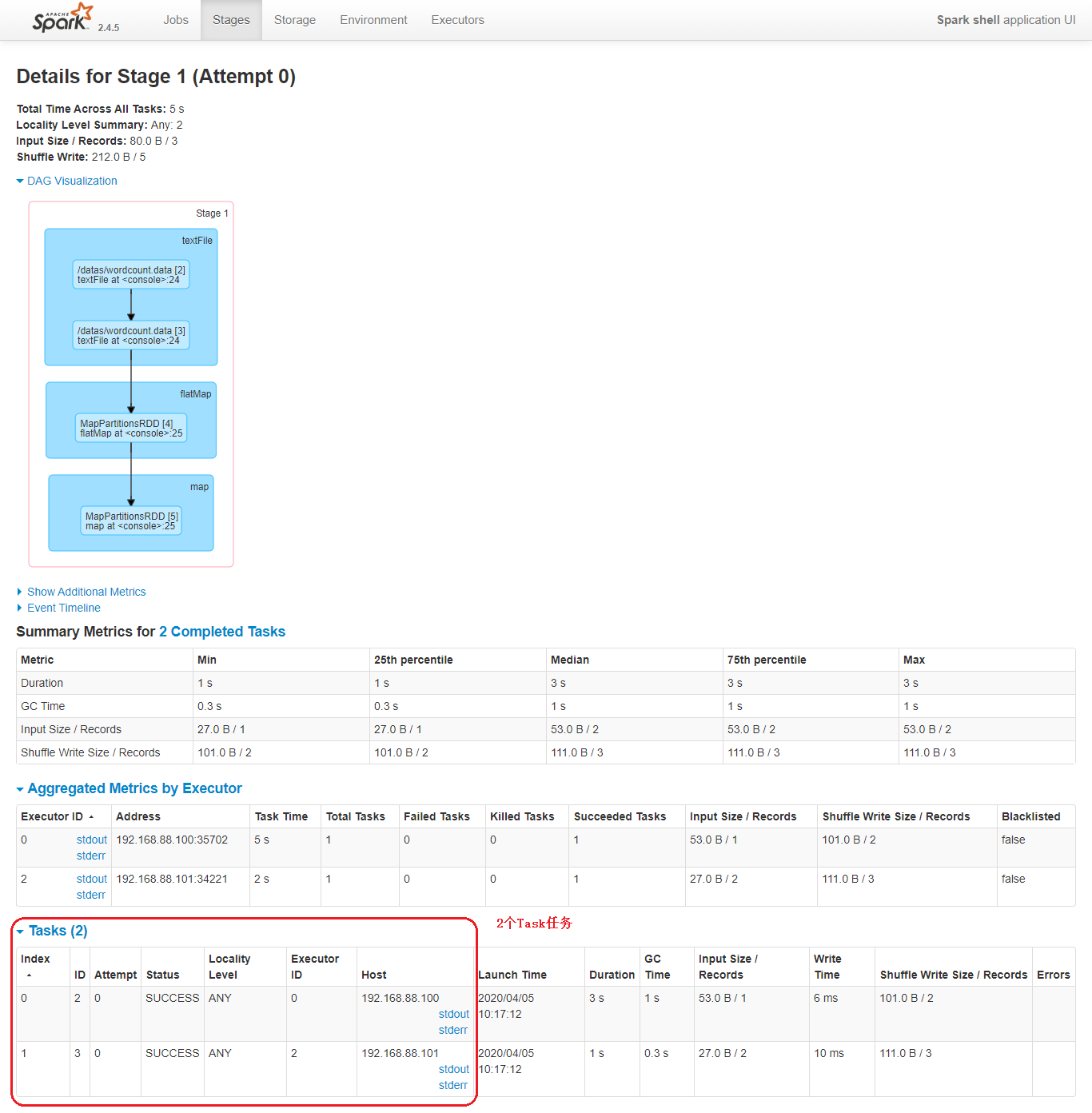

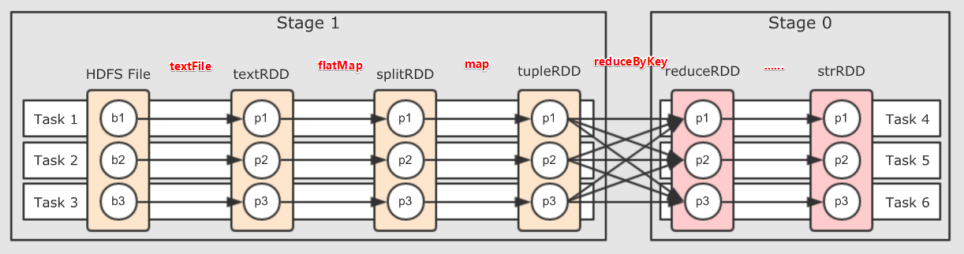

还可以发现在一个Spark Application中,包含多个Job,每个Job有多个Stage组成,每个Job执行按照DAG图进行的。

其中每个Stage中包含多个Task任务,每个Task以线程Thread方式执行,需要1Core CPU。

可以看到Spark为应用程序提供了非常详尽的统计页面,每个应用的Job和Stage等信息都可以在这里查看到。通过观察应用详情页的各个信息,对进一步优化程序,调整瓶颈有着重要作用,后期综合项目案例详细讲解。

Spark Application程序运行时三个核心概念:Job、Stage、Task,说明如下:

Task:被分配到各个 Executor 的单位工作内容,它是 Spark 中的最小执行单位,一般来说有多少个 Paritition(物理层面的概念,即分支可以理解为将数据划分成不同部分并行处理),就会有多少个 Task,每个 Task 只会处理单一分支上的数据。Job:由多个 Task 的并行计算部分,一般 Spark 中的 action 操作(如 save、collect,后面进一步说明),会生成一个 Job。Stage:Job 的组成单位,一个 Job 会切分成多个 Stage,Stage 彼此之间相互依赖顺序执行,而每个 Stage 是多个 Task 的集合,类似 map 和 reduce stage。

2.3 Standalone HA 2.3.1 高可用HA

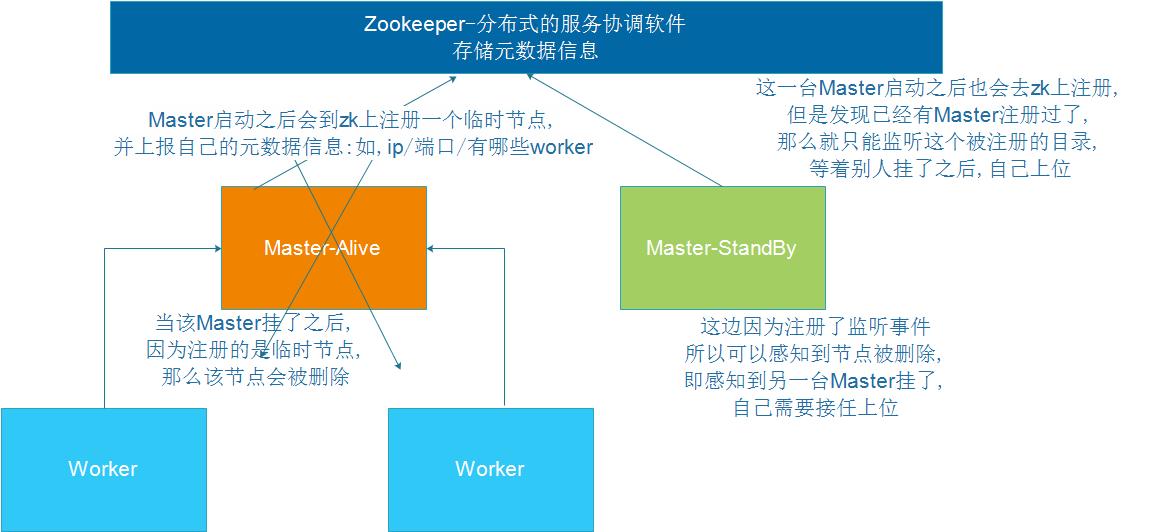

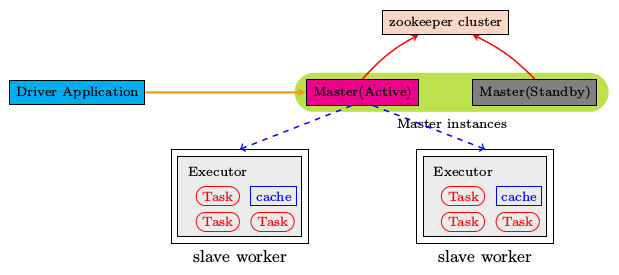

Spark Standalone集群是Master-Slaves架构的集群模式,和大部分的Master-Slaves结构集群一样,存在着Master单点故障(SPOF)的问题。

如何解决这个单点故障的问题,Spark提供了两种方案:

1.基于文件系统的单点恢复(Single-Node Recovery with Local File System)–只能用于开发或测试环境。

ZooKeeper提供了一个Leader Election机制,利用这个机制可以保证虽然集群存在多个Master,但是只有一个是Active的,其他的都是Standby。当Active的Master出现故障时,另外的一个Standby Master会被选举出来。由于集群的信息,包括Worker, Driver和Application的信息都已经持久化到文件系统,因此在切换的过程中只会影响新Job的提交,对于正在进行的Job没有任何的影响。加入ZooKeeper的集群整体架构如下图所示。

2.3.2 基于Zookeeper实现HA

官方文档:http://spark.apache.org/docs/2.4.5/spark-standalone.html#standby-masters-with-zookeeper

先停止Sprak集群

/export/ servers// spark/sbin/ stop-all.sh

在node01上配置:

vim /export/ servers// spark/conf/ spark-env.sh"-Dspark.deploy.recoveryMode=ZOOKEEPER -Dspark.deploy.zookeeper.url=node1:2181,node2:2181,node3:2181 -Dspark.deploy.zookeeper.dir=/spark-ha"

将spark-env.sh分发集群

cd /export/serversenv .sh root@node2:$PWDenv .sh root@node3:$PWD

启动集群服务

/export/ servers// spark/sbin/ start-all.sh/export/ servers// spark/sbin/ start-master.sh

查看WebUI

http://node1:8080/ http://node2:8080/

2.3.3 测试运行

测试主备切换

1.在node1上使用jps查看master进程id

如启动spark-shell,需要指定多个master地址

/export/ servers// spark/bin/ spark-shell --master spark:// node01:7077 ,node02:7077

sc.textFile("hdfs://node1:8020/wordcount/input/words.txt" ) Map(_ .split (" " ) ).map((_, 1 )).reduceByKey(_ + _ ) AsTextFile("hdfs://node1:8020/wordcount/output3" )

停止集群

/export/ servers// spark/sbin/ stop-all.sh

2.4 Spark on Yarn

Yarn是一个成熟稳定且强大的资源管理和任务调度的大数据框架,在企业中市场占有率很高,意味着有很多公司都在用Yarn,将公司的资源交给Yarn做统一的管理!并支持对任务做多种模式的调度,如FIFO/Capacity/Fair等多种调度模式!

所以很多计算框架,都主动支持将计算任务放在Yarn上运行,如Spark/Flink

企业中也都是将Spark Application提交运行在YANR上,文档: http://spark.apache.org/docs/2.4.5/running-on-yarn.html#launching-spark-on-yarn

2.4.1 注意事项

Spark On Yarn的本质?

将Spark任务的class字节码文件打成jar包,提交到Yarn的JVM中去运行

Spark On Yarn需要啥?

1.需要Yarn集群:已经安装了

2.需要提交工具:spark-submit命令–在spark/bin目录

3.需要被提交的jar:Spark任务的jar包(如spark/example/jars中有示例程序,或我们后续自己开发的Spark任务)

4.需要其他依赖jar:Yarn的JVM运行Spark的字节码需要Spark的jar包支持!Spark安装目录中有jar包,在spark/jars/中

总结:SparkOnYarn

不需要搭建Spark集群

只需要:Yarn+单机版Spark(里面有提交命令,依赖jar,示例jar)

当然还要一些配置

2.4.2 修改配置

当Spark Application运行到YARN上时,在提交应用时指定master为yarn即可,同时需要告知YARN集群配置信息(比如ResourceManager地址信息),此外需要监控Spark Application,配置历史服务器相关属性。

2.4.2.1 修改spark-env.sh cd /export/ servers// spark/conf/export/ servers// spark/conf/ spark-env.sh

/export/ servers// hadoop-2.7 .5 /etc/ hadoop/export/ servers// hadoop-2.7 .5 /etc/ hadoop

同步

cd /export/serversenv .sh root@node2:$PWDenv .sh root@node3:$PWD

2.4.2.2 整合历史服务器并关闭资源检查

整合Yarn历史服务器并关闭资源检查

在【$HADOOP_HOME/etc/hadoop/yarn-site.xml】配置文件中,指定MRHistoryServer地址信息,添加如下内容,

在node1上修改

cd /export/ servers// hadoop-2.7 .5 /etc/ hadoop/export/ servers// hadoop-2.7 .5 /etc/ hadoop/yarn-site.xml

添加内容

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 <configuration > <property > <name > yarn.resourcemanager.hostname</name > <value > node1</value > </property > <property > <name > yarn.nodemanager.aux-services</name > <value > mapreduce_shuffle</value > </property > <property > <name > yarn.nodemanager.resource.memory-mb</name > <value > 20480</value > </property > <property > <name > yarn.scheduler.minimum-allocation-mb</name > <value > 2048</value > </property > <property > <name > yarn.nodemanager.vmem-pmem-ratio</name > <value > 2.1</value > </property > <property > <name > yarn.log-aggregation-enable</name > <value > true</value > </property > <property > <name > yarn.log-aggregation.retain-seconds</name > <value > 604800</value > </property > <property > <name > yarn.log.server.url</name > <value > http://node1:19888/jobhistory/logs</value > </property > <property > <name > yarn.nodemanager.pmem-check-enabled</name > <value > false</value > </property > <property > <name > yarn.nodemanager.vmem-check-enabled</name > <value > false</value > </property > </configuration >

由于使用虚拟机运行服务,默认情况下YARN检查机器内存,当内存不足时,提交的应用无法运行,可以设置不检查资源

同步

cd /export/ servers// hadoop-2.7 .5 /etc/ hadoop$PWD $PWD

配置spark历史服务器–前面已经配置过

在node1上修改

cd /export/ servers// spark/conf/export/ servers// spark/conf/ spark-defaults.conf

添加内容

spark.eventLog .enabled true.eventLog .dir hdfs:.eventLog .compress true.yarn .historyServer .address node1:18080

同步

cd /export/ servers// spark/conf$PWD $PWD

2.4.2.3 配置依赖Spark Jar包

当Spark Application应用提交运行在YARN上时,默认情况下,每次提交应用都需要将依赖Spark相关jar包上传到YARN 集群中,为了节省提交时间和存储空间,将Spark相关jar包上传到HDFS目录中,设置属性告知Spark Application应用。

/spark/ jars//export/ servers// spark/jars/ * /spark/ jars/

在spark-defaults.conf中增加Spark相关jar包位置信息:

在node1上操作

vim /export/ servers// spark/conf/ spark-defaults.conf

添加内容

spark.yarn.jars hdfs:// node1:8020 /spark/ jars/*

同步

cd /export/ servers// spark/conf$PWD $PWD

2.4.3 启动服务

Spark Application运行在YARN上时,上述配置完成

启动服务:HDFS、YARN、MRHistoryServer和Spark HistoryServer,命令如下:

/export/ servers// spark/sbin/ start-history-server.sh

2.4.4 Spark On Yarn两种模式 2.4.4.1 引入

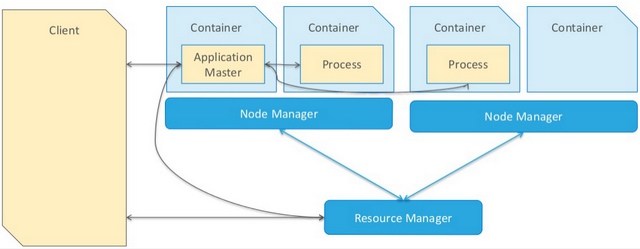

当一个MR应用提交运行到Hadoop YARN上时

包含两个部分:应用管理者AppMaster和运行应用进程Process(如MapReduce程序MapTask和ReduceTask任务),如下图所示:

当一个Spark应用提交运行在集群上时,

应用架构有两部分组成:Driver Program(资源申请和调度Job执行)和Executors(运行Job中Task任务和缓存数据),都是JVM Process进程:

而Driver程序运行的位置可以通过--deploy-mode 来指定, 值可以是:

1.client:表示Driver运行在提交应用的Client上(默认)

2.cluster:表示Driver运行在集群中(Standalone:Worker,YARN:NodeManager)

补充Driver是什么:

The process running the main() function of the application and creating the SparkContext

运行应用程序的main()函数并创建SparkContext的进程

注意

cluster和client模式最最本质的区别是:Driver程序运行在哪里。

企业实际生产环境中使用cluster

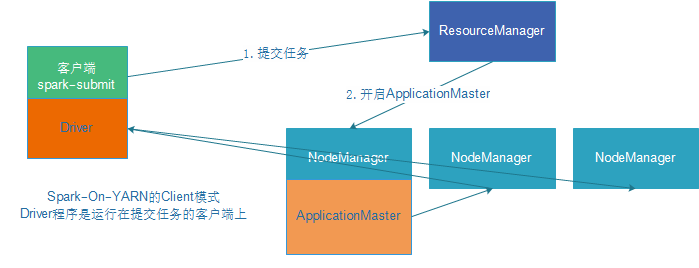

2.4.4.2 client模式

DeployMode为Client,表示应用Driver Program运行在提交应用Client主机上,示意图如下:

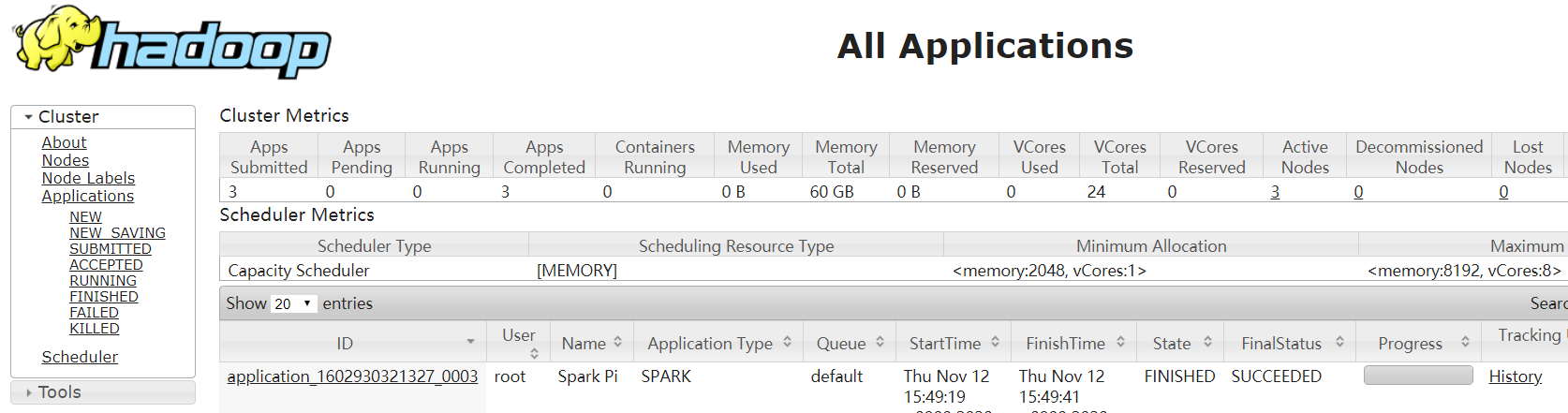

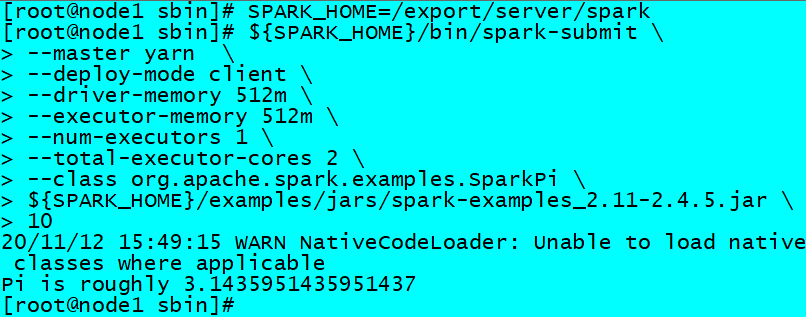

运行圆周率PI程序,采用client模式,命令如下:

SPARK_HOME=/export/ servers// spark${SPARK_HOME} /bin/ spark-submit \512 m \512 m \1 \2 \${SPARK_HOME} /examples/ jars/spark-examples_2.11 -2.4 .5 .jar \10

http://node1:8088/cluster

2.4.4.3 cluster模式

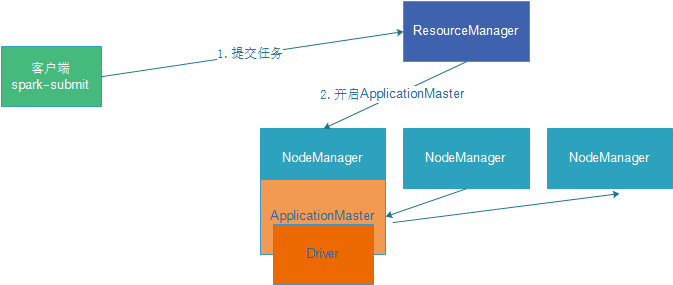

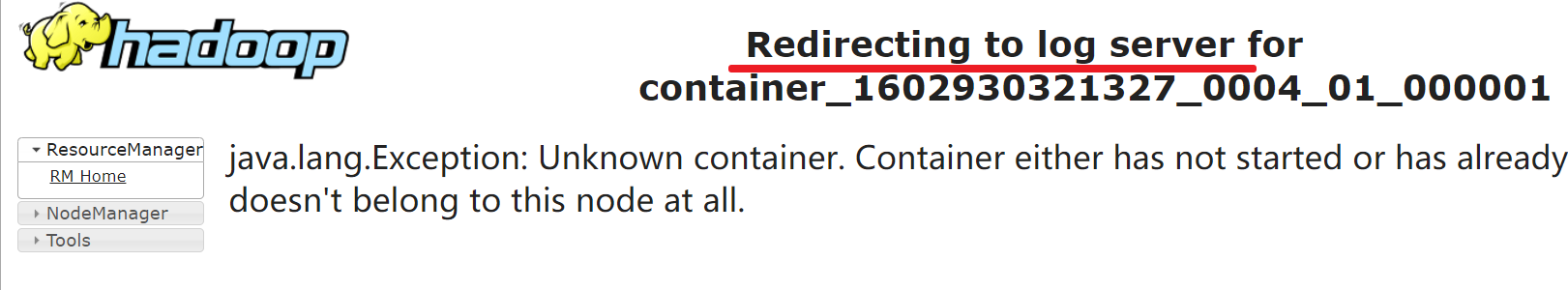

DeployMode为Cluster,表示应用Driver Program运行在集群从节点某台机器上,示意图如下:

运行圆周率PI程序,采用cluster模式,命令如下:

SPARK_HOME=/export/ servers// spark${SPARK_HOME} /bin/ spark-submit \512 m \512 m \1 \2 \${SPARK_HOME} /examples/ jars/spark-examples_2.11 -2.4 .5 .jar \10

http://node1:8088/cluster

2.4.4.4 总结

Cluster和Client模式最最本质的区别是:Driver程序运行在哪里。

cluster模式:生产环境中使用该模式

1.Driver运行在Client上

2.Driver输出结果会在客户端显示

client模式:学习测试时使用,开发不用,了解即可

1.Driver程序在YARN集群中,

2.Driver输出结果不能在客户端显示

3.该模式下Driver运行ApplicattionMaster这个节点上,如果出现问题,yarn会重启ApplicattionMaster(Driver)

2.4.5 扩展阅读:两种模式详细流程 2.4.5.1 client模式

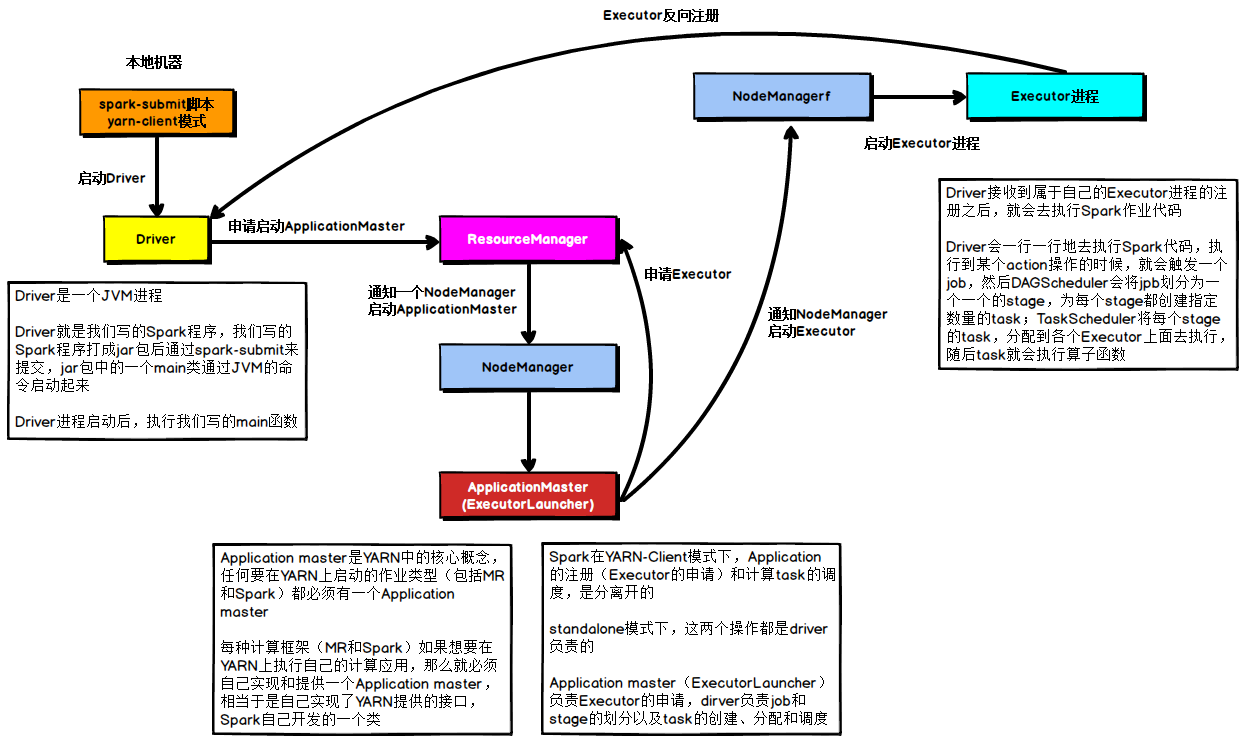

在YARN Client模式下,Driver在任务提交的本地机器上运行,示意图如下:

具体流程步骤如下:

1)、Driver在任务提交的本地机器上运行,Driver启动后会和ResourceManager通讯申请启动ApplicationMaster;

2)、随后ResourceManager分配Container,在合适的NodeManager上启动ApplicationMaster,此时的ApplicationMaster的功能相当于一个ExecutorLaucher,只负责向ResourceManager申请Executor内存;

3)、ResourceManager接到ApplicationMaster的资源申请后会分配Container,然后ApplicationMaster在资源分配指定的NodeManager上启动Executor进程;

4)、Executor进程启动后会向Driver反向注册,Executor全部注册完成后Driver开始执行main函数;

5)、之后执行到Action算子时,触发一个Job,并根据宽依赖开始划分Stage,每个Stage生成对应的TaskSet,之后将Task分发到各个Executor上执行。

2.4.5.2 cluster模式

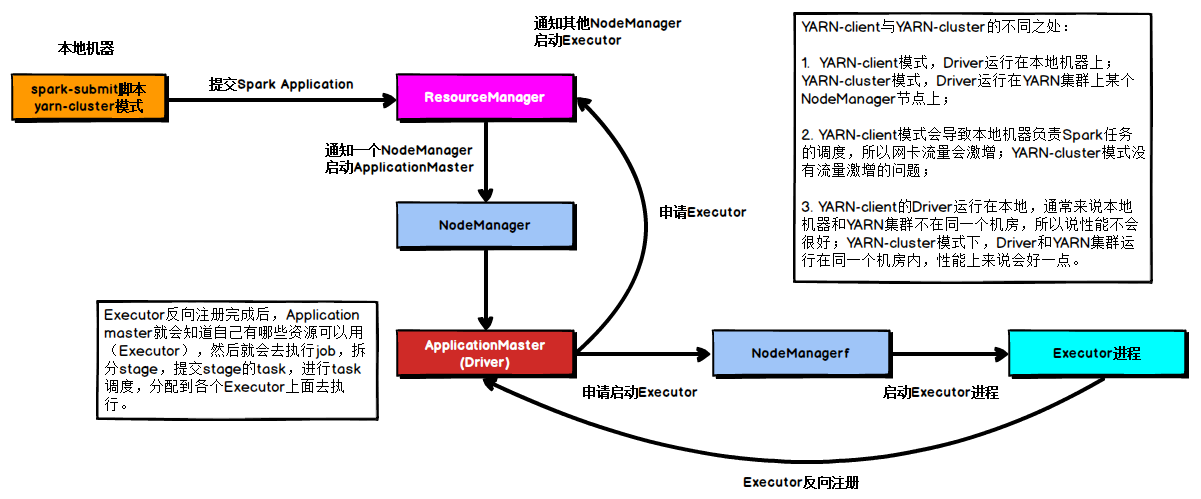

在YARN Cluster模式下,Driver运行在NodeManager Contanier中,此时Driver与AppMaster合为一体,示意图如下:

具体流程步骤如下:

1)、任务提交后会和ResourceManager通讯申请启动ApplicationMaster;

2)、随后ResourceManager分配Container,在合适的NodeManager上启动ApplicationMaster,此时的ApplicationMaster就是Driver;

3)、Driver启动后向ResourceManager申请Executor内存,ResourceManager接到ApplicationMaster的资源申请后会分配Container,然后在合适的NodeManager上启动Executor进程;

4)、Executor进程启动后会向Driver反向注册;

5)、Executor全部注册完成后Driver开始执行main函数,之后执行到Action算子时,触发一个job,并根据宽依赖开始划分stage,每个stage生成对应的taskSet,之后将task分发到各个Executor上执行;

2.4.6 扩展阅读:Spark 集群角色

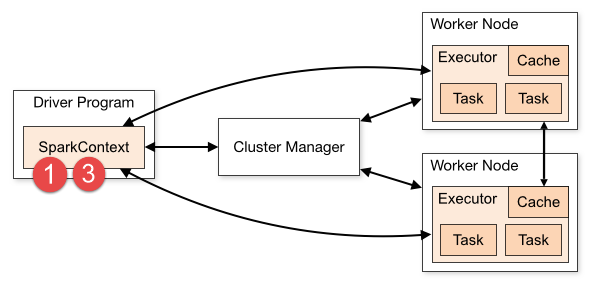

当Spark Application运行在集群上时,主要有四个部分组成,如下示意图:

1)Driver:是一个JVM Process 进程,编写的Spark应用程序就运行在Driver上,由Driver进程执行;Master(ResourceManager):是一个JVM Process 进程,主要负责资源的调度和分配,并进行集群的监控等职责;Worker(NodeManager):是一个JVM Process 进程,一个Worker运行在集群中的一台服务器上,主要负责两个职责,一个是用自己的内存存储RDD的某个或某些partition;另一个是启动其他进程和线程(Executor),对RDD上的partition进行并行的处理和计算。Executor:是一个JVM Process 进程,一个Worker(NodeManager)上可以运行多个Executor,Executor通过启动多个线程(task)来执行对RDD的partition进行并行计算,也就是执行我们对RDD定义的例如map、flatMap、reduce等算子操作。

2.4.7 扩展阅读:spark-shell和spark-submit

Spark支持多种集群管理器(Cluster Manager),取决于传递给SparkContext的MASTER环境变量的值:local、spark、yarn,区别如下:

Master URLMeaning

local在本地运行,只有一个工作进程,无并行计算能力。

local[K]在本地运行,有K个工作进程,通常设置K为机器的CPU核心数量。

local[*]在本地运行,工作进程数量等于机器的CPU核心数量。

spark://HOST:PORT以Standalone模式运行,这是Spark自身提供的集群运行模式,默认端口号: 7077。详细文档见:Spark standalone cluster。

mesos://HOST:PORT在Mesos集群上运行,Driver进程和Worker进程运行在Mesos集群上,部署模式必须使用固定值:–deploy-mode cluster。详细文档见:MesosClusterDispatcher.

yarn-client --master yarn--deploy-mode client在Yarn集群上运行,Driver进程在本地,Executor进程在Yarn集群上,部署模式必须使用固定值:–deploy-mode client。Yarn集群地址必须在HADOOP_CONF_DIR or YARN_CONF_DIR变量里定义。

yarn-cluster --master yarn--deploy-mode cluster在Yarn集群上运行,Driver进程在Yarn集群上,Executor进程也在Yarn集群上,部署模式必须使用固定值:–deploy-mode cluster。Yarn集群地址必须在HADOOP_CONF_DIR or YARN_CONF_DIR变量里定义。

2.4.7.1 spark-shell

引入

之前我们使用提交任务都是使用spark-shell提交,spark-shell是Spark自带的交互式Shell程序,方便用户进行交互式编程,用户可以在该命令行下可以用scala编写spark程序,适合学习测试时使用!

示例

spark-shell可以携带参数

spark-shell –master local[N] 数字N表示在本地模拟N个线程来运行当前任务

spark-shell –master local[*] *表示使用当前机器上所有可用的资源

默认不携带参数就是–master local[*]

spark-shell –master spark://node01:7077,node02:7077 表示运行在集群上

2.4.7.1 spark-submit

引入

spark-shell交互式编程确实很方便我们进行学习测试,但是在实际中我们一般是使用IDEA开发Spark应用程序打成jar包交给Spark集群/YARN去执行,所以我们还得学习一个spark-submit命令用来帮我们提交jar包给spark集群/YARN

spark-submit命令是我们开发时常用的!!!

示例

SPARK_HOME=/export/ servers// spark${SPARK_HOME} /bin/ spark-submit \2 ] \${SPARK_HOME} /examples/ jars/spark-examples_2.11 -2.4 .5 .jar \10

SPARK_HOME=/export/ servers// spark${SPARK_HOME} /bin/ spark-submit \// node1:7077 \${SPARK_HOME} /examples/ jars/spark-examples_2.11 -2.4 .5 .jar \10

SPARK_HOME=/export/ servers// spark${SPARK_HOME} /bin/ spark-submit \// node1:7077 ,node2:7077 \${SPARK_HOME} /examples/ jars/spark-examples_2.11 -2.4 .5 .jar \10

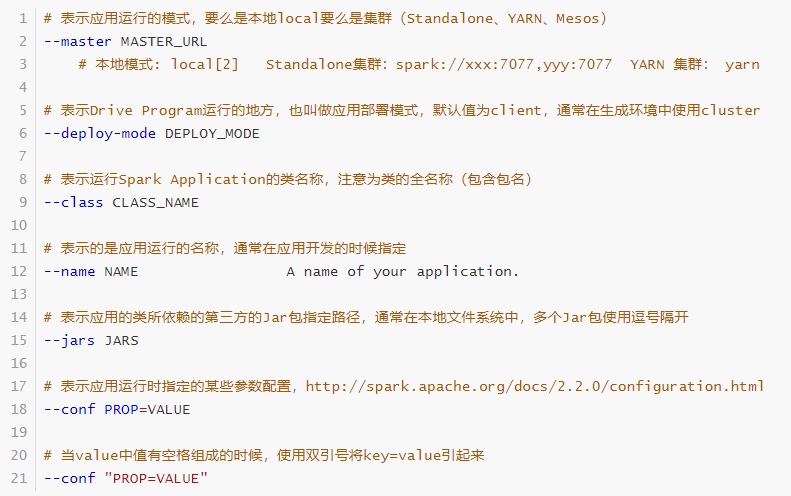

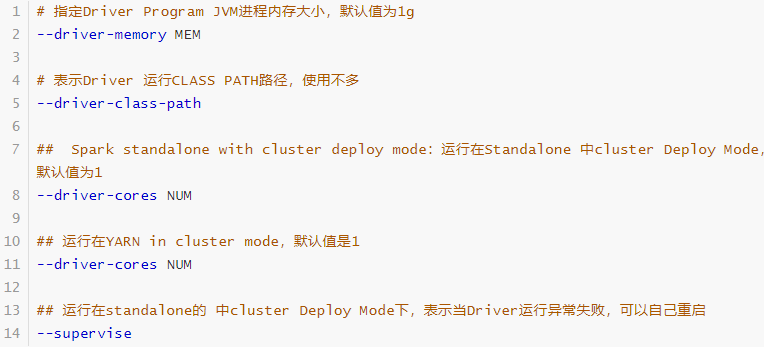

2.4.8 扩展阅读:命令参数

开发中需要根据实际任务的数据量大小、任务优先级、公司服务器的实际资源情况,参考公司之前的提交的任务的脚本参数,灵活设置即可

官方文档:http://spark.apache.org/docs/2.4.5/submitting-applications.html

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 [root@node1 ~ ]# / export/ servers/ / spark/ bin/ spark- submit - submit [options] < app jar | python file | R file> [app arguments]- submit - submit - submit run- example [options] example- class [example args]/ / https:/ / host:port, or local (Default : local [* ]).on one of the worker machines inside the cluster ("cluster")Default : client).and executor classpaths.on the driver and executor classpaths. Will search the local then maven central and any additional remoteby in search for the maven coordinates given with on the PYTHONPATH for Python apps.of each executor. File paths of these filesin executors can be accessed via SparkFiles.get(fileName).for conf/ spark- defaults.conf.with not work with only :Default : 1 ).or Mesos with cluster deploy mode only :and Mesos only :and YARN only :or all available cores on the worker in standalone mode)- only :dynamic allocation is enabled, the initial number of at least NUM.of each executor.to running the Application Master via the Securefor renewing the login tickets and the

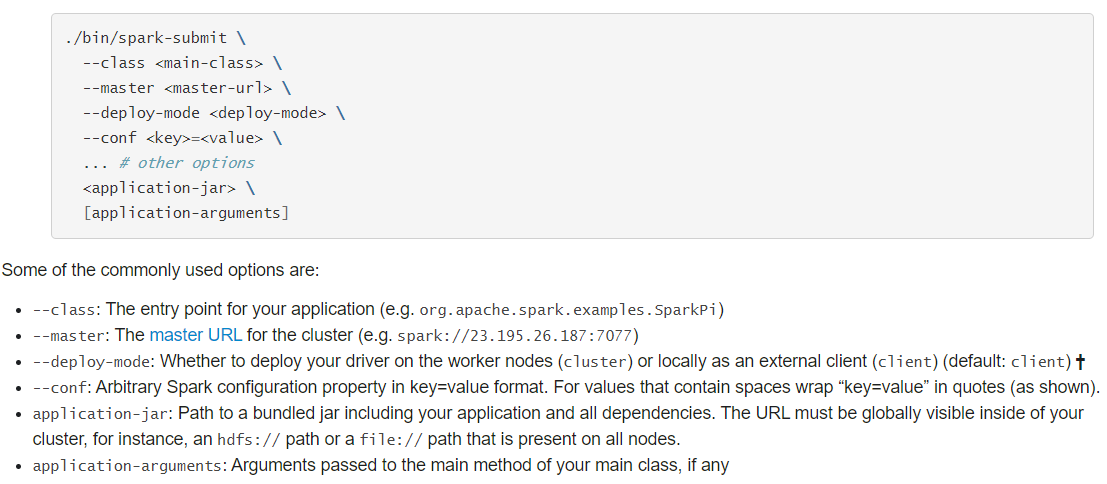

2.4.8.1 应用提交语法

使用【spark-submit】提交应用语法如下:

Usage: spark-submit [options] <app jar | python file > [app arguments]

如果使用Java或Scala语言编程程序,需要将应用编译后达成Jar包形式,提交运行。

2.4.8.2 基本参数配置

提交运行Spark Application时,有些基本参数需要传递值,如下所示:

动态加载Spark Applicaiton运行时的参数,通过–conf进行指定,如下使用方式:

2.4.8.3 Driver Program 参数配置

每个Spark Application运行时都有一个Driver Program,属于一个JVM Process进程,可以设置内存Memory和CPU Core核数。

2.4.8.4 Executor 参数配置

每个Spark Application运行时,需要启动Executor运行任务Task,需要指定Executor个数及每个Executor资源信息(内存Memory和CPU Core核数)。

2.4.8.5 官方案例

Spark 官方提供一些针对不同模式运行Spark Application如何设置参数提供案例,具体如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 ./bin/spark-submit \--class org.apache.spark.examples.SparkPi \--master local[8] \/path/to/examples.jar \./bin/spark-submit \--class org.apache.spark.examples.SparkPi \--master spark://207.184.161.138 :7077 \--executor-memory 20G \--total-executor-cores 100 \/path/to/examples.jar \./bin/spark-submit \--class org.apache.spark.examples.SparkPi \--master spark://207.184.161.138 :7077 \--deploy-mode cluster \--supervise \--executor-memory 20G \--total-executor-cores 100 \/path/to/examples.jar \./bin/spark-submit \--class org.apache.spark.examples.SparkPi \--master yarn \--deploy-mode cluster \ --executor-memory 20G \--num-executors 50 \/path/to/examples.jar \./bin/spark-submit \--master spark://207.184.161.138 :7077 \./bin/spark-submit \--class org.apache.spark.examples.SparkPi \--master mesos://207.184.161.138 :7077 \--deploy-mode cluster \--supervise \--executor-memory 20G \--total-executor-cores 100 \//path/to/examples.jar \./bin/spark-submit \--class org.apache.spark.examples.SparkPi \--master k8s://xx.yy.zz.ww :443 \--deploy-mode cluster \--executor-memory 20G \--num-executors 50 \//path/to/examples.jar \

3 Spark基础应用开发 3.1 Pom 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 202 <?xml version="1.0" encoding="UTF-8"?> <project xmlns ="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd"> <modelVersion > 4.0.0</modelVersion > <groupId > cn.xiaoma</groupId > <artifactId > spark_study_42</artifactId > <version > 1.0-SNAPSHOT</version > <repositories > <repository > <id > aliyun</id > <url > http://maven.aliyun.com/nexus/content/groups/public/</url > </repository > <repository > <id > apache</id > <url > https://repository.apache.org/content/repositories/snapshots/</url > </repository > <repository > <id > cloudera</id > <url > https://repository.cloudera.com/artifactory/cloudera-repos/</url > </repository > </repositories > <properties > <encoding > UTF-8</encoding > <maven.compiler.source > 1.8</maven.compiler.source > <maven.compiler.target > 1.8</maven.compiler.target > <scala.version > 2.11.12</scala.version > <hadoop.version > 2.7.5</hadoop.version > <spark.version > 2.4.5</spark.version > </properties > <dependencies > {scala.version} <dependency > <groupId > org.apache.spark</groupId > <artifactId > spark-core_2.11</artifactId > <version > $ {spark.version} </version > </dependency > <dependency > <groupId > org.apache.spark</groupId > <artifactId > spark-sql_2.11</artifactId > <version > $ {spark.version} </version > </dependency > <dependency > <groupId > org.apache.spark</groupId > <artifactId > spark-hive_2.11</artifactId > <version > $ {spark.version} </version > </dependency > <dependency > <groupId > org.apache.spark</groupId > <artifactId > spark-hive-thriftserver_2.11</artifactId > <version > $ {spark.version} </version > </dependency > <dependency > <groupId > org.apache.spark</groupId > <artifactId > spark-streaming_2.11</artifactId > <version > $ {spark.version} </version > </dependency > <dependency > <groupId > org.apache.spark</groupId > <artifactId > spark-mllib_2.11</artifactId > <version > $ {spark.version} </version > </dependency > <dependency > <groupId > org.apache.spark</groupId > <artifactId > spark-streaming-kafka-0-10_2.11</artifactId > <version > $ {spark.version} </version > </dependency > <dependency > <groupId > org.apache.spark</groupId > <artifactId > spark-sql-kafka-0-10_2.11</artifactId > <version > $ {spark.version} </version > </dependency > <dependency > <groupId > org.apache.hadoop</groupId > <artifactId > hadoop-client</artifactId > <version > 2.7.5</version > </dependency > <dependency > <groupId > mysql</groupId > <artifactId > mysql-connector-java</artifactId > <version > 5.1.38</version > </dependency > <dependency > <groupId > com.alibaba</groupId > <artifactId > fastjson</artifactId > <version > 1.2.47</version > </dependency > <dependency > <groupId > com.hankcs</groupId > <artifactId > hanlp</artifactId > <version > portable-1.7.7</version > </dependency > <dependency > <groupId > redis.clients</groupId > <artifactId > jedis</artifactId > <version > 2.9.0</version > </dependency > <dependency > <groupId > org.apache.spark</groupId > <artifactId > spark-mllib_2.11</artifactId > <version > 2.4.5</version > </dependency > </dependencies > <build > <sourceDirectory > src/main/scala</sourceDirectory > <plugins > <plugin > <groupId > org.apache.maven.plugins</groupId > <artifactId > maven-compiler-plugin</artifactId > <version > 3.5.1</version > </plugin > <plugin > <groupId > net.alchim31.maven</groupId > <artifactId > scala-maven-plugin</artifactId > <version > 3.2.2</version > <executions > <execution > <goals > <goal > compile</goal > <goal > testCompile</goal > </goals > <configuration > <args > <arg > -dependencyfile</arg > <arg > $ {project.build.directory} /.scala_dependencies</arg > </args > </configuration > </execution > </executions > </plugin > <plugin > <groupId > org.apache.maven.plugins</groupId > <artifactId > maven-surefire-plugin</artifactId > <version > 2.18.1</version > <configuration > <useFile > false</useFile > <disableXmlReport > true</disableXmlReport > <includes > <include > **/*Test.*</include > <include > **/*Suite.*</include > </includes > </configuration > </plugin > <plugin > <groupId > org.apache.maven.plugins</groupId > <artifactId > maven-shade-plugin</artifactId > <version > 2.3</version > <executions > <execution > <phase > package</phase > <goals > <goal > shade</goal > </goals > <configuration > <filters > <filter > <artifact > *:*</artifact > <excludes > <exclude > META-INF/*.SF</exclude > <exclude > META-INF/*.DSA</exclude > <exclude > META-INF/*.RSA</exclude > </excludes > </filter > </filters > <transformers > <transformer implementation="org.apache.maven.plugins.shade.resource.ManifestResourceTransformer"> <mainClass > </mainClass > </transformer > </transformers > </configuration > </execution > </executions > </plugin > </plugins > </build > </project >

3.2 WordCount本地运行 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 import org.apache.spark.rdd.RDD2020 /11/ 13 14 :44 // 1 .准备环境(Env)sc-->SparkContext"wc" ).setMaster("local[*]" )"WARN" )// 2 .加载文件(Source)// RDD:弹性分布式数据集(RDD),Spark中的基本抽象。// 先简单理解为分布式集合!类似于DataSet!// fileRDD: RDD[一行行的数据]"data/input/words.txt" )// 3 .处理数据(Transformation)// 3.1 切分// wordRDD: RDD[一个个的单词]// val wordRDD: RDD[String] = fileRDD.flatMap((line)=>line.split(" " ))" " ))// _下划线表示每一行// 3.2 每个单词记为1 // wordAndOneRDD: RDD[(单词, 1 )]// val wordAndOneRDD: RDD[(String, Int)] = wordRDD.map((word)=>(word,1 ))1 ))// _表示每一个单词// 3.3 .分组聚合reduceByKey= 先groupByKey + sum或reduce// val groupedRDD: RDD[(String, Iterable[Int])] = wordAndOneRDD.groupByKey()// val resultRDD: RDD[(String, Int)] = groupedRDD.mapValues(_.sum)// val resultRDD: RDD[(String, Int)] = wordAndOneRDD.reduceByKey((temp,current)=>temp + current)// 4 .输出结果(Sink)// 将分布式集合收集为本地集合// action// println(array.toBuffer)// array.foreach(t=>println(t))// array.foreach(println(_))// array.foreach(println _)// 行为参数化// cation1000 * 1200 )// 等待20 分钟,方便查看webUI:http:// localhost:4040 /jobs/ // 5 .关闭资源

3.3 WordCount集群运行 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 import org.apache.spark.rdd.RDD2020 /11/ 13 14 :44 if (args.length != 2 ){"请携带2个参数: input-path oupput-path" )exit (1 )// 非0 表示非正常退出程序// 1 .准备环境(Env)sc-->SparkContext"wc" )// .setMaster("local[*]" )"WARN" )// 2 .加载文件(Source)// RDD:弹性分布式数据集(RDD),Spark中的基本抽象。// 先简单理解为分布式集合!类似于DataSet!// fileRDD: RDD[一行行的数据]0 ))// 表示启动该程序的时候需要通过参数执行输入数据路径// 3 .处理数据(Transformation)// 3.1 切分// wordRDD: RDD[一个个的单词]// val wordRDD: RDD[String] = fileRDD.flatMap((line)=>line.split(" " ))" " ))// _下划线表示每一行// 3.2 每个单词记为1 // wordAndOneRDD: RDD[(单词, 1 )]// val wordAndOneRDD: RDD[(String, Int)] = wordRDD.map((word)=>(word,1 ))1 ))// _表示每一个单词// 3.3 .分组聚合reduceByKey= 先groupByKey + sum或reduce// val groupedRDD: RDD[(String, Iterable[Int])] = wordAndOneRDD.groupByKey()// val resultRDD: RDD[(String, Int)] = groupedRDD.mapValues(_.sum)// val resultRDD: RDD[(String, Int)] = wordAndOneRDD.reduceByKey((temp,current)=>temp + current)// val resultRDD: RDD[(String, Int)] = wordAndOneRDD.reduceByKey(_+_)// 4 .输出结果(Sink)// 将分布式集合收集为本地集合// val array: Array[(String, Int)] = resultRDD.collect()// println(array.toBuffer)// array.foreach(t=>println(t))// array.foreach(println(_))// array.foreach(println _)// array.foreach(println)// 行为参数化"${args(1)}_${System.currentTimeMillis()}" )// Thread.sleep(1000 * 120 )// 等待2 分钟,方便查看webUI:http:// localhost:4040 /jobs/ // 5 .关闭资源

打包

改名并上传到linux/hdfs(方便以后在任意客户端提交)

提交任务

SPARK_HOME= /export/ servers// spark${SPARK_HOME} /bin/ spark-submit \512 m \512 m \1 \2 \/root/ wc.jar \// node1:8020 /wordcount/i nput/words.txt hdfs:/ /node1:8020/ wordcount/output42

3.4 WordCount-java8版本 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 import org.apache.spark.SparkConf;class WordCount {[] args) {new SparkConf() .setAppName("wc" ) .setMaster("local[*]" ) ;new JavaSparkContext(sparkConf ) ;LogLevel("WARN" ) ;File("data/input/words.txt" ) ;Map((line ) -> Arrays .as List(line .split (" " ) ).iterator() );ToPair(word -> new Tuple2(word , 1) );ByKey((a , b ) -> a + b);list = resultRDD.collect() ;list .for Each(System.out ::println ) ;

3.5 WordCount流程图解

3.6 扩展阅读:main函数执行流程

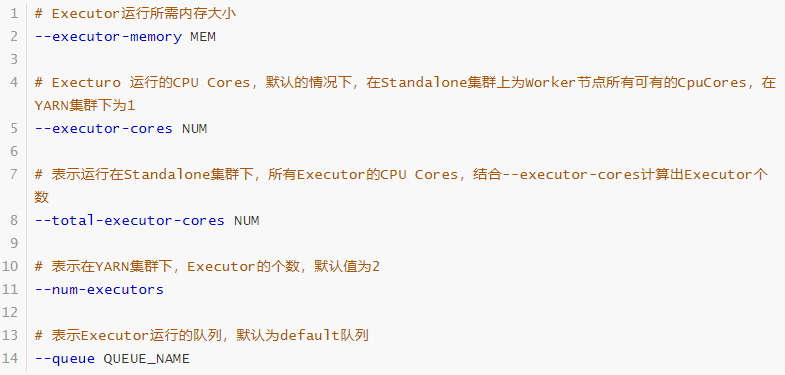

Spark Application应用程序运行时,无论client还是cluster部署模式DeployMode,当Driver Program和Executors启动完成以后,就要开始执行应用程序中MAIN函数的代码,以词频统计WordCount程序为例剖析讲解。

第一、构建SparkContex对象和关闭SparkContext资源,都是在Driver Program中执行,上图中①和③都是,如下图所示:

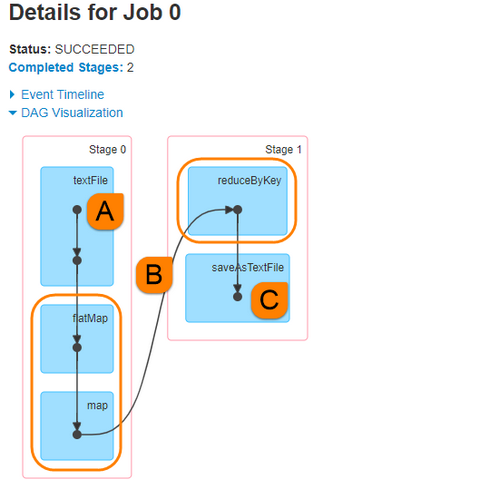

第二、上图中②的加载数据【A】、处理数据【B】和输出数据【C】代码,都在Executors上执行,从WEB UI监控页面可以看到此Job(RDD#action触发一个Job)对应DAG图,如下所示:

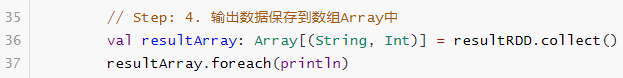

将结果数据resultRDD调用saveAsTextFile方法,保存数据到外部存储系统中,代码在Executor中执行的。但是如果resultRDD调用take、collect或count方法时,获取到最终结果数据返回给Driver,代码如下:

运行应用程序时,将数组resultArray数据打印到标准输出,Driver Program端日志打印结果:

综上所述Spark Application中Job执行有两个主要点:

1)、RDD输出函数分类两类

第一类:返回值给Driver Progam,比如count、first、take、collect等

第二类:没有返回值,比如直接打印结果、保存至外部存储系统(HDFS文件)等

2)、在Job中从读取数据封装为RDD和一切RDD调用方法都是在Executor中执行,其他代码都是在Driver Program中执行

SparkContext创建与关闭、其他变量创建等在Driver Program中执行

RDD调用函数都是在Executors中执行

4 Spark Core 4.1 RDD详解 4.1.1 为什么需要RDD

1.原生集合:Java/Scala中的List,但是只支持单机版! 不支持分布式!如果要做分布式的计算,需要做很多额外工作,线程/进程通信,容错,自动均衡…..麻烦,所以就诞生了框架!

2.MR:效率低(运行效率低,开发效率低)–早就淘汰

3.诞生了Spark/Flink

Spark/Flink,对原生集合进行了封装, 抽象出一个新的数据类型–RDD/DataSet

4.1.2 什么是RDD

在Spark开山之作Resilient Distributed Datasets: A Fault-Tolerant Abstraction for In-Memory Cluster Computing这篇paper中(以下简称 RDD Paper),Matei等人提出了RDD这种数据结构,文中开头对RDD的定义是:

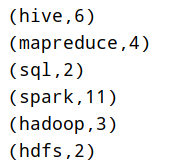

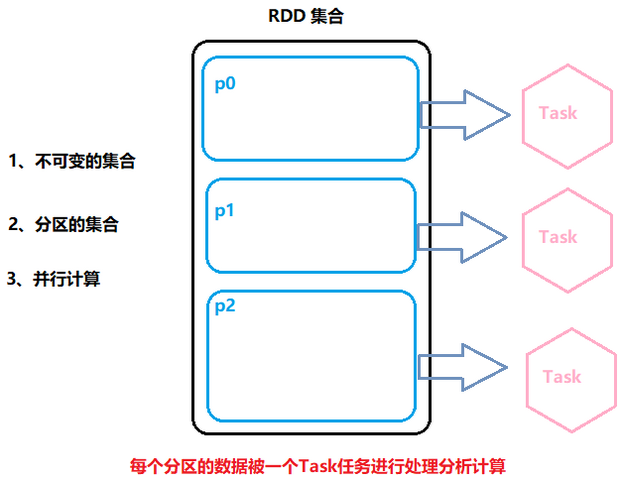

A Resilient Distributed Dataset (RDD), the basic abstraction in Spark. Represents an immutable, partitioned collection of elements that can be operated on in parallel.

RDD(Resilient Distributed Dataset)弹性分布式数据集,是Spark中最基本的数据抽象,代表一个不可变、可分区、里面的元素可并行计算的集合。

所有的运算以及操作都建立在 RDD 数据结构的基础之上。

RDD设计的核心点为:

拆分核心要点三个方面:

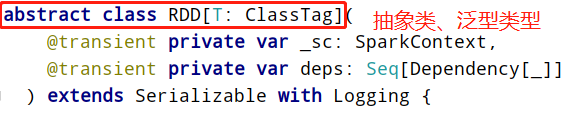

可以认为RDD是分布式的列表List或数组Array,抽象的数据结构,RDD是一个抽象类Abstract Class和泛型Generic Type:

RDD弹性分布式数据集核心点示意图如下:

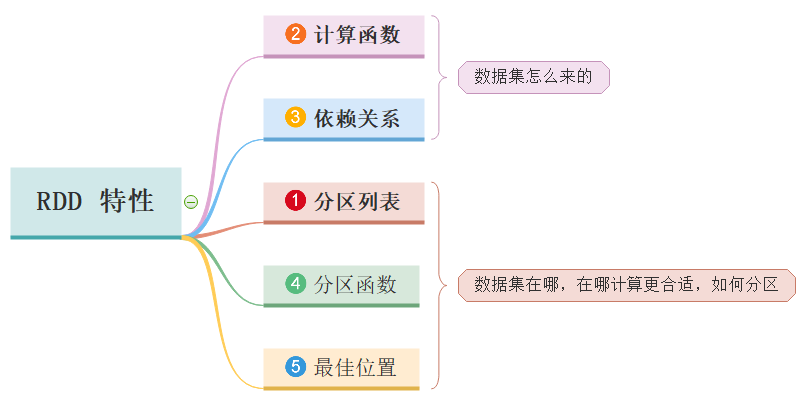

4.1.3 RDD5大特性

RDD 数据结构内部有五个特性(摘录RDD 源码)

前三个特征每个RDD都具备的,后两个特征可选的。

第一个:A list of partitions

一组分片(Partition)/一个分区(Partition)列表,即数据集的基本组成单位;

对于RDD来说,每个分片都会被一个计算任务处理,分片数决定并行度;

用户可以在创建RDD时指定RDD的分片个数,如果没有指定,那么就会采用默认值;

第二个:A function for computing each split

一个函数会被作用在每一个分区;

Spark中RDD的计算是以分片为单位的,compute函数会被作用到每个分区上;

第三个:A list of dependencies on other RDDs

一个RDD会依赖于其他多个RDD;

RDD的每次转换都会生成一个新的RDD,所以RDD之间就会形成类似于流水线一样的前后依赖关系。在部分分区数据丢失时,Spark可以通过这个依赖关系重新计算丢失的分区数据,而不是对RDD的所有分区进行重新计算(Spark的容错机制);

第四个:Optionally, a Partitioner for key-value RDDs (e.g. to say that the RDD is hash-partitioned)

可选项,对于KeyValue类型的RDD会有一个Partitioner,即RDD的分区函数;

当前Spark中实现了两种类型的分区函数,一个是基于哈希的HashPartitioner,另外一个是基于范围的RangePartitioner。

只有对于于key-value的RDD,才会有Partitioner,非key-value的RDD的Parititioner的值是None。

Partitioner函数不但决定了RDD本身的分片数量,也决定了parent RDD Shuffle输出时的分片数量。

第五个:Optionally, a list of preferred locations to compute each split on (e.g. block locations for an HDFS file)

可选项,一个列表,存储存取每个Partition的优先位置(preferred location);

对于一个HDFS文件来说,这个列表保存的就是每个Partition所在的块的位置。

按照”移动数据不如移动计算“的理念,Spark在进行任务调度的时候,会尽可能选择那些存有数据的worker节点来进行任务计算。(数据本地性)

RDD 是一个数据集的表示,不仅表示了数据集,还表示了这个数据集从哪来、如何计算,主要属性包括五个方面(必须牢记,通过编码加深理解,面试常问):

RDD将Spark的底层的细节都隐藏起来(自动容错、位置感知、任务调度执行,失败重试等),让开发者可以像操作本地集合一样以函数式编程的方式操作RDD这个分布式数据集,进行各种并行计算,RDD中很多处理数据函数与列表List中相同与类似。

4.2 RDD创建

官方文档:http://spark.apache.org/docs/latest/rdd-programming-guide.html#resilient-distributed-datasets-rdds

如何将数据封装到RDD集合中,主要有两种方式:并行化本地集合(Driver Program中)和引用加载外部存储系统(如HDFS、Hive、HBase、Kafka、Elasticsearch等)数据集。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 object RDDDemo01_Create {[String ] ): Unit = {val sparkConf: SparkConf = new SparkConf() .setAppName("wc" ) .setMaster("local[*]" ) val sc: SparkContext = new SparkContext(sparkConf ) LogLevel("WARN" ) val rdd1: RDD[String ] = sc.parallelize(List("hadoop spark" , "hive flink" , "hive flink" ) )val rdd2: RDD[String ] = sc.parallelize(List("hadoop spark" , "hive flink" , "hive flink" ) , 8 )val rdd3: RDD[String ] = sc.makeRDD(List("hadoop spark" , "hive flink" , "hive flink" ) , 9 ) val rdd4: RDD[String ] = sc.textFile("data/input/words.txt" ) val rdd5: RDD[String ] = sc.textFile("data/input/words.txt" , 3) val rdd6: RDD[String ] = sc.textFile("data/input/ratings10" ) val rdd7: RDD[String ] = sc.textFile("data/input/ratings10" , 3) val rdd8: RDD[(String , String )] = sc.wholeTextFiles("data/input/ratings10" ) val rdd9: RDD[(String , String )] = sc.wholeTextFiles("data/input/ratings10" , 3) val arr: Array[(String , String )] = rdd9.take(1 ) "rdd1:" + rdd1.getNumPartitions) "rdd2:" + rdd2.getNumPartitions) "rdd3:" + rdd3.getNumPartitions) "rdd4:" + rdd4.getNumPartitions) "rdd5:" + rdd5.getNumPartitions) "rdd6:" + rdd6.getNumPartitions) "rdd7:" + rdd7.getNumPartitions) "rdd8:" + rdd8.getNumPartitions) "rdd9:" + rdd9.getNumPartitions)

4.3 RDD操作 4.3.1 函数分类

官方文档:http://spark.apache.org/docs/latest/rdd-programming-guide.html#rdd-operations

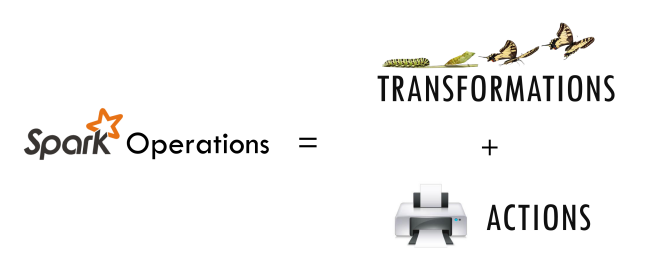

对于 Spark 处理的大量数据而言,会将数据切分后放入RDD作为Spark 的基本数据结构,开发者可以在 RDD 上进行丰富的操作,之后 Spark 会根据操作调度集群资源进行计算。总结起来,RDD 的操作主要可以分为 Transformation 和 Action 两种。

RDD中操作(函数、算子)分为两类:

1)、Transformation转换操作:返回一个新的RDD

which create a new dataset from an existing one

所有Transformation函数都是Lazy,不会立即执行,需要Action函数触发

2)、Action动作操作:返回值不是RDD(无返回值或返回其他的)

which return a value to the driver program after running a computation on the datase

所有Action函数立即执行(Eager),比如count、first、collect、take等

此外注意RDD中函数细节:

第一点:RDD不实际存储真正要计算的数据,而是记录了数据的位置在哪里,数据的转换关系(调用了什么方法,传入什么函数);

第二点:RDD中的所有转换都是惰性求值/延迟执行的,也就是说并不会直接计算。只有当发生一个要求返回结果给Driver的Action动作时,这些转换才会真正运行。之所以使用惰性求值/延迟执行,是因为这样可以在Action时对RDD操作形成DAG有向无环图进行Stage的划分和并行优化,这种设计让Spark更加有效率地运行。

面试题1:Spark中的RDD操作API/算子为什么要区分Transformation和Action?

Transformation可以懒执行/延迟执行Action 会触发执行

面试题2:为什么要有懒执行/延迟执行和触发执行?

因为在触发执行的之后可以对前面的懒执行/延迟执行的代码进行优化!

4.3.2 常用函数 4.3.2.1 分区操作函数

每个RDD由多分区组成的,实际开发建议对每个分区数据的进行操作,map函数使用mapPartitions代替、foreache函数使用foreachPartition代替。

map是对每个分区的每个数据操作

mapPartitions是对每个分区操作

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 import org.apache.spark.rdd.RDD2020 /11/ 13 14 :44 // 1 .准备环境(Env)sc-->SparkContext"wc" ).setMaster("local[*]" )"WARN" )// 2 .加载文件(Source)"data/input/words.txt" )// 3 .处理数据(Transformation)" " ))// _下划线表示每一行//m ap(函数),该函数会作用在每个分区中的每一条数据上,value是每一条数据// wordRDD.map((_,1 ))// 开启连接-有几条数据就几次1 )// 关闭连接-有几条数据就几次// _表示每一个单词//m apPartitions(函数):该函数会作用在每个分区上,values是每个分区上的数据// 开启连接-有几个分区就几次// values.map((_,1 ))1 )) // value是该分区中的每一条数据// 关闭连接-有几个分区就几次// 4 .输出结果(Sink)// foreach(函数),该函数会作用在每个分区中的每一条数据上,value是每一条数据// Applies a function f to all elements of this RDD.// 开启连接-有几条数据就几次// 关闭连接-有几条数据就几次// foreachPartition(函数),该函数会作用在每个分区上,values是每个分区上的数据// Applies a function f to each partition of this RDD.// 开启连接-有几个分区就几次// value是该分区中的每一条数据// 关闭连接-有几个分区就几次// 5 .关闭资源

4.3.2.2 重分区函数

Flink中的重分区函数:

* global();全部发往第一个* broadcast();广播* forward();前后并行度一样的时候一对一转发* shuffle();随机打乱* rebalance();重平衡* rescale();本地轮流分区,如前2后4,前1->,如前4后2,前2->1* partitionCustom:自定义分区

Spark里面也有重分区函数:

1)增加分区函数:repartition

函数名称:repartition,此函数使用的谨慎,会产生Shuffle。

注意: repartition底层调用coalesce(numPartitions, shuffle=true)

2)、减少分区函数:coalesce

函数名称:coalesce,shuffle参数默认为false,不会产生Shuffle,默认只能减少分区

比如RDD的分区数目为10个分区,此时调用rdd.coalesce(12),不会对RDD进行任何操作。

3)、调整分区函数

在PairRDDFunctions中partitionBy函数:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 object RDDDemo03_partition def main Array [String ]): Unit = {val sparkConf: SparkConf = new SparkConf ().setAppName("wc" ).setMaster("local[*]" )val sc: SparkContext = new SparkContext (sparkConf)"WARN" )val rdd1: RDD [String ] = sc.parallelize(List ("hadoop spark" , "hive flink" , "hive flink" ), 4 )val rdd2: RDD [String ] = rdd1.repartition(5 )val rdd3: RDD [String ] = rdd1.repartition(3 )val rdd4: RDD [String ] = rdd1.coalesce(5 )val rdd5: RDD [String ] = rdd1.coalesce(3 )val resultRDD = sc.textFile("data/input/words.txt" )" " ))1 )) val key: String = t._1val num: Int = TaskContext .getPartitionId()s"默认的hash分区器进行的分区:分区编号:${num} ,key:${key} " )val resultRDD2: RDD [(String , Int )] = sc.textFile("data/input/words.txt" )" " ))1 )) new MyPartitioner (1 ),_+_)val key: String = t._1val num: Int = TaskContext .getPartitionId()s"自定义分区器进行的分区:分区编号:${num} ,key:${key} " )class MyPartitioner (partitions: Int ) extends Partitioner override def numPartitions Int = partitionsoverride def getPartition Any ): Int = {0

4.3.2.3 聚合函数 4.3.2.3.1 没有key的聚合函数 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 object RDDDemo04_Aggregate {[String ] ): Unit = {val sparkConf: SparkConf = new SparkConf() .setAppName("wc" ) .setMaster("local[*]" ) val sc: SparkContext = new SparkContext(sparkConf ) LogLevel("WARN" ) val nums: RDD[Int ] = sc.parallelize( 1 to 10 ) val result1: Double = nums.sum() val result2: Int = nums.reduce(_+_)val result3: Int = nums.fold(0 )(_+_)val result4: Int = nums.aggregate(0 )(_+_,_+_)()

4.3.2.3.2 有key的聚合函数 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 object RDDDemo05_Aggregate {[String ] ): Unit = {val sparkConf: SparkConf = new SparkConf() .setAppName("wc" ) .setMaster("local[*]" ) val sc: SparkContext = new SparkContext(sparkConf ) LogLevel("WARN" ) val wordAndOne: RDD[(String , Int )] = sc.textFile("data/input/words.txt" ) Map(_ .split (" " ) )1 ))val groupedRDD: RDD[(String , Iterable [Int ] )] = wordAndOne.groupByKey() val result1: RDD[(String , Int )] = groupedRDD.mapValues(_ .sum ) val result2: RDD[(String , Int )] = wordAndOne.reduceByKey(_ +_ ) val result3: RDD[(String , Int )] = wordAndOne.aggregateByKey(0) (_+_,_+_)()

4.3.2.3.3 面试题:groupByKey和reduceByKey

区别1:reduceByKey代码简单一步搞定

区别2:reduceByKey比groupByKey性能要好

4.3.2.4 关联函数 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 object RDDDemo06_join {[String ] ): Unit = {val sparkConf: SparkConf = new SparkConf() .setAppName("wc" ) .setMaster("local[*]" ) val sc: SparkContext = new SparkContext(sparkConf ) LogLevel("WARN" ) val empRDD: RDD[(Int , String )] = sc.parallelize(Seq((1001, "zhangsan" ) , (1002 , "lisi" ), (1003 , "wangwu" ), (1004 , "zhangliu" ))val deptRDD: RDD[(Int , String )] = sc.parallelize(Seq((1001, "销售部" ) , (1002 , "技术部" ))val result1: RDD[(Int , (String , String ))] = empRDD.join(deptRDD)"============================" )val result2: RDD[(Int , (String , Option [String ] ))] = empRDD.leftOuterJoin(deptRDD ) ()

4.3.2.5 排序函数-求TopKey 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 object RDDDemo07_sort {[String ] ): Unit = {val sparkConf: SparkConf = new SparkConf() .setAppName("wc" ) .setMaster("local[*]" ) val sc: SparkContext = new SparkContext(sparkConf ) LogLevel("WARN" ) val result: RDD[(String , Int )] = sc.textFile("data/input/words.txt" ) Map(_ .split (" " ) )1 ))ByKey(_ + _ ) "============sortBy:适合大数据量排序====================" )val sortedResult1: RDD[(String , Int )] = result.sortBy(_ ._2 ,false ) 3 ).foreach(println)"============sortByKey:适合大数据量排序====================" )val sortedResult2: RDD[(Int , String )] = result.map(_ .ByKey(false ) 3 ).foreach(println)"============top:适合小数据量排序====================" )val sortedResult3: Array[(String , Int )] = result.top(2 )(Ordering ._ ._2 )()

4.4 RDD持久化与Checkpoint

在实际开发中某些RDD的计算或转换可能会比较耗费时间,如果这些RDD后续还会频繁的被使用到,那么可以将这些RDD进行持久化/缓存,这样下次再使用到的时候就不用再重新计算了,提高了程序运行的效率。

4.4.1 RDD持久化

缓存/持久化级别

在Spark框架中对数据缓存可以指定不同的级别,对于开发来说至关重要,如下所示:

持久化级别

说明

MEMORY_ONLY(默认)将RDD以非序列化的Java对象存储在JVM中。 如果没有足够的内存存储RDD,则某些分区将不会被缓存,每次需要时都会重新计算。 这是默认级别。

MEMORY_AND_DISK(开发中可以使用这个) 将RDD以非序列化的Java对象存储在JVM中。如果数据在内存中放不下,则溢写到磁盘上.需要时则会从磁盘上读取

MEMORY_ONLY_SER

(Java and Scala)

将RDD以序列化的Java对象(每个分区一个字节数组)的方式存储.这通常比非序列化对象(deserialized objects)更具空间效率,特别是在使用快速序列化的情况下,但是这种方式读取数据会消耗更多的CPU。

MEMORY_AND_DISK_SER (Java and Scala)

与MEMORY_ONLY_SER类似,但如果数据在内存中放不下,则溢写到磁盘上,而不是每次需要重新计算它们。

DISK_ONLY

将RDD分区存储在磁盘上。

MEMORY_ONLY_2, MEMORY_AND_DISK_2等

与上面的储存级别相同,只不过将持久化数据存为两份,备份每个分区存储在两个集群节点上。

OFF_HEAP(实验中)

与MEMORY_ONLY_SER类似,但将数据存储在堆外内存中。 (即不是直接存储在JVM内存中)

实际项目中缓存数据时,往往选择MEMORY_AND_DISK

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 object RDDDemo08_cache {[String ] ): Unit = {val sparkConf: SparkConf = new SparkConf() .setAppName("wc" ) .setMaster("local[*]" ) val sc: SparkContext = new SparkContext(sparkConf ) LogLevel("WARN" ) val result: RDD[(String , Int )] = sc.textFile("data/input/words.txt" ) Map(_ .split (" " ) )1 ))ByKey(_ + _ ) "============sortBy:适合大数据量排序====================" )val sortedResult1: RDD[(String , Int )] = result.sortBy(_ ._2 ,false ) 3 ).foreach(println)"============sortByKey:适合大数据量排序====================" )val sortedResult2: RDD[(Int , String )] = result.map(_ .ByKey(false ) 3 ).foreach(println)"============top:适合小数据量排序====================" )val sortedResult3: Array[(String , Int )] = result.top(3 )(Ordering ._ ._2 )() ()

4.4.2 RDD CheckPoint

RDD 数据可以持久化,但是持久化/缓存可以把数据放在内存中,虽然是快速的,但是也是最不可靠的;也可以把数据放在磁盘上,也不是完全可靠的!例如磁盘会损坏等。

Checkpoint的产生就是为了更加可靠的数据持久化,在Checkpoint的时候一般把数据放在在HDFS上,这就天然的借助了HDFS天生的高容错、高可靠来实现数据最大程度上的安全,实现了RDD的容错和高可用。

在Spark Core中对RDD做checkpoint,可以切断做checkpoint RDD的依赖关系,将RDD数据保存到可靠存储(如HDFS)以便数据恢复;

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 object RDDDemo09_checkpoint {[String ] ): Unit = {val sparkConf: SparkConf = new SparkConf() .setAppName("wc" ) .setMaster("local[*]" ) val sc: SparkContext = new SparkContext(sparkConf ) LogLevel("WARN" ) val result: RDD[(String , Int )] = sc.textFile("data/input/words.txt" ) Map(_ .split (" " ) )1 ))ByKey(_ + _ ) CheckpointDir("./ckp" ) () "============sortBy:适合大数据量排序====================" )val sortedResult1: RDD[(String , Int )] = result.sortBy(_ ._2 ,false ) 3 ).foreach(println)"============sortByKey:适合大数据量排序====================" )val sortedResult2: RDD[(Int , String )] = result.map(_ .ByKey(false ) 3 ).foreach(println)"============top:适合小数据量排序====================" )val sortedResult3: Array[(String , Int )] = result.top(3 )(Ordering ._ ._2 )() ()

4.4.3 总结:持久化和Checkpoint的区别

区别:1)、存储位置

Persist 和 Cache 只能保存在本地的磁盘和内存中(或者堆外内存);

Checkpoint 可以保存数据到 HDFS 这类可靠的存储上;

2)、生命周期

Cache和Persist的RDD会在程序结束后会被清除或者手动调用unpersist方法;

Checkpoint的RDD在程序结束后依然存在,不会被删除;

3)、Lineage(血统、依赖链、依赖关系)

Persist和Cache,不会丢掉RDD间的依赖链/依赖关系,因为这种缓存是不可靠的,如果出现了一些错误(例如 Executor 宕机),需要通过回溯依赖链重新计算出来;

Checkpoint会斩断依赖链,因为Checkpoint会把结果保存在HDFS这类存储中,更加的安全可靠,一般不需要回溯依赖链;

结论:怎么用!

实际开发对于计算复杂且后续会被频繁使用的RDD先进行缓存/持久化提高效率, 再使用Checkpoint保证数据觉得安全

sc.setCheckpointDir("hdfs路径")//实际开发写HDFS路径 checkpoint ()

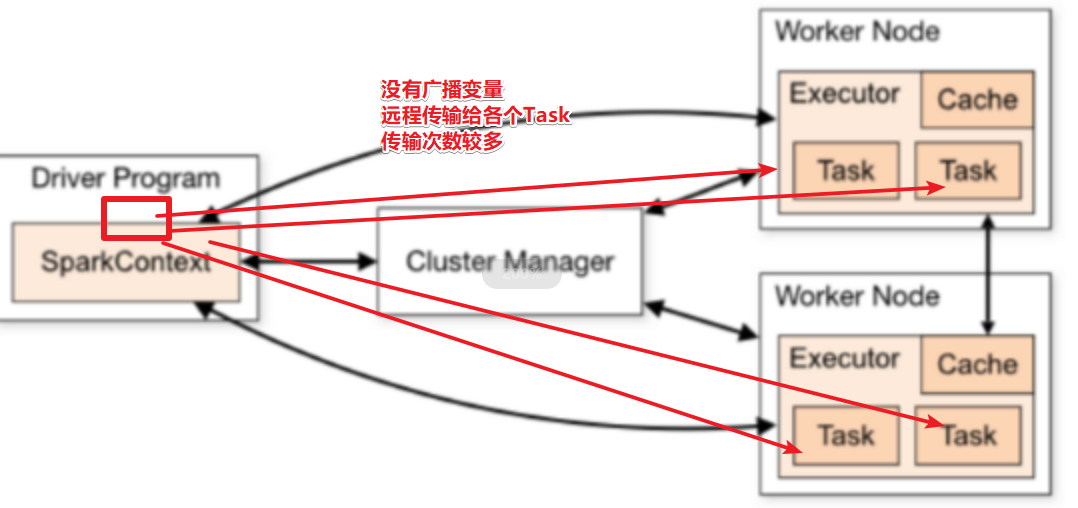

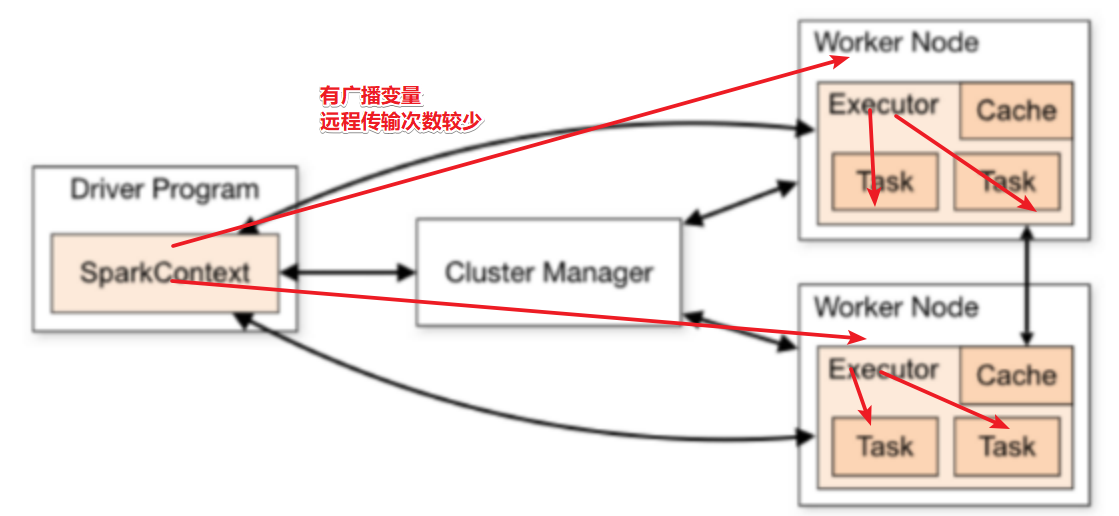

4.5 共享变量 4.5.1 广播变量

广播变量Broadcast Variables

和Flink中的广播变量一样,Spark中的广播变量也是将变量发送到各个Worker,然后各个Worker上的各个分区任务去各自的Worker上读取, 避免发给各个分区

广播变量是不可变的, 如果数据有变化需要重新广播,

广播变量的数据不能太大

4.5.2 累加器

累加器Accumulators

和Flink的累加器一样

4.5.3 示例

words2.txt

hadoop spark # hadoop spark spark

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 object RDDDemo10_ShareVariable {[String ] ): Unit = {val sparkConf: SparkConf = new SparkConf() .setAppName("wc" ) .setMaster("local[*]" ) val sc: SparkContext = new SparkContext(sparkConf ) LogLevel("WARN" ) val dataRDD: RDD[String ] = sc.textFile("data/input/words2.txt" , minPartitions = 2) val list : List[String ] = List("," , "." , "!" , "#" , "$" , "%" ) val broadcast: Broadcast[List [String ] ] = sc.broadcast(list )val accumulator: LongAccumulator = sc.longAccumulator("my-counter" ) val result: RDD[(String , Int )] = dataRDDStringUtils .NotBlank(_ ) )Map(_ .split ("\\s+" ) ) val workerList: List[String ] = broadcast.valueif (workerList.contains(value)) {1 )false else {true 1 ))ByKey(_ + _ ) "wordcount的结果为:" )"获取到的累加器的值/特殊字符的总数为:" +accumulator.value)()

4.6 外部数据源-了解

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 object RDDDemo11_externalDataSource{[String ] ): Unit = {val sparkConf: SparkConf = new SparkConf() .setAppName("wc" ) .setMaster("local[*]" ) val sc: SparkContext = new SparkContext(sparkConf ) LogLevel("WARN" ) val result: RDD[(String , Int )] = sc.textFile("data/input/words.txt" ) Map(_ .split (" " ) )1 )) ByKey(_ + _ ) 1 ).saveAsSequenceFile("data/output/sequence" ) 1 ).saveAsObjectFile("data/output/object" ) val rdd1: RDD[(String , Int )] = sc.sequenceFile("data/output/sequence" ) val rdd2: RDD[(String , Int )] = sc.object File("data/output/object" ) ()

4.6.1 Mysql数据源 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 object RDDDemo12_jdbc{Unit = {val sparkConf: SparkConf = new SparkConf().setAppName("wc" ).setMaster("local[*]" )val sc: SparkContext = new SparkContext(sparkConf)"WARN" )val data : RDD[(String, Int )] = sc.parallelize(List(("jack" , 18 ), ("tom" , 19 ), ("rose" , 20 )))data .foreachPartition(rows=>{val conn: Connection = DriverManager.getConnection("jdbc:mysql://192.168.88.161:3306/bigdata?characterEncoding=UTF-8" ,"root" ,"123456" )val sql:String = "INSERT INTO `t_student` (`id`, `name`, `age`) VALUES (NULL, ?, ?);" val ps: PreparedStatement = conn.prepareStatement(sql)val name: String = row._1val age: Int = row._21 ,name)2 ,age)if (conn != null ) conn.close()if (ps != null ) ps.close()val getConnection = () =>DriverManager.getConnection("jdbc:mysql://192.168.88.161:3306/bigdata?characterEncoding=UTF-8" ,"root" ,"123456" )val querySQL = "select id,name,age from t_student where ? <= id and id <= ?" val mapRow = (rs:ResultSet) =>{val id: Int = rs.getInt("id" )val name: String = rs.getString("name" )val age: Int = rs.getInt("age" )val studentRDD = new JdbcRDD[(Int , String, Int )](4 , 6 , 2 ,

4.6.2 HBase数据源

后续学习需要的时候直接使用工具类!

因为原生API很难用!

https://github.com/teeyog/blog/issues/22

https://blog.csdn.net/u011817217/article/details/81667115

4.7 Spark内核原理

Spark的核心是根据RDD来实现的,Spark Scheduler则为Spark核心实现的重要一环,其作用就是任务调度。Spark的任务调度就是如何组织任务去处理RDD中每个分区的数据,根据RDD的依赖关系构建DAG,基于DAG划分Stage,将每个Stage中的任务发到指定节点运行。基于Spark的任务调度原理,可以合理规划资源利用,做到尽可能用最少的资源高效地完成任务计算。

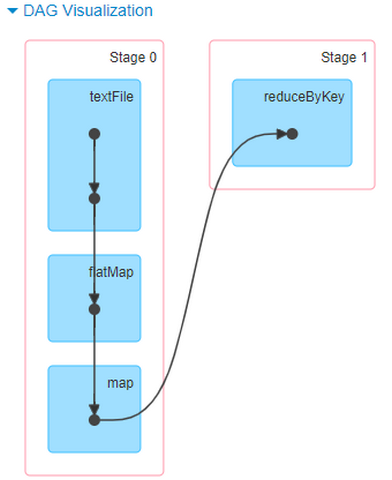

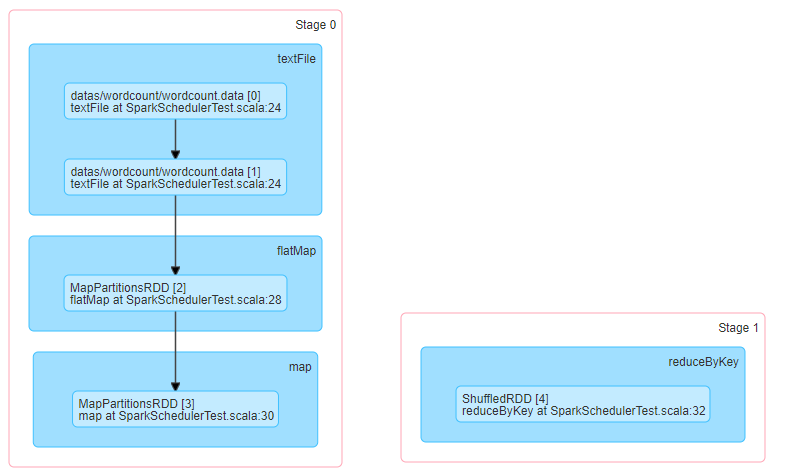

以词频统计WordCount程序为例,Job执行是DAG图:

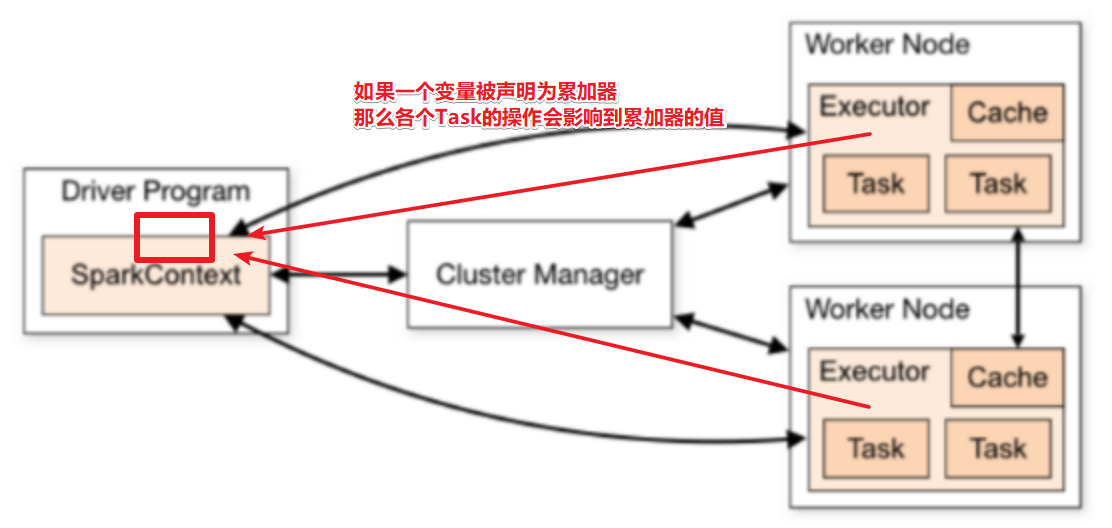

4.7.1 RDD 依赖

RDD 的容错机制是通过将 RDD 间转移操作构建成有向无环图来实现的。从抽象的角度看,RDD 间存在着血统继承关系,其本质上是 RDD之间的依赖(Dependency)关系。

从图的角度看,RDD 为节点,在一次转换操作中,创建得到的新 RDD 称为子 RDD,同时会产生新的边,即依赖关系,子 RDD 依赖向上依赖的 RDD 便是父 RDD,可能会存在多个父 RDD。可以将这种依赖关系进一步分为两类,分别是窄依赖(NarrowDependency)和 Shuffle 依赖(Shuffle Dependency 在部分文献中也被称为 Wide Dependency,即宽依赖)。

4.7.1.1 窄依赖(Narrow Dependency)

窄依赖中:即父 RDD 与子 RDD 间的分区是一对一的。换句话说父RDD中,一个分区内的数据是不能被分割的,只能由子RDD中的一个分区整个利用。

上图中 P代表 RDD中的每个分区(Partition),我们看到,RDD 中每个分区内的数据在上面的几种转移操作之后被一个分区所使用,即其依赖的父分区只有一个。比如图中的 map、union 和 join 操作,都是窄依赖的。注意,join 操作比较特殊,可能同时存在宽、窄依赖。

4.7.1.2 Shuffle 依赖(宽依赖 Wide Dependency)

Shuffle 有“洗牌、搅乱”的意思,这里所谓的 Shuffle 依赖也会打乱原 RDD 结构的操作。具体来说,父 RDD 中的分区可能会被多个子 RDD 分区使用。因为父 RDD 中一个分区内的数据会被分割并发送给子 RDD 的所有分区,因此 Shuffle 依赖也意味着父 RDD与子 RDD 之间存在着 Shuffle 过程。

上图中 P 代表 RDD 中的多个分区,我们会发现对于 Shuffle 类操作而言,结果 RDD 中的每个分区可能会依赖多个父 RDD 中的分区。需要说明的是,依赖关系是 RDD 到 RDD 之间的一种映射关系,是两个 RDD 之间的依赖,如果在一次操作中涉及多个父 RDD,也有可能同时包含窄依赖和 Shuffle 依赖。

4.7.1.3 如何区分宽窄依赖

区分RDD之间的依赖为宽依赖还是窄依赖,主要在于父RDD分区数据与子RDD分区数据关系:

窄依赖:父RDD的一个分区只会被子RDD的一个分区依赖;宽依赖:父RDD的一个分区会被子RDD的多个分区依赖,涉及Shuffle;

为什么要设计宽窄依赖??

1)、对于窄依赖来说

Spark可以并行计算

如果有一个分区数据丢失,只需要从父RDD的对应个分区重新计算即可,不需要重新计算整个任务,提高容错。

2)、对应宽依赖来说

划分Stage的依据,产生Shuffle

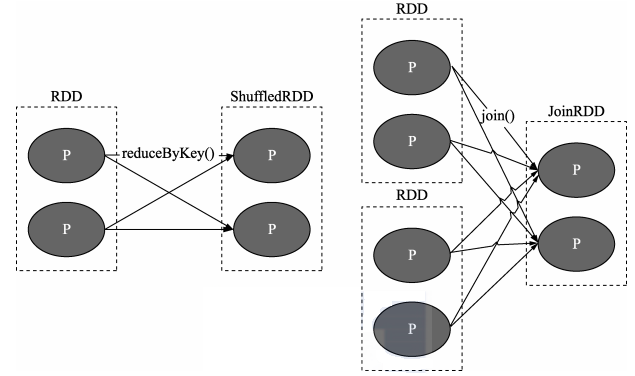

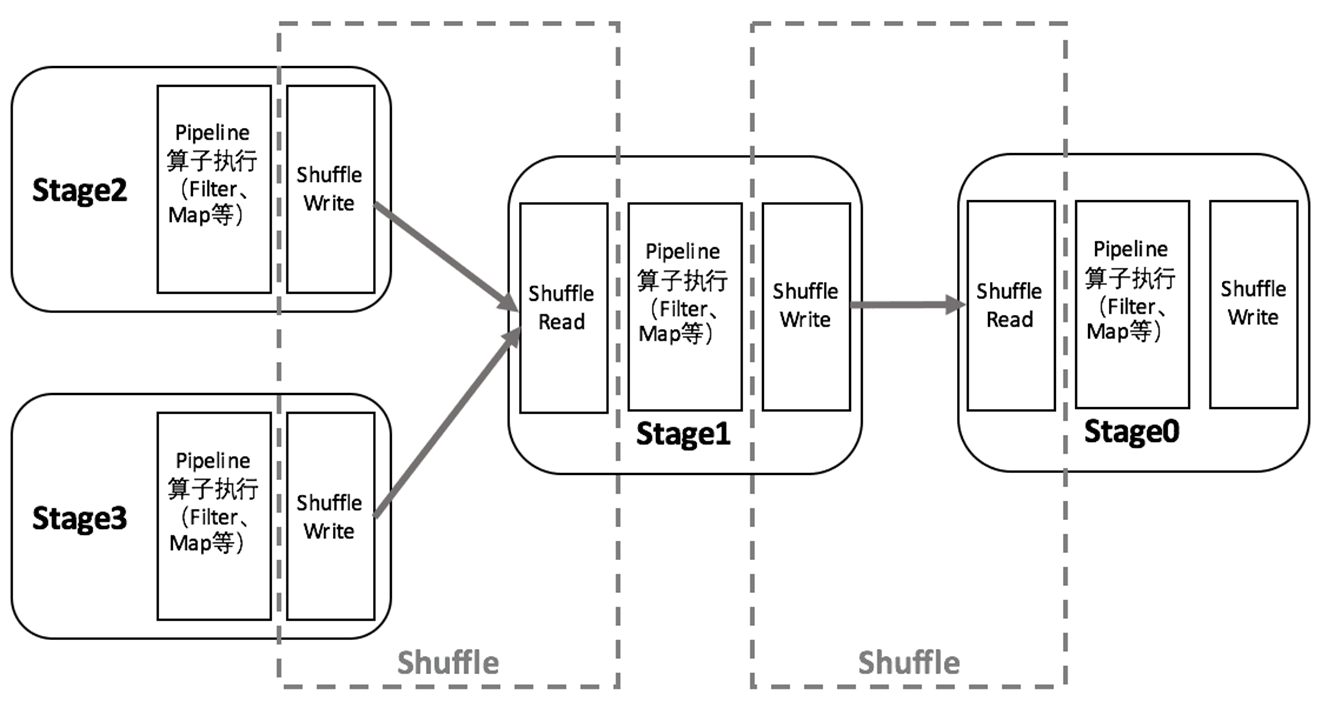

4.7.2 DAG和Stage

在图论中,如果一个有向图无法从任意顶点出发经过若干条边回到该点,则这个图是一个有向无环图(DAG图)。而在Spark中,由于计算过程很多时候会有先后顺序,受制于某些任务必须比另一些任务较早执行的限制,必须对任务进行排队,形成一个队列的任务集合,这个队列的任务集合就是DAG图,每一个定点就是一个任务,每一条边代表一种限制约束(Spark中的依赖关系)。

Spark中DAG生成过程的重点是对Stage的划分,其划分的依据是RDD的依赖关系,对于不同的依赖关系,高层调度器会进行不同的处理。

对于窄依赖,RDD之间的数据不需要进行Shuffle,多个数据处理可以在同一台机器的内存中完成,所以窄依赖在Spark中被划分为同一个Stage;

对于宽依赖,由于Shuffle的存在,必须等到父RDD的Shuffle处理完成后,才能开始接下来的计算,所以会在此处进行Stage的切分。

在Spark中,DAG生成的流程关键在于回溯,在程序提交后,高层调度器将所有的RDD看成是一个Stage,然后对此Stage进行从后往前的回溯,遇到Shuffle就断开,遇到窄依赖,则归并到同一个Stage。等到所有的步骤回溯完成,便生成一个DAG图。

把DAG划分成互相依赖的多个Stage,划分依据是RDD之间的宽依赖,Stage是由一组并行的Task组成。Stage切割规则:从后往前,遇到宽依赖就切割Stage。

Stage计算模式:pipeline管道计算模式,pipeline只是一种计算思想、模式,来一条数据然后计算一条数据,把所有的逻辑走完,然后落地。准确的说:一个task处理一串分区的数据,整个计算逻辑全部走完。

4.7.3 Spark基本概念

官方文档:http://spark.apache.org/docs/2.4.5/cluster-overview.html#glossary

Spark Application运行时,涵盖很多概念,主要如下表格:

1.Application:应用,就是程序员编写的Spark代码,如WordCount代码

2.Driver:驱动,就是用来执行main方法的JVM进程,里面会执行一些Drive端的代码,如创建SparkContext,设置应用名,设置日志级别…

3.SparkContext:Spark运行时的上下文环境,用来和ClusterManager进行通信的,并进行资源的申请、任务的分配和监控等

4.ClusterManager:集群管理器,对于Standalone模式,就是Master,对于Yarn模式就是ResourceManager/ApplicationMaster,在集群上做统一的资源管理的进程

5.Worker:工作节点,是拥有CPU/内存的机器,是真正干活的节点

6.Executor:运行在Worker中的JVM进程!

7.RDD:弹性分布式数据集

8.DAG:有向无环图,就是根据Action形成的RDD的执行流程图—静态的图

9.Job:作业,按照DAG进行执行就形成了Job—按照图动态的执行

10.Stage:DAG中,根据shuffle依赖划分出来的一个个的执行阶段!

11.Task:一个分区上的一系列操作(pipline上的一系列操作)就是一个Task,同一个Stage中的多个Task可以并行执行!(每一个Task由线程执行),所以也可以这样说:Task(线程)是运行在Executor(进程)中的最小单位!

12.TaskSet:任务集,就是同一个Stage中的各个Task组成的集合!

4.7.4 Job调度流程

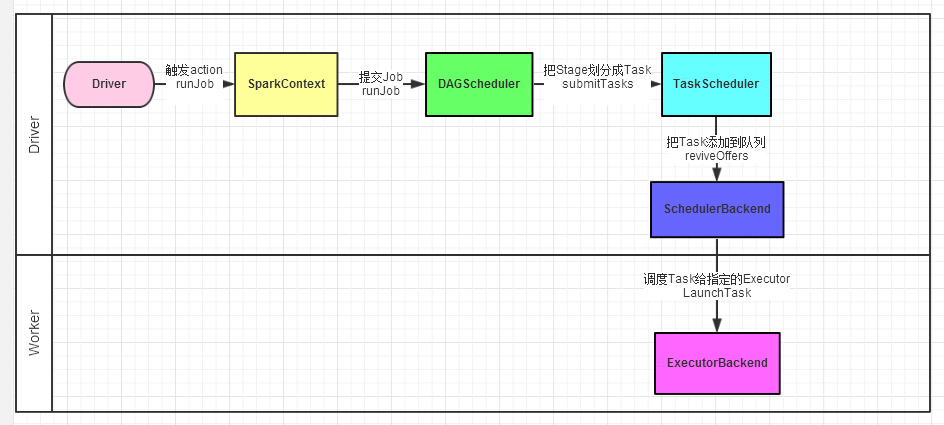

Spark运行基本流程

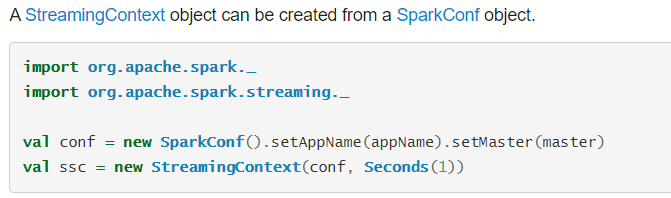

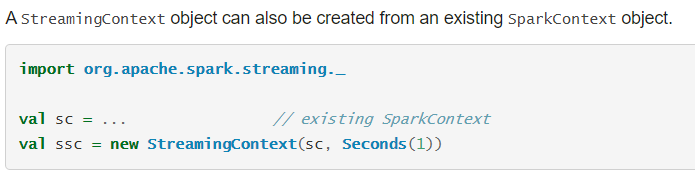

1.当一个Spark应用被提交时,首先需要为这个Spark Application构建基本的运行环境,即由任务控制节点(Driver)创建一个SparkContext(还会构建DAGScheduler和TaskScheduler)

2.SparkContext向资源管理器注册并申请运行Executor资源;

3.资源管理器为Executor分配资源并启动Executor进程,Executor运行情况将随着心跳发送到资源管理器上;

4.SparkContext根据RDD的依赖关系构建成DAG图,并提交给DAGScheduler进行解析划分成Stage,并把该Stage中的Task组成的Taskset发送给TaskScheduler。

5.TaskScheduler将Task发放给Executor运行,同时SparkContext将应用程序代码发放给Executor。

6.Executor将Task丢入到线程池中执行,把执行结果反馈给任务调度器,然后反馈给DAG调度器,运行完毕后写入数据并释放所有资源。

Spark Application应用的用户代码都是基于RDD的一系列计算操作,实际运行时,这些计算操作是Lazy执行的,并不是所有的RDD操作都会触发Spark往Cluster上提交实际作业,基本上只有一些需要返回数据或者向外部输出的操作才会触发实际计算工作(Action算子),其它的变换操作基本上只是生成对应的RDD记录依赖关系(Transformation算子)。

当RDD调用Action函数(比如count、saveTextFile或foreachPartition)时,触发一个Job执行,调度中流程如下图所示:

Spark RDD通过其Transactions操作,形成了RDD血缘关系图,即DAG,最后通过Action的调用,触发Job并调度执行。

Spark的任务调度总体来说分两路进行:Stage级的调度和Task级的调度

DAGScheduler负责Stage级的调度,主要是将DAG依据RDD宽依赖切分成若干Stages,并将每个Stage打包成TaskSet交给TaskScheduler调度。

TaskScheduler负责Task级的调度,将DAGScheduler给过来的TaskSet按照指定的调度策略分发到Executor上执行,调度过程中SchedulerBackend负责提供可用资源,其中SchedulerBackend有多种实现,分别对接不同的资源管理系统。

一个Spark应用程序包括Job、Stage及Task:

Job/DAG是以Action方法为界,遇到一个Action方法则触发一个Job;

Stage是Job的子集,以RDD宽依赖(即Shuffle)为界,遇到Shuffle做一次划分;

Task是Stage的子集,以并行度(分区数)来衡量,分区数是多少,则有多少个task。

4.7.5 扩展阅读:Spark并行度 4.7.5.1 资源并行度与数据并行度

在Spark Application运行时,并行度可以从两个方面理解:

1)、资源的并行度:由节点数(executor)和cpu数(core)决定的

2)、数据的并行度:task的数据,partition大小

task又分为map时的task和reduce(shuffle)时的task;

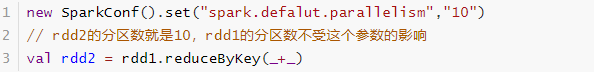

task的数目和很多因素有关,资源的总core数,spark.default.parallelism参数,spark.sql.shuffle.partitions参数,读取数据源的类型,shuffle方法的第二个参数,repartition的数目等等。

如果core有多少Task就有多少,那么有些比较快的task执行完了,一些资源就会处于等待的状态。

如果Task的数量多,能用的资源也多,那么并行度自然就好。

如果Task的数据少,资源很多,有一定的浪费,但是也还好。

如果Task数目很多,但是资源少,那么会执行完一批,再执行下一批。

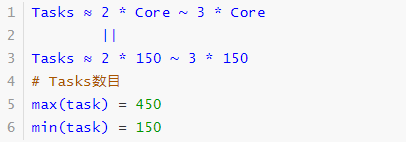

所以官方给出的建议是,这个Task数目要是core总数的2-3倍为佳。

4.7.5.2 案例1

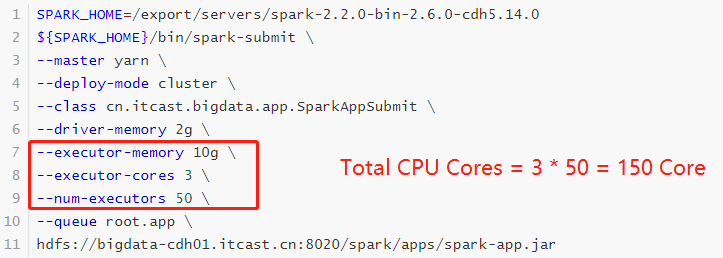

将Task/Partition/Parallelism数量设置成与Application总CPU Core 数量相同

150个core,理想情况,设置150 Task

与理想情况不同的是: 有些Task会运行快一点,比如50s就完了, 有些Task可能会慢一点,要一分半才运行完,

如果你的Task数量,刚好设置的跟CPU Core数量相同,也可能会导致资源的浪费,比如150 Task,10个先运行完了,剩余140个还在运行,但是这个时候,就有10个CPU Core空闲出来了,导致浪费。

如果设置2~3倍,那么一个Task运行完以后,另外一个Task马上补上来,尽量让CPU Core不要空闲。

所以,官方推荐,Task数量,设置成Application总CPU Core数量的2~3倍(150个cpu core,设置task数量为300~500

参数spark.defalut.parallelism默认是没有值的,如果设置了值,是在shuffle的过程才会起作用

4.7.5.3 案例2

当提交一个Spark Application时,设置资源信息如下,基本已经达到了集群或者yarn队列的资源上限:

Task设置为100个task ,平均分配一下,每个executor 分配到2个task,每个executor 剩下的一个cpu core 就浪费掉了!

虽然分配充足了,但是问题是:并行度没有与资源相匹配,导致你分配下去的资源都浪费掉了。合理的并行度的设置,应该要设置的足够大,大到可以完全合理的利用你的集群资源。可以调整Task数目,按照原则:Task数量,设置成Application总CPU Core数量的2~3倍

4.7.6 扩展阅读:Spark Shuffle

MapReduce框架中Shuffle过程,整体流程图如下:

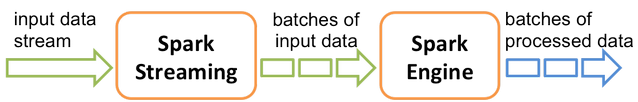

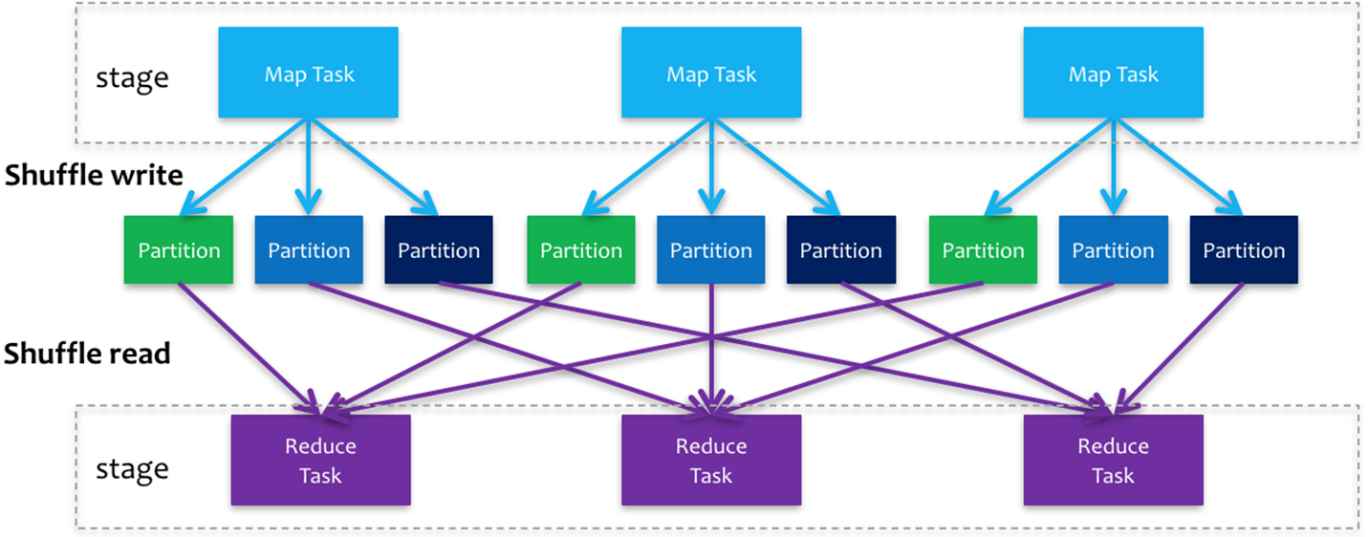

Spark在DAG调度阶段会将一个Job划分为多个Stage,上游Stage做map工作,下游Stage做reduce工作,其本质上还是MapReduce计算框架。Shuffle是连接map和reduce之间的桥梁,它将map的输出对应到reduce输入中,涉及到序列化反序列化、跨节点网络IO以及磁盘读写IO等。

Spark的Shuffle分为Write和Read两个阶段,分属于两个不同的Stage,前者是Parent Stage的最后一步,后者是Child Stage的第一步。

执行Shuffle的主体是Stage中的并发任务,这些任务分ShuffleMapTask和ResultTask两种,ShuffleMapTask要进行Shuffle,ResultTask负责返回计算结果,一个Job中只有最后的Stage采用ResultTask,其他的均为ShuffleMapTask。如果要按照map端和reduce端来分析的话,ShuffleMapTask可以即是map端任务,又是reduce端任务,因为Spark中的Shuffle是可以串行的;ResultTask则只能充当reduce端任务的角色。

Spark在1.1以前的版本一直是采用Hash Shuffle的实现的方式,到1.1版本时参考Hadoop MapReduce的实现开始引入Sort Shuffle,在1.5版本时开始Tungsten钨丝计划,引入UnSafe Shuffle优化内存及CPU的使用,在1.6中将Tungsten统一到Sort Shuffle中,实现自我感知选择最佳Shuffle方式,到的2.0版本,Hash Shuffle已被删除,所有Shuffle方式全部统一到Sort Shuffle一个实现中。

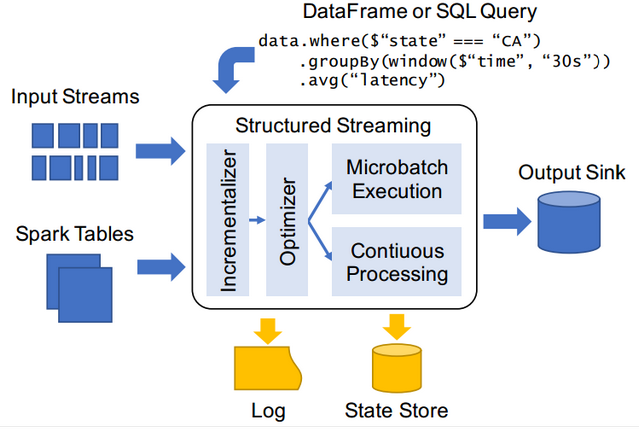

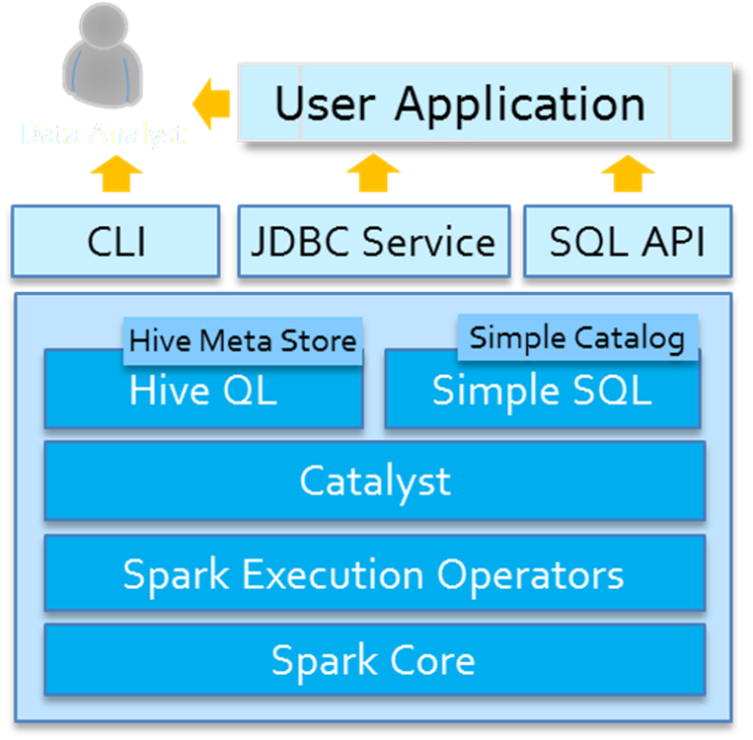

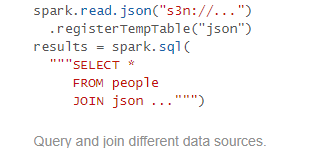

5 Spark SQL 5.1 SparkSQL概述

Spark SQL允许开发人员直接处理RDD,同时可以查询在Hive上存储的外部数据。Spark SQL的一个重要特点就是能够统一处理关系表和RDD,使得开发人员可以轻松的使用SQL命令进行外部查询,同时进行更加复杂的数据分析。

5.1.1 前世今生

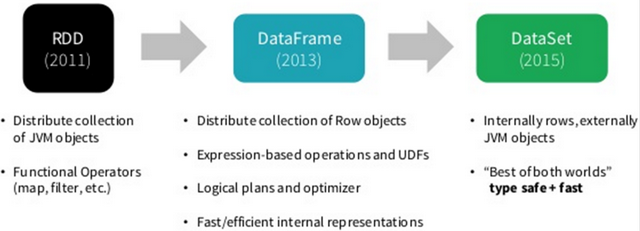

SparkSQL模块一直到Spark 2.0版本才算真正稳定,发挥其巨大功能,发展经历如下几个阶段。

5.1.1.1 Shark框架

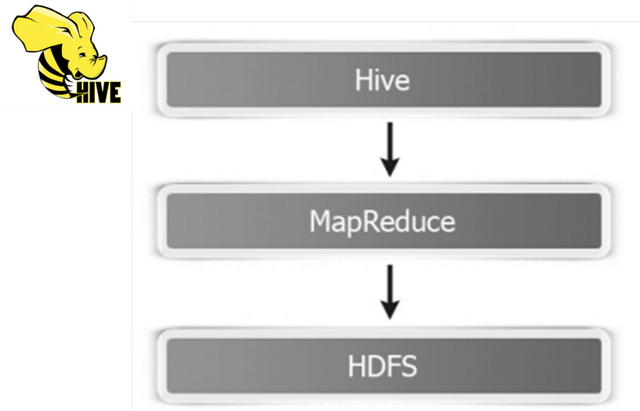

首先回顾SQL On Hadoopp框架:Hive(可以说Hive时大数据生态系统中第一个SQL框架),架构如下所示:

可以发现Hive框架底层就是MapReduce,所以在Hive中执行SQL时,往往很慢很慢。

Spark出现以后,将HiveQL语句翻译成基于RDD操作,此时Shark框架诞生了。

Spark SQL的前身是Shark,它发布时Hive可以说是SQL on Hadoop的唯一选择(Hive负责将SQL编译成可扩展的MapReduce作业),鉴于Hive的性能以及与Spark的兼容,Shark由此而生。Shark即Hive on Spark,本质上是通过Hive的HQL进行解析,把HQL翻译成Spark上对应的RDD操作,然后通过Hive的Metadata获取数据库里表的信息,实际为HDFS上的数据和文件,最后有Shark获取并放到Spark上计算。

但是Shark框架更多是对Hive的改造,替换了Hive的物理执行引擎,使之有一个较快的处理速度。然而不容忽视的是Shark继承了大量的Hive代码,因此给优化和维护带来大量的麻烦。为了更好的发展,Databricks在2014年7月1日Spark Summit上宣布终止对Shark的开发,将重点放到SparkSQL模块上。

文档:https://databricks.com/blog/2014/07/01/shark-spark-sql-hive-on-spark-and-the-future-of-sql-on-spark.html

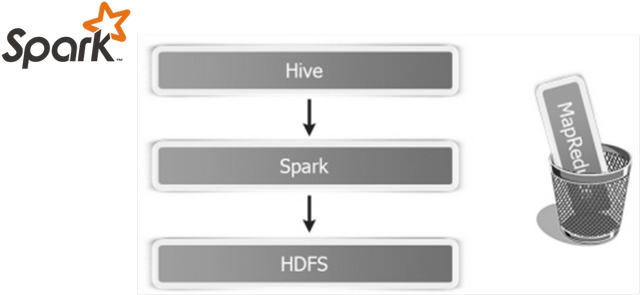

SparkSQL模块主要将以前依赖Hive框架代码实现的功能自己实现,称为Catalyst引擎。

5.1.1.2 SparkSQL模块

从Spark框架1.0开始发布SparkSQL模块开发,直到1.3版本发布SparkSQL Release版本可以在生产环境使用,此时数据结构为DataFrame = RDD + Schame。

1)、解决的问题

Spark SQL 执行计划和优化交给优化器 Catalyst;

内建了一套简单的SQL解析器,可以不使用HQL;

还引入和 DataFrame 这样的DSL API,完全可以不依赖任何 Hive 的组件;

2)、新的问题

对于初期版本的SparkSQL,依然有挺多问题,例如只能支持SQL的使用,不能很好的兼容命令式,入口不够统一等;

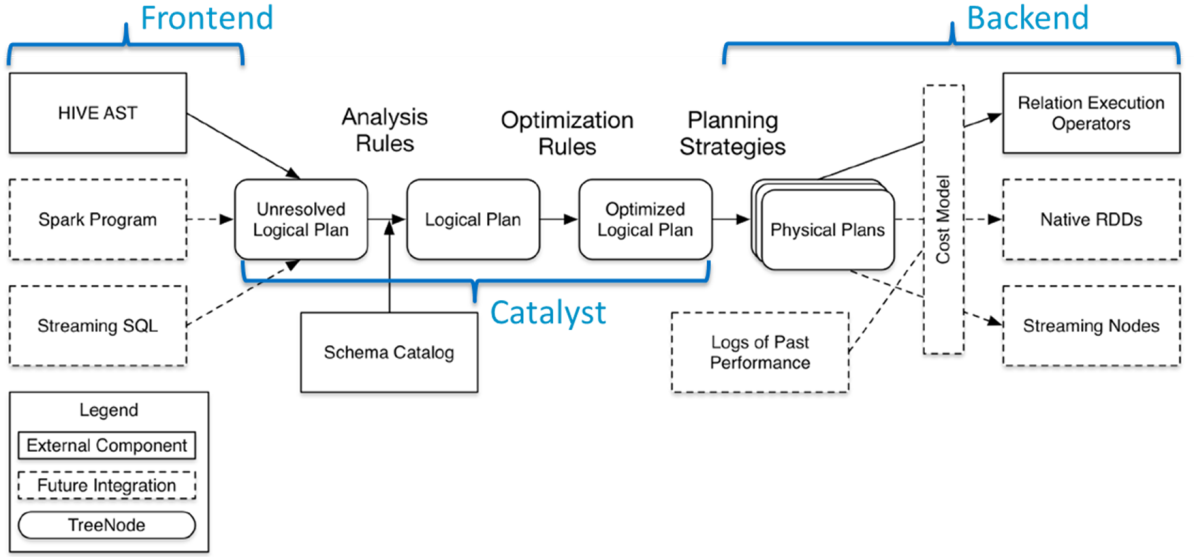

SparkSQL 在 1.6 时代,增加了一个新的API叫做 Dataset,Dataset 统一和结合了 SQL 的访问和命令式 API 的使用,这是一个划时代的进步。在 Dataset 中可以轻易的做到使用 SQL 查询并且筛选数据,然后使用命令式 API 进行探索式分析。

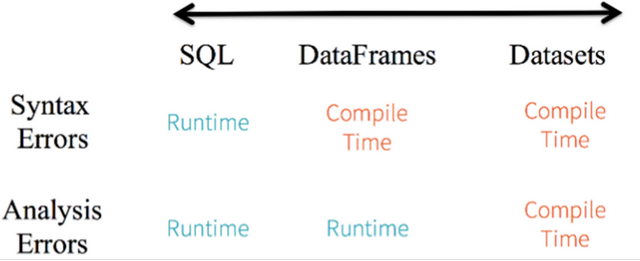

Spark 2.x发布时,将Dataset和DataFrame统一为一套API,以Dataset数据结构为主(Dataset = RDD + Schema),其中DataFrame = Dataset[Row]。

5.1.1.3 Hive与SparkSQL

从SparkSQL模块前世今生可以发现,从Hive框架衍生逐渐发展而来,Hive框架提供功能SparkSQL几乎全部都有,并且SparkSQL完全兼容Hive,从其加载数据进行处理。

Hive是将SQL转为MapReduce,SparkSQL可以理解成是将SQL解析成RDD + 优化再执行。

5.1.2 官方定义

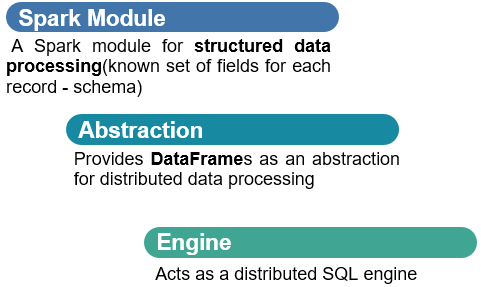

SparkSQL模块官方定义:针对结构化数据处理Spark Module模块。

主要包含三层含义:

第一、针对结构化数据处理,属于Spark框架一个部分

结构化数据:一般指数据有固定的 Schema(约束),例如在用户表中,name 字段是 String 型,那么每一条数据的 name 字段值都可以当作 String 来使用;

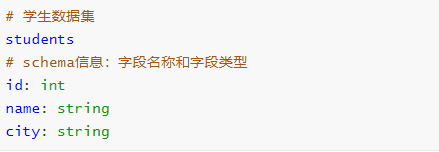

schema信息,包含字段的名称和字段的类型,比如:JSON、XML、CSV、TSV、MySQL Table、ORC、Parquet,ES、MongoDB等都是结构化数据;

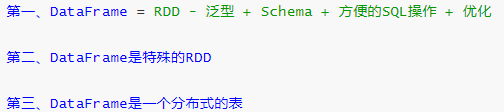

第二、抽象数据结构:DataFrame

将要处理的结构化数据封装在DataFrame中,来源Python数据分析库Pandas和R语言dataframe;

DataFrame = RDD + Schema信息;

第三、分布式SQL引擎,类似Hive框架

从Hive框架继承而来,Hive中提供bin/hive交互式SQL命令行及HiveServer2服务,SparkSQL都可以;

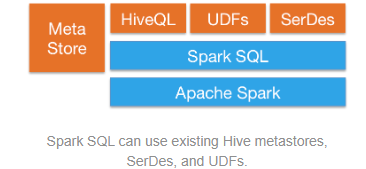

Spark SQL模块架构示意图如下:

5.1.3 SparkSQL特性

Spark SQL是Spark用来处理结构化数据的一个模块,主要四个特性:

第一、易整合

可以使用Java、Scala、Python、R等语言的API操作。

第二、统一的数据访问

连接到任何数据源的方式相同。

第三、兼容Hive

支持Hive HQL的语法,兼容hive(元数据库、SQL语法、UDF、序列化、反序列化机制)。

第四、标准的数据连接

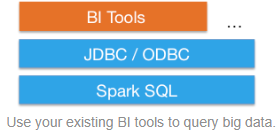

可以使用行业标准的JDBC或ODBC连接。

SparkSQL模块官方文档:http://spark.apache.org/docs/2.4.5/sql-programming-guide.html

5.2 SparkSQL数据抽象 5.2.1 DataFrame 5.2.1.1 引入

就易用性而言,对比传统的MapReduce API,Spark的RDD API有了数量级的飞跃并不为过。然而,对于没有MapReduce和函数式编程经验的新手来说,RDD API仍然存在着一定的门槛。

另一方面,数据科学家们所熟悉的R、Pandas等传统数据框架虽然提供了直观的API,却局限于单机处理,无法胜任大数据场景。

为了解决这一矛盾,Spark SQL 1.3.0在原有SchemaRDD的基础上提供了与R和Pandas风格类似的DataFrame API。

新的DataFrame AP不仅可以大幅度降低普通开发者的学习门槛,同时还支持Scala、Java与Python三种语言。更重要的是,由于脱胎自SchemaRDD,DataFrame天然适用于分布式大数据场景。

注意:

DataFrame它不是Spark SQL提出来的,而是早期在R、Pandas语言就已经有了的。

5.2.1.2 DataFrame是什么

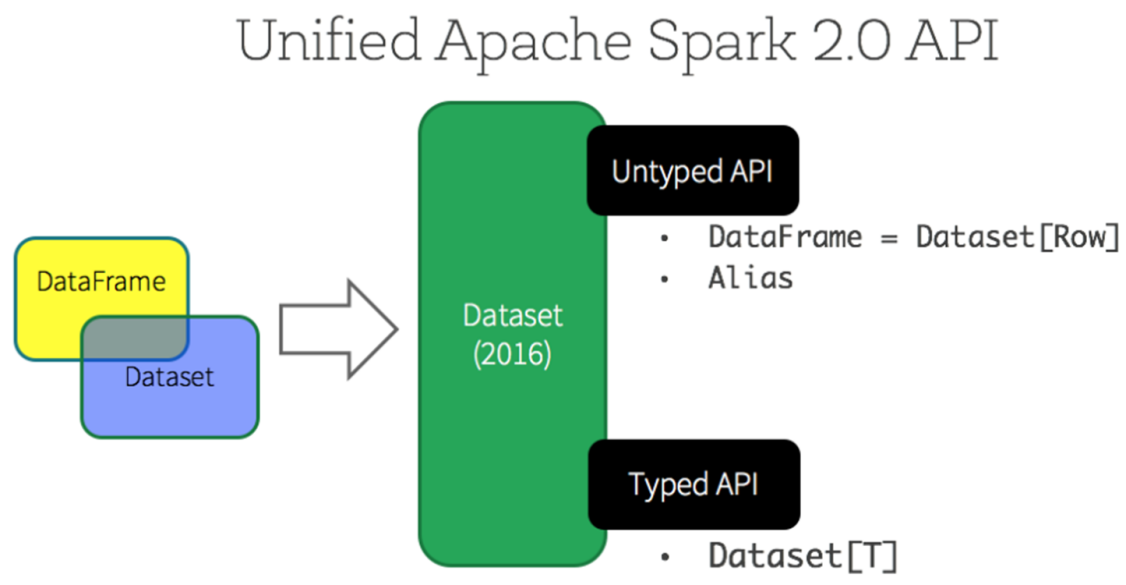

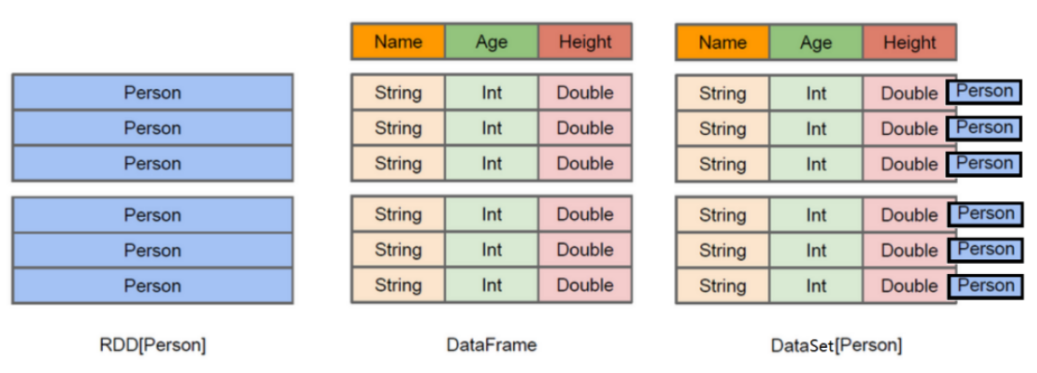

在Spark中,DataFrame是一种以RDD为基础的分布式数据集,类似于传统数据库中的二维表格。DataFrame与RDD的主要区别在于,前者带有schema元信息,即DataFrame所表示的二维表数据集的每一列都带有名称和类型。

使得Spark SQL得以洞察更多的结构信息,从而对藏于DataFrame背后的数据源以及作用于DataFrame之上的变换进行针对性的优化,最终达到大幅提升运行时效率。反观RDD,由于无从得知所存数据元素的具体内部结构,Spark Core只能在stage层面进行简单、通用的流水线优化。

上图中左侧的RDD[Person]虽然以Person为类型参数,但Spark框架本身不了解Person类的内部结构。而中间的DataFrame却提供了详细的结构信息,使得Spark SQL可以清楚地知道该数据集中包含哪些列,每列的名称和类型各是什么。了解了这些信息之后,Spark SQL的查询优化器就可以进行针对性的优化。后者由于在编译期有详尽的类型信息,编译期就可以编译出更加有针对性、更加优化的可执行代码。官方定义:

Dataset:A DataSet is a distributed collection of data. (分布式的数据集)

DataFrame: A DataFrame is a DataSet organized into named columns.(以列(列名,列类型,列值)的形式构成的分布式的数据集,按照列赋予不同的名称)

DataFrame有如下特性:

1 )、分布式的数据集,并且以列的方式组合的,相当于具有schema 的RDD;2 )、相当于关系型数据库中的表,但是底层有优化;3 )、提供了一些抽象的操作,如select 、filter 、aggregation、plot;4 )、它是由于R语言或者Pandas语言处理小数据集的经验应用到处理分布式大数据集上;5 )、在1.3 版本之前,叫SchemaRDD;

5.2.1.3 Schema信息

查看DataFrame中Schema是什么,执行如下命令:

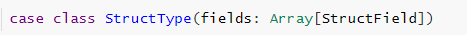

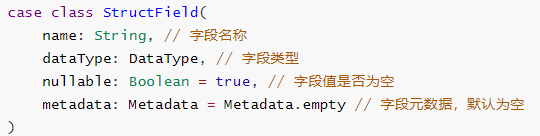

Schema信息封装在StructType中,包含很多StructField对象,源码。

StructType 定义,是一个样例类,属性为StructField的数组

StructField 定义,同样是一个样例类,有四个属性,其中字段名称和类型为必填

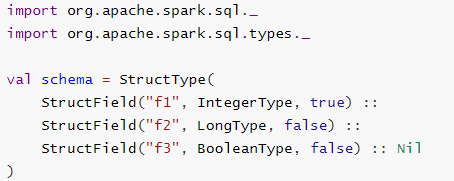

自定义Schema结构,官方提供的示例代码:

5.2.1.4 Row

DataFrame中每条数据封装在Row中,Row表示每行数据

如何构建Row对象:要么是传递value,要么传递Seq,官方实例代码:

import org.apache.spark.sql._Row(value1 , value2 , value3 , ... ) Row .Seq(Seq(value1 , value2 , ... ) )

如何获取Row中每个字段的值呢????

方式一:下标获取,从0开始,类似数组下标获取

方式二:指定下标,知道类型

方式三:通过As转换类型

5.2.2 DataSet 5.2.2.1 引入

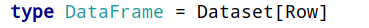

Spark在Spark 1.3版本中引入了Dataframe,DataFrame是组织到命名列中的分布式数据集合,但是有如下几点限制:

编译时类型不安全:

Dataframe API不支持编译时安全性,这限制了在结构不知道时操纵数据。

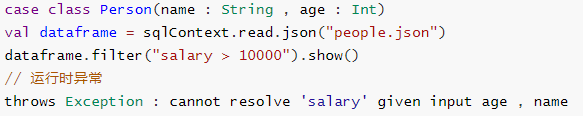

以下示例在编译期间有效。但是,执行此代码时将出现运行时异常。

无法对域对象(丢失域对象)进行操作:

将域对象转换为DataFrame后,无法从中重新生成它;

下面的示例中,一旦我们从personRDD创建personDF,将不会恢复Person类的原始RDD(RDD [Person]);

基于上述的两点,从Spark 1.6开始出现Dataset,至Spark 2.0中将DataFrame与Dataset合并,其中DataFrame为Dataset特殊类型,类型为Row。

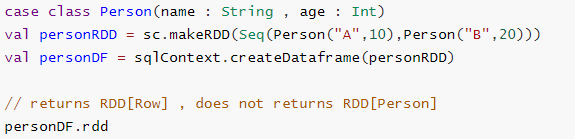

针对RDD、DataFrame与Dataset三者编程比较来说,Dataset API无论语法错误和分析错误在编译时都能发现,然而RDD和DataFrame有的需要在运行时才能发现。

此外RDD与Dataset相比较而言,由于Dataset数据使用特殊编码,所以在存储数据时更加节省内存。

总结:

Dataset是在Spark1.6中添加的新的接口,是DataFrame API的一个扩展,是Spark最新的数据抽象,结合了RDD和DataFrame的优点。

与RDD相比:保存了更多的描述信息,概念上等同于关系型数据库中的二维表;

与DataFrame相比:保存了类型信息,是强类型的,提供了编译时类型检查,调用Dataset的方法先会生成逻辑计划,然后被Spark的优化器进行优化,最终生成物理计划,然后提交到集群中运行;

5.2.2.2 DataSet是什么

Dataset是一个强类型的特定领域的对象,这种对象可以函数式或者关系操作并行地转换。

从Spark 2.0开始,DataFrame与Dataset合并,每个Dataset也有一个被称为一个DataFrame的类型化视图,这种DataFrame是Row类型的Dataset,即Dataset[Row]。

Dataset API是DataFrames的扩展,它提供了一种类型安全的,面向对象的编程接口。它是一个强类型,不可变的对象集合,映射到关系模式。在数据集的核心 API是一个称为编码器的新概念,它负责在JVM对象和表格表示之间进行转换。表格表示使用Spark内部Tungsten二进制格式存储,允许对序列化数据进行操作并提高内存利用率。Spark 1.6支持自动生成各种类型的编码器,包括基本类型(例如String,Integer,Long),Scala案例类和Java Bean。

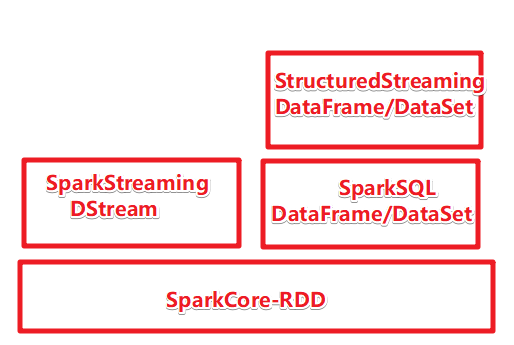

Spark 框架从最初的数据结构RDD、到SparkSQL中针对结构化数据封装的数据结构DataFrame,最终使用Dataset数据集进行封装,发展流程如下。

所以在实际项目中建议使用Dataset进行数据封装,数据分析性能和数据存储更加好。

5.2.3 RDD、DataFrame和DataSet

SparkSQL中常见面试题:如何理解Spark中三种数据结构RDD、DataFrame和Dataset关系?

第一、数据结构RDD:

RDD(Resilient Distributed Datasets)叫做弹性分布式数据集,是Spark中最基本的数据抽象,源码中是一个抽象类,代表一个不可变、可分区、里面的元素可并行计算的集合。

编译时类型安全,但是无论是集群间的通信,还是IO操作都需要对对象的结构和数据进行序列化和反序列化,还存在较大的GC的性能开销,会频繁的创建和销毁对象。

第二、数据结构DataFrame:

与RDD类似,DataFrame是一个分布式数据容器,不过它更像数据库中的二维表格,除了数据之外,还记录这数据的结构信息(即schema)。

DataFrame也是懒执行的,性能上要比RDD高(主要因为执行计划得到了优化)。

由于DataFrame每一行的数据结构一样,且存在schema中,Spark通过schema就能读懂数据,因此在通信和IO时只需要序列化和反序列化数据,而结构部分不用。

Spark能够以二进制的形式序列化数据到JVM堆以外(off-heap:非堆)的内存,这些内存直接受操作系统管理,也就不再受JVM的限制和GC的困扰了。但是DataFrame不是类型安全的。

第三、数据结构Dataset:

Dataset是DataFrame API的一个扩展,是Spark最新的数据抽象,结合了RDD和DataFrame的优点。

DataFrame=Dataset[Row](Row表示表结构信息的类型),DataFrame只知道字段,但是不知道字段类型,而Dataset是强类型的,不仅仅知道字段,而且知道字段类型。

样例类CaseClass被用来在Dataset中定义数据的结构信息,样例类中的每个属性名称直接对应到Dataset中的字段名称。

Dataset具有类型安全检查,也具有DataFrame的查询优化特性,还支持编解码器,当需要访问非堆上的数据时可以避免反序列化整个对象,提高了效率。

5.2.4 入门案例 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 object SparkSQLDemo01_hello {"hello" ).master("local[*]" ).getOrCreate()"WARN" )"data/input/person.json" )"name" ).show(3)* * -- age: long (nullable = true) |-- hobby: string (nullable = true) |-- name: string (nullable = true) +---+----------+-------+ |age |hobby |name |23 |running |json |32 |basketball |charles |28 |football |tom | name | json |charles | tom |* /

5.3 RDD、DF、DS相关操作

实际项目开发中,往往需要将RDD数据集转换为DataFrame,本质上就是给RDD加上Schema信息,官方提供两种方式:类型推断和自定义Schema。

官方文档:http://spark.apache.org/docs/2.4.5/sql-getting-started.html#interoperating-with-rdds

5.3.1 获取DataFrame/DataSet 5.3.1.1 使用样例类 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 object SparkSQLDemo02_CreateDFDS {"hello" ).master("local[*]" ).getOrCreate()"WARN" )"data/input/person.txt" )" " )* * -- id: integer (nullable = false) |-- name: string (nullable = true) |-- age: integer (nullable = false) +---+--------+---+ | id | name |age | 1 |zhangsan | 20 | 2 | lisi | 29 | 3 | wangwu | 25 | 4 | zhaoliu | 30 | 5 | tianqi | 35 | 6 | kobe | 40 |-- id: integer (nullable = false) |-- name: string (nullable = true) |-- age: integer (nullable = false) +---+--------+---+ | id | name |age | 1 |zhangsan | 20 | 2 | lisi | 29 | 3 | wangwu | 25 | 4 | zhaoliu | 30 | 5 | tianqi | 35 | 6 | kobe | 40 |* /

5.3.1.2 指定类型+列名 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 object SparkSQLDemo02_CreateDFDS2 {"hello" ).master("local[*]" ).getOrCreate()"WARN" )"data/input/person.txt" )" " )"id" ,"name" ,"age" )* * -- id: integer (nullable = false) |-- name: string (nullable = true) |-- age: integer (nullable = false) +---+--------+---+ | id | name |age | 1 |zhangsan | 20 | 2 | lisi | 29 | 3 | wangwu | 25 | 4 | zhaoliu | 30 | 5 | tianqi | 35 | 6 | kobe | 40 |* /

5.3.1.3 自定义Schema 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 object SparkSQLDemo02_CreateDFDS3 {"hello" ).master("local[*]" ).getOrCreate()"WARN" )"data/input/person.txt" )" " )* val schema: StructType = StructType("id" , IntegerType, true) ::"name" , StringType, true) ::"age" , IntegerType, true) :: Nil)* /"id" , IntegerType, true),"name" , StringType, true),"age" , IntegerType, true)* * -- id: integer (nullable = true) |-- name: string (nullable = true) |-- age: integer (nullable = true) +---+--------+---+ | id | name |age | 1 |zhangsan | 20 | 2 | lisi | 29 | 3 | wangwu | 25 | 4 | zhaoliu | 30 | 5 | tianqi | 35 | 6 | kobe | 40 |* /

5.3.2 RDD、DF、DS相互转换 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 object SparkSQLDemo03_Transformation {"hello" ).master("local[*]" ).getOrCreate()"WARN" )"data/input/person.txt" )" " )* * -- id: integer (nullable = false) |-- name: string (nullable = true) |-- age: integer (nullable = false) +---+--------+---+ | id | name |age | 1 |zhangsan | 20 | 2 | lisi | 29 | 3 | wangwu | 25 | 4 | zhaoliu | 30 | 5 | tianqi | 35 | 6 | kobe | 40 |-- id: integer (nullable = false) |-- name: string (nullable = true) |-- age: integer (nullable = false) +---+--------+---+ | id | name |age | 1 |zhangsan | 20 | 2 | lisi | 29 | 3 | wangwu | 25 | 4 | zhaoliu | 30 | 5 | tianqi | 35 | 6 | kobe | 40 |* /

5.4 SparkSQL数据处理分析

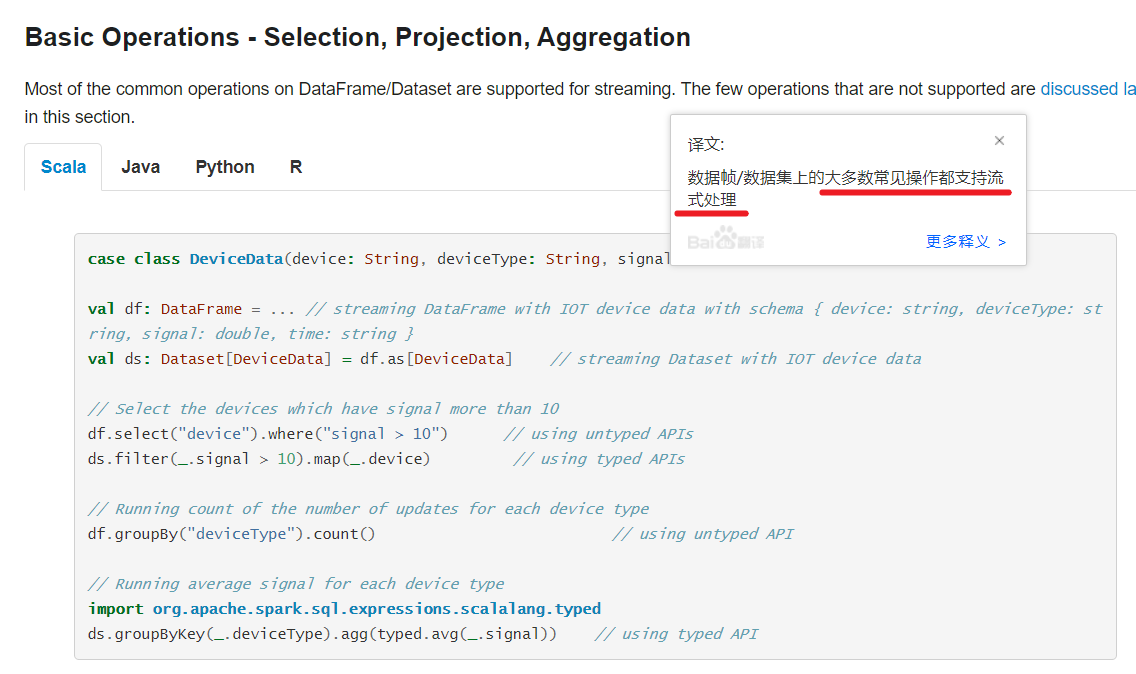

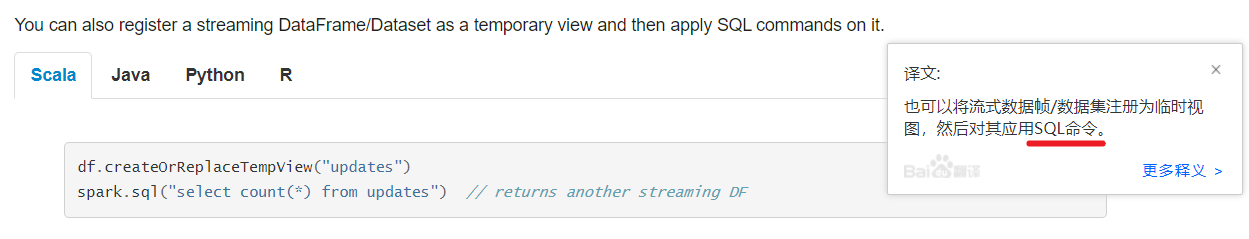

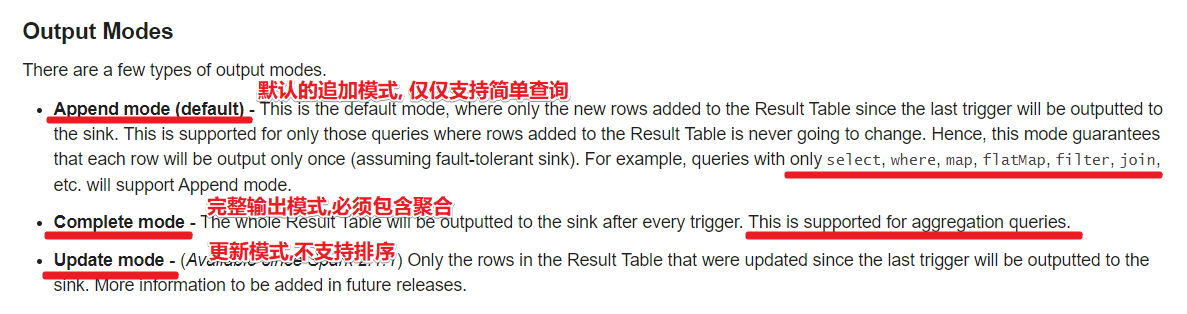

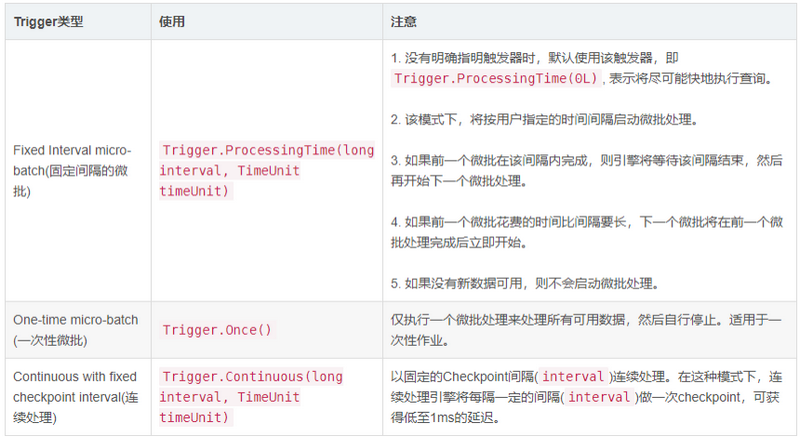

在SparkSQL模块中,将结构化数据封装到DataFrame或Dataset集合中后,提供两种方式分析处理数据,正如前面案例【词频统计WordCount】两种方式:

第一种:DSL(domain-specific language)编程,调用DataFrame/Dataset API(函数),类似RDD中函数;

第二种:SQL 编程,将DataFrame/Dataset注册为临时视图或表,编写SQL语句,类似HiveQL;

两种方式底层转换为RDD操作,包括性能优化完全一致,在实际项目中语句不通的习惯及业务灵活选择。比如机器学习相关特征数据处理,习惯使用DSL编程;比如数据仓库中数据ETL和报表分析,习惯使用SQL编程。无论哪种方式,都是相通的,必须灵活使用掌握。

5.4.1 案例一 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 object SparkSQLDemo04_FlowerQuery {Array [String]): Unit = {1. 准备SparkSQL开发环境2. 获取RDDline => {Array [String] = line .split(" ")0 ).toInt, arr(1 ), arr(2 ).toInt)3. RDD->DataFrameimport spark.implicits._ //隐式转换4. 输出约束和类型show ()-1. 注册表-2. 各种查询1. 查看name 字段的数据sql ("select name from t_person").show (false )2. 查看 name 和age字段数据sql ("select name,age from t_person").show (false )3. 查询所有的name 和age,并将age+1 sql ("select name,age,age+1 from t_person").show (false )4. 过滤age大于等于25 的sql ("select id,name,age from t_person where age >= 25").show (false )5. 统计年龄大于30 的人数sql ("select count(*) from t_person where age > 30").show (false )6. 按年龄进行分组并统计相同年龄的人数sql ("select age,count(*) from t_person group by age").show (false )7. 查询姓名=张三的name = "zhangsan"sql ("select id,name,age from t_person where name='zhangsan'").show (false )sql (s"select id,name,age from t_person where name='${name}'").show (false )1. 查看name 字段的数据select (df.col("name")).show (false )import org.apache.spark.sql .functions ._select (col("name")).show (false )select ("name").show (false )2. 查看 name 和age字段数据select ("name", "age").show (false )3. 查询所有的name 和age,并将age+1 select ("name","age","age+1").show (false )//报错:没有"age+1"这个列名select ("name","age","age"+1 ).show (false )//报错:没有"age+1"这个列名select ($"name", $"age", $"age" + 1 ).show (false ) //$"age"表示获取该列的值/$"列名"表示将该列名字符串转为列对象select ('name, ' age, 'age + 1).show(false) //' 列名表示将该列名字符串转为列对象4. 过滤age大于等于25 的filter ("age >= 25").show (false )where ("age >= 25").show (false )5. 统计年龄大于30 的人数filter ("age > 30").count()6. 按年龄进行分组并统计相同年龄的人数show (false )7. 查询姓名=张三的filter ("name ='zhangsan'").show (false )where ("name ='zhangsan'").show (false )filter ($"name" === "zhangsan").show (false )filter ('name === "zhangsan").show(false) //=8.查询姓名!=张三的 df.filter($"name" =!= name).show(false) df.filter(' name =!= "zhangsan").show (false )5. 关闭资源case class Person(id: Int , name : String, age: Int )

5.4.2 案例二:WordCount 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 object SparkSQLDemo05_WordCount def main Array [String ]): Unit = {val spark: SparkSession = SparkSession .builder().appName("hello" ).master("local[*]" ).getOrCreate()val sc: SparkContext = spark.sparkContext"WARN" )import spark.implicits._val fileRDD: RDD [String ] = sc.textFile("data/input/words.txt" )val df: DataFrame = fileRDD.toDF("value" )val ds: Dataset [String ] = df.as[String ]false )false )val df2: DataFrame = spark.read.text("data/input/words.txt" )false )val ds2: Dataset [String ] = spark.read.textFile("data/input/words.txt" )false )val wordDS: Dataset [String ] = ds.flatMap(_.split(" " ))false )"t_words" )val sql: String =""" |select value as word,count(*) as counts |from t_words |group by word |order by counts desc |""" .stripMarginfalse )"value" )'count .desc)false )case class Person (id: Int , name: String , age: Int )}

5.4.3 案例三:电影评分数据分析

数据

196 242 3 881250949 186 302 3 891717742 22 377 1 878887116 244 51 2 880606923 166 346 1 886397596 298 474 4 884182806 115 265 2 881171488 253 465 5 891628467 305 451 3 886324817 6 86 3 883603013 62 257 2 879372434 286 1014 5 879781125

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 object SparkSQLDemo06_MovieTop10 def main Array [String ]): Unit = {val spark: SparkSession = SparkSession .builder().appName("hello" ).master("local[*]" ).getOrCreate()val sc: SparkContext = spark.sparkContext"WARN" )import spark.implicits._val fileDS: Dataset [String ] = spark.read.textFile("data/input/rating_100k.data" )val rowDS: Dataset [(Int , Int )] = fileDS.map(line => {val arr: Array [String ] = line.split("\t" )1 ).toInt, arr(2 ).toInt)val cleanDF: DataFrame = rowDS.toDF("mid" ,"score" )false )"t_scores" )val sql:String =""" |select mid, round(avg(score),2) avg,count(*) counts |from t_scores |group by mid |having counts > 200 |order by avg desc,counts desc |limit 10 |""" .stripMarginfalse )import org.apache.spark.sql.functions._"mid" )'score ),2 ) as "avg" ,'mid ) as "counts" 'avg .desc,'counts .desc)'counts > 200 )10 )false )

5.5 自定义UDF函数

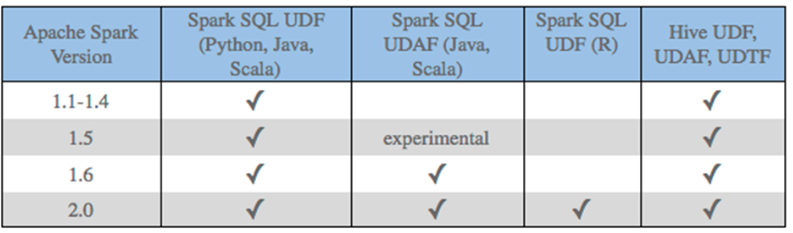

无论Hive还是SparkSQL分析处理数据时,往往需要使用函数,SparkSQL模块本身自带很多实现公共功能的函数,在org.apache.spark.sql.functions中。SparkSQL与Hive一样支持定义函数:UDF和UDAF,尤其是UDF函数在实际项目中使用最为广泛。

回顾Hive中自定义函数有三种类型:

第一种:UDF(User-Defined-Function) 函数

一对一的关系,输入一个值经过函数以后输出一个值;

在Hive中继承UDF类,方法名称为evaluate,返回值不能为void,其实就是实现一个方法;

第二种:UDAF(User-Defined Aggregation Function) 聚合函数

多对一的关系,输入多个值输出一个值,通常与groupBy联合使用;

第三种:UDTF(User-Defined Table-Generating Functions) 函数

一对多的关系,输入一个值输出多个值(一行变为多行);

用户自定义生成函数,有点像flatMap;

注意

目前来说Spark 框架各个版本及各种语言对自定义函数的支持:

在SparkSQL中,目前仅仅支持UDF函数和UDAF函数:

UDF函数:一对一关系;UDAF函数:聚合函数,通常与group by 分组函数连用,多对一关系;

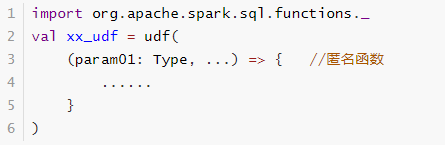

由于SparkSQL数据分析有两种方式:DSL编程和SQL编程,所以定义UDF函数也有两种方式,不同方式可以在不同分析中使用。

SQL方式 :使用SparkSession中udf方法定义和注册函数,在SQL中使用,使用如下方式定义:

DSL方式 :使用org.apache.sql.functions.udf函数定义和注册函数,在DSL中使用,如下方式:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 object SparkSQLDemo08_UDF {Array [String ]): Unit = {val spark: SparkSession = SparkSession .builder().appName("hello" ).master("local[*]" ).getOrCreate()val sc: SparkContext = spark.sparkContext"WARN" )val df: DataFrame = spark.read.text("data/input/udf.txt" )false )"small2big" ,(value:String )=>{"t_words" )val sql =""" |select value,small2big(value) big_value |from t_words |""" .stripMarginfalse )val small2big2 = udf((value:String )=>{'value,small2big2(' value).as ("big_value2" )).show(false )

5.6 External DataSource 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 object SparkSQLDemo07_datasource {main (args: Array[String]): Unit = {1 .准备SparkSQL开发环境builder ().appName ("hello" ).master ("local[*]" ).getOrCreate ()setLogLevel ("WARN" )1 :RDD-->DF/DS:兼容之前的RDD的项目2 :直接读取为DF/DS:优先考虑使用,支持多种数据源/数据格式:json/csv/parquet/jdbc....2 .准备一个DFtextFile ("data/input/person.txt" )map (line => {split (" " )Person (arr (0 ).toInt, arr (1 ), arr (2 ).toInt).implicits ._ //隐式转换toDF ()printSchema ()show (false)3 .写coalesce (1 ).write.mode (SaveMode.Overwrite)text ("data/output/text" )//注意:往普通文件写不支持Schemacoalesce (1 ).write.mode (SaveMode.Overwrite)json ("data/output/json" )coalesce (1 ).write.mode (SaveMode.Overwrite)csv ("data/output/csv" )coalesce (1 ).write.mode (SaveMode.Overwrite)parquet ("data/output/parquet" )Properties ()setProperty ("user" ,"root" )setProperty ("password" ,"123456" )coalesce (1 ).write.mode (SaveMode.Overwrite)jdbc ("jdbc:mysql://192.168.88.161:3306/bigdata?characterEncoding=UTF-8" ,"person" ,prop)//表会自动创建4 .读text ("data/output/text" ).show (false)json ("data/output/json" ).show (false)csv ("data/output/csv" ).toDF ("id1" ,"name1" ,"age1" ).show (false)parquet ("data/output/parquet" ).show (false)jdbc ("jdbc:mysql://192.168.88.161:3306/bigdata?characterEncoding=UTF-8" ,"person" ,prop).show (false)5 .关闭资源stop ()stop ()

5.7 Spark On Hive

Spark SQL模块从发展来说,从Apache Hive框架而来,发展历程:Hive(MapReduce)-> Shark (Hive on Spark) -> Spark SQL(SchemaRDD -> DataFrame -> Dataset),所以SparkSQL天然无缝集成Hive,可以加载Hive表数据进行分析。

http://spark.apache.org/docs/latest/sql-data-sources-hive-tables.html

5.7.1 HiveOnSpark和SparkOnHive

HiveOnSpark:SparkSql诞生之前的Shark项目使用的,是把Hive的执行引擎换成Spark,剩下的使用Hive的,严重依赖Hive,早就淘汰了没有人用了

SparkOnHive:SparkSQL诞生之后,Spark提出的,是仅仅使用Hive的元数据(库/表/字段/位置等信息…),剩下的用SparkSQL的,如:执行引擎,语法解析,物理执行计划,SQL优化

5.7.2 SparkOnHive如何On 5.7.2.1 命令行整合

1.启动Hive的元数据库服务

nohup /export/ servers// hive/bin/ hive --service metastore &

2.告诉SparkSQL:Hive的元数据库在哪里

要在哪一台机器上使用SparkOnHive就把配置文件放到哪台

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 cd /export/servers//spark/conf/<?xml version="1.0"?> <?xml-stylesheet type="text/xsl" href="configuration.xsl"?> <configuration > <property > <name > hive.metastore.warehouse.dir</name > <value > /user/hive/warehouse</value > </property > <property > <name > hive.metastore.local</name > <value > false</value > </property > <property > <name > hive.metastore.uris</name > <value > thrift://node3:9083</value > </property > </configuration >

也可以将hive-site.xml分发到集群中所有Spark的conf目录,此时任意机器启动应用都可以访问Hive表数据。

scp -r /export/ servers// spark/conf/ hive-site.xml root@node2:$PWD /export/ servers// spark/conf/ hive-site.xml root@node3:$PWD

3.使用sparksql操作hive

启动spark-sql命令行

/export/servers//spark/bin/spark-sql show database ;show tables ;CREATE TABLE person3 (id int , name string, age int ) row format delimited fields terminated by ' ' ;LOAD DATA LOCAL INPATH 'file:///root/person.txt' INTO TABLE person3;show tables ;select * from person3;

vim /root/person.txt1 zhangsan 20 2 lisi 29 3 wangwu 25 4 zhaoliu 30 5 tianqi 35 6 kobe 40

5.7.2.2 代码中整合

开启hive元数据库

nohup /export/ servers// hive/bin/ hive --service metastore &

pom

<dependency > <groupId > org.apache.spark</groupId > <artifactId > spark-hive_2.11</artifactId > <version > $ {spark.version} </version > </dependency > <dependency > <groupId > org.apache.spark</groupId > <artifactId > spark-hive-thriftserver_2.11</artifactId > <version > $ {spark.version} </version > </dependency >

在代码中告诉SparkSQL:Hive的元数据服务的配置

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 object SparkSQLDemo09_SparkOnHive {Array [String]): Unit = {1. 准备SparkSQL开发环境200 ,本地测试给少一点import org.apache.spark.sql .functions ._import spark.implicits._2. 执行Hive-SQL show database ;show tables ;CREATE TABLE person3 (id int , name string, age int ) row format delimited fields terminated by ' ' ;LOAD DATA LOCAL INPATH 'file:///root/person.txt' INTO TABLE person3;show tables ;select * from person;sql ("show databases").show (false )sql ("show tables").show (false )sql ("CREATE TABLE person6 (id int, name string, age int) row format delimited fields terminated by ' '")sql ("LOAD DATA LOCAL INPATH 'file:///D:/person.txt' INTO TABLE person5")sql ("show tables").show (false )sql ("select * from person5").show (false )5. 关闭资源

5.8 分布式SQL引擎

Hive或SparkSQL在企业中应该是作为一个分布式SQL执行/查询引擎存在的!

回忆之前Hive的访问方式:

通过Hive命令行访问: /export/servers//hive/bin/hive

启动HiveServer2/thriftserver使用beeline访问:

SparkSQL访问

SparkSQL命令行

SparkSQL代码中访问

启动sparkSQL的thriftserver使用beeline访问

使用JDBC协议访问

5.8.1 通过thriftServer+beeline访问

1.启动SaprkSQL的thriftserver--类似与Hive的HiveServer2

node1上启动

/export/servers.server2 .thrift .port=10000 \.server2 .thrift .bind .host=node1 \[2]

在实际大数据分析项目中,使用SparkSQL时,往往启动一个ThriftServer服务,分配较多资源(Executor数目和内存、CPU),不同的用户启动beeline客户端连接,编写SQL语句分析数据。

停止使用:

/export/ servers// spark/sbin/ stop-thriftserver.sh

监控WEB UI界面:http://node1:4040/jobs/

2.启动beeline,所有机器都可以

/export/ servers// spark/bin/ beeline

3.连接SaprkSQL的thriftserver

/export/ servers// spark/bin/ beeline// node1:10000 123456

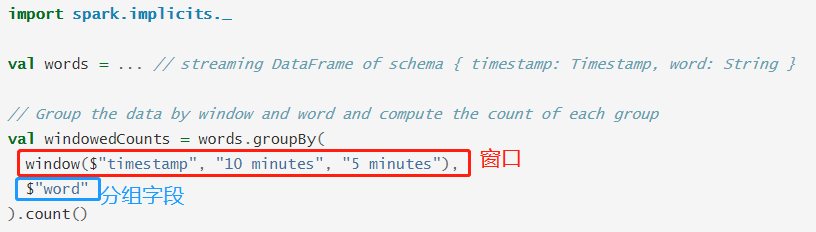

4.执行sql